从零开始学深度学习 长短记忆

- 行业动态

- 2025-04-07

- 4

在深度学习的广阔领域中,长短时记忆网络(LSTM)是一种极为重要的循环神经网络(RNN)变体,以下是关于从零开始学习深度学习中的长短时记忆网络的详细解析:

1、基础概念

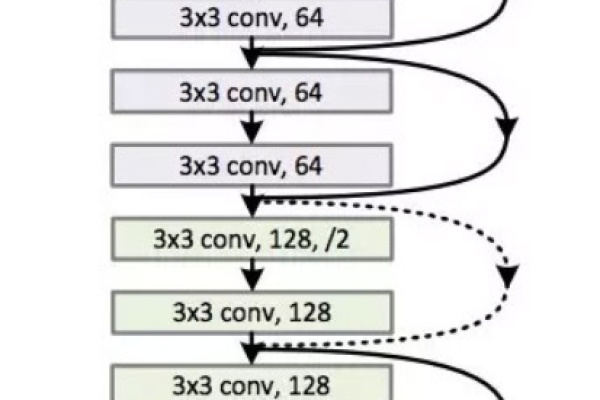

循环神经网络(RNN):RNN是一种专门用于处理序列数据的神经网络结构,它能够在序列的演进方向上进行递归,并通过所有节点(循环单元)的链式连接来捕捉序列中的时序信息和语义信息,传统的RNN存在梯度消失和梯度爆炸的问题,这使得它在处理长序列数据时表现不佳。

长短时记忆网络(LSTM):LSTM是RNN的一种改进模型,旨在解决传统RNN在处理长序列时出现的梯度消失和梯度爆炸问题,它通过引入三个门控单元(遗忘门、输入门和输出门)以及一个细胞状态来控制信息的流动和存储,从而能够有效地捕捉长期依赖关系。

2、关键组件

细胞状态:细胞状态类似于计算机中的内存,它贯穿整个LSTM网络,用于保存和更新网络学到的信息,细胞状态允许信息在序列中持续存在,从而有助于捕获长期依赖关系。

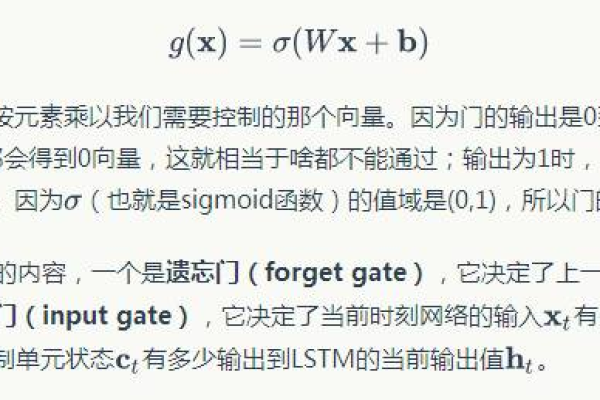

遗忘门:遗忘门决定当前细胞状态应丢弃哪些信息,它接收上一时刻的隐藏状态和当前时刻的输入,并通过sigmoid函数输出一个0到1之间的数值,这个数值表示遗忘的程度,其中0表示完全保留,1表示完全遗忘。

输入门:输入门决定当前细胞状态应存储哪些新的信息,它同样接收上一时刻的隐藏状态和当前时刻的输入,并通过sigmoid函数输出一个0到1之间的数值,这个数值表示输入信息对细胞状态的更新程度。

输出门:输出门定义当前细胞状态的哪部分会输出,它基于当前细胞状态,并使用sigmoid函数确定输出的值,输出门的输出将作为当前时刻的隐藏状态,并与下一时刻的输入一起传递给下一个时间步。

3、训练过程

前向传播:在LSTM的前向传播过程中,输入序列按时间步逐一输入到网络中,对于每个时间步,输入门、遗忘门和输出门会根据当前的输入和上一时刻的隐藏状态计算出当前的细胞状态和隐藏状态,这些隐藏状态将作为输出传递给下一个时间步或用于最终的预测任务。

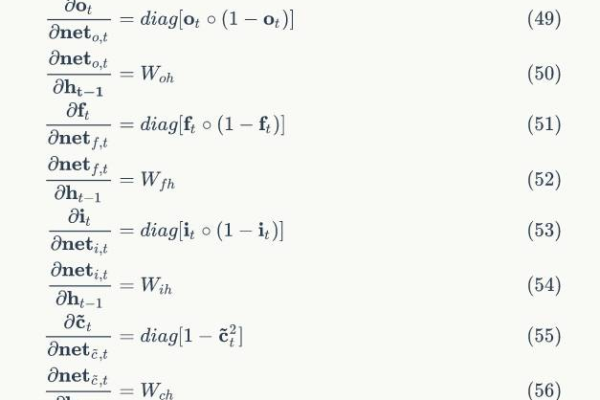

反向传播与参数更新:在完成前向传播后,网络会根据预测结果和真实标签计算损失函数(如交叉熵损失),通过网络的反向传播算法计算梯度,并根据这些梯度更新网络的权重参数,这个过程会重复多次,以优化网络的性能并最小化损失函数。

4、应用场景

自然语言处理:LSTM在自然语言处理领域有着广泛的应用,如机器翻译、文本生成、情感分析等,它能够捕捉文本中的长期依赖关系,从而提高模型的理解和生成能力。

语音识别:在语音识别任务中,LSTM能够处理音频信号中的时序信息,从而提高识别的准确性和鲁棒性。

时间序列预测:LSTM还可用于时间序列预测任务,如股票价格预测、气象预报等,它能够捕捉时间序列中的长期趋势和周期性变化,从而提供更准确的预测结果。

长短时记忆网络(LSTM)是深度学习中一种强大的循环神经网络变体,它通过引入门控机制和细胞状态来有效捕捉序列数据中的长期依赖关系,在实际应用中,LSTM展现出了广泛的适用性和卓越的性能,成为处理序列数据的优选模型之一。