从网页获取json数据库

- 行业动态

- 2025-04-07

- 2

在当今数字化时代,从网页获取JSON数据库已成为许多应用程序和业务流程中不可或缺的一部分,无论是为了数据分析、数据集成还是其他各种目的,能够有效地从网页抓取JSON格式的数据并将其存储到本地或云端的数据库中,都具有重要的实际意义,以下将详细介绍如何实现这一过程,包括所需的技术、步骤以及可能遇到的问题和解决方法。

一、相关技术介绍

1、HTTP请求

定义与原理:HTTP(超文本传输协议)是一种用于分布式、协作式和超媒体信息系统的应用层协议,在从网页获取JSON数据的情境下,通过发送HTTP请求到目标网页的服务器,服务器会根据请求返回相应的数据,常见的HTTP请求方法包括GET、POST等,使用GET请求可以向服务器请求特定的资源,服务器会以JSON格式返回数据。

应用场景:当我们需要从公开的API接口或者某些允许数据访问的网页获取JSON数据时,HTTP请求是关键的操作,从一个天气数据的API获取当前天气状况的JSON数据,就可以通过向该API发送HTTP GET请求实现。

2、网络爬虫技术

定义与原理:网络爬虫是一种按照一定的规则,自动地抓取互联网信息的程序,它可以模拟浏览器的行为,访问网页并解析网页内容,对于从网页获取JSON数据库来说,如果目标网页没有提供直接的API接口获取JSON数据,但网页本身包含以JSON格式呈现的数据(可能是通过JavaScript动态加载的),就需要借助网络爬虫技术来提取这些数据。

应用场景:在一些情况下,某些网站可能没有官方的API供用户获取数据,但网页上显示的数据是我们所需要的,一些电商网站上的商品信息可能以JSON格式嵌入在网页代码中,此时可以使用网络爬虫来解析网页并提取其中的JSON数据。

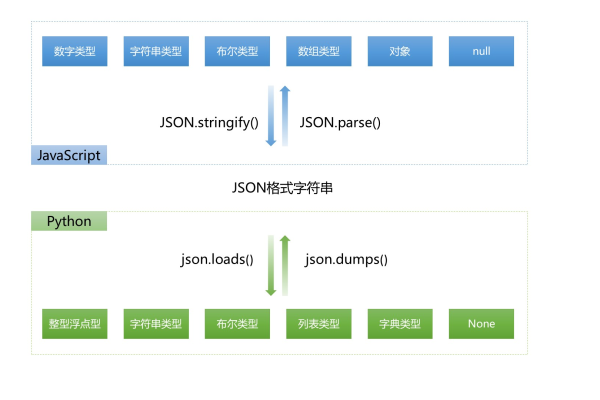

3、JSON解析

定义与原理:JSON(JavaScript对象表示法)是一种轻量级的数据交换格式,易于人阅读和编写,同时也易于机器解析和生成,JSON解析就是将获取到的JSON格式的字符串转换为程序中可以使用的数据结构(如字典、列表等),不同的编程语言都有相应的JSON解析库,例如在Python中可以使用json模块进行解析。

应用场景:当通过HTTP请求或网络爬虫获取到JSON格式的数据后,需要将其解析为可操作的数据结构,以便进一步处理和存储,将获取到的包含用户信息的JSON字符串解析为包含用户名、密码、邮箱等字段的字典。

二、具体步骤

1、确定目标网页和数据源

首先要明确从哪个网页获取JSON数据,这可能是一个提供公开API的网站,也可能是一个包含我们需要数据的普通网页,如果是API,需要查看其文档了解请求方式、参数和返回数据的格式;如果是普通网页,需要分析网页结构,确定JSON数据的位置和获取方式。

2、发送HTTP请求(如果有API)

使用合适的编程语言和库发送HTTP请求,以Python为例,可以使用requests库,以下是一个简单的示例代码:

import requests

url = "https://api.example.com/data"

response = requests.get(url)

if response.status_code == 200:

data = response.json()

print(data)

else:

print("Failed to retrieve data")

上述代码中,首先导入requests库,然后定义目标API的URL,使用requests.get()方法发送GET请求,如果响应状态码为200(表示成功),则使用response.json()方法将返回的JSON字符串解析为Python字典。

3、网络爬虫(如果没有API或需要从网页解析)

如果目标网页没有API,需要使用网络爬虫技术,以Python中的BeautifulSoup库为例,以下是一个简单的爬虫示例:

from bs4 import BeautifulSoup

import requests

url = "https://www.example.com"

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

假设JSON数据在一个<script>标签中,id为"data-script"

script_tag = soup.find('script', id='data-script')

json_data = script_tag.string

import json

data = json.loads(json_data)

print(data)

上述代码中,首先发送HTTP请求获取网页内容,然后使用BeautifulSoup解析网页HTML,找到包含JSON数据的<script>标签,提取其中的JSON字符串并进行解析。

4、数据存储到数据库

一旦获取并解析了JSON数据,就可以将其存储到数据库中,常见的数据库有MySQL、MongoDB等,以MongoDB为例,以下是一个简单的存储示例:

from pymongo import MongoClient

client = MongoClient('localhost', 27017)

db = client['mydatabase']

collection = db['mycollection']

data = {"name": "John", "age": 30}

collection.insert_one(data)

上述代码中,首先连接到本地运行的MongoDB数据库,选择数据库和集合,然后将解析后的数据插入到集合中。

三、可能遇到的问题及解决方法

1、目标网站限制访问

问题描述:有些网站可能会检测到频繁的请求或者非浏览器的正常访问行为,从而限制访问或者返回错误信息。

解决方法:可以设置合理的请求间隔时间,避免过于频繁的请求,可以在请求头中添加适当的信息,如模拟浏览器的用户代理字符串,使请求看起来更像是来自浏览器的正常访问。

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'}

response = requests.get(url, headers=headers)

2、JSON数据格式不规范

问题描述:有时候获取到的JSON数据可能存在格式错误,如缺少引号、括号不匹配等,导致无法正常解析。

解决方法:可以先对获取到的数据进行预处理,尝试修复一些常见的格式错误,使用正则表达式查找并添加缺失的引号或者括号,如果数据格式错误严重,可能需要联系数据提供方或者寻找其他可靠的数据源。

四、相关问答FAQs

1、从网页获取JSON数据库是否一定需要编写代码?

不一定,对于一些简单的场景和有特定工具支持的情况,可能不需要编写大量代码,一些可视化的数据采集工具可以帮助用户通过配置界面指定目标网页和要获取的数据字段,然后自动完成数据获取和简单的存储操作,对于复杂的网页结构和数据处理需求,编写代码通常是更灵活和高效的方法。

2、如何确保从网页获取JSON数据库的过程符合法律法规?

在从网页获取JSON数据库时,必须确保遵守相关的法律法规,要尊重目标网站的服务条款和隐私政策,如果网站明确禁止数据抓取或者对数据使用有限制,应该遵守这些规定,要注意数据的合法性和用途,不能将获取到的数据用于非规目的,如反面营销、侵犯他人隐私等,对于涉及个人敏感信息的数据,要特别谨慎处理,确保符合数据保护法规的要求。