如何管理WordPress网站的评论功能,开启还是关闭?

- 行业动态

- 2024-10-09

- 3

WordPress网站评论功能是增强用户互动和参与度的重要工具,通过允许用户对文章或页面发表意见和反馈,不仅可以增加网站的活跃度,还能提高用户粘性和SEO效果,有时为了管理方便或避免垃圾评论,管理员可能需要关闭或开启这一功能。

开启评论功能的方法

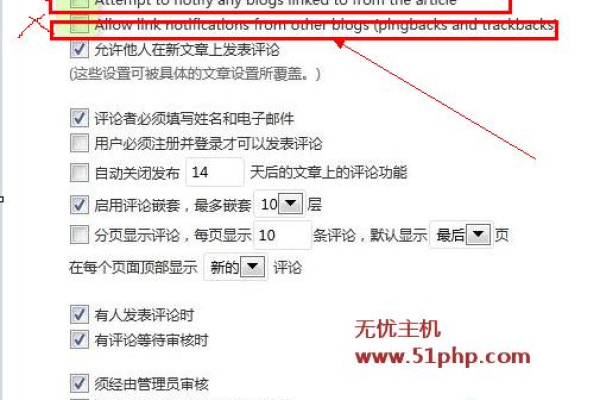

1、全局设置:在WordPress后台,导航到“设置” -> “讨论”,确保“允许人们发表新的文章的评论”选项被勾选,这样,所有新发布的文章默认都会开启评论功能。

2、单篇文章设置:在编辑文章时,可以在编辑器右侧的“讨论”框中勾选“允许评论”,以单独为该文章开启评论功能。

3、页面评论:默认情况下,WordPress只在文章上启用评论功能,如果希望在页面上也能启用评论,可以通过安装并激活“Comments on Pages”或“WP Page Comments”等插件来实现。

关闭评论功能的方法

1、全局关闭:同样在“设置” -> “讨论”中,取消勾选“允许人们发表新的文章的评论”选项,即可全局关闭评论功能。

2、单篇文章关闭:在编辑文章时,取消勾选“允许评论”选项,即可单独为该文章关闭评论功能。

3、特定页面关闭:对于通过插件启用评论功能的页面,可以在插件设置中选择关闭特定页面的评论。

审核评论

为了防止垃圾评论或不当言论,WordPress提供了评论审核功能,在“设置” -> “讨论”中,勾选“评论必须经人工批准显示”选项,即可要求所有评论在显示前都经过管理员的审核。

自定义和管理评论表单

除了默认的评论功能外,还可以通过安装插件如“WPForms”或“Contact Form 7”来自定义评论表单和管理方式,这些插件提供了更多的自定义选项和灵活性,可以根据网站的具体需求进行调整。

相关问题与解答

1、如何在WordPress评论中添加验证码?:可以安装一个验证码插件,如reCAPTCHA by BestWebSoft,在插件设置页面获取并输入reCAPTCHA站点密钥后启用评论表单中的验证码功能即可。

2、如何恢复被误删的评论?:删除的评论会存放在评论回收站中,可以从中恢复,如果回收站已清空且没有备份文件找回数据,则需联系网站主机提供商查看是否有服务器级别的备份可供恢复。

WordPress网站评论功能的开启与关闭是一个灵活且重要的管理选项,通过合理设置和使用相关插件及功能,可以有效提升网站的互动性和用户体验同时保持内容的健康和有序。

以上就是关于“WordPress网站评论功能如何开启或关闭”的问题,朋友们可以点击主页了解更多内容,希望可以够帮助大家!