阿里云网盘与相册开启了同步以后 , 网盘的已使用空间突然变大了是什么原因?

- 行业动态

- 2024-05-07

- 2

阿里云网盘与相册同步后,已使用空间突然变大的原因可能有以下几点:

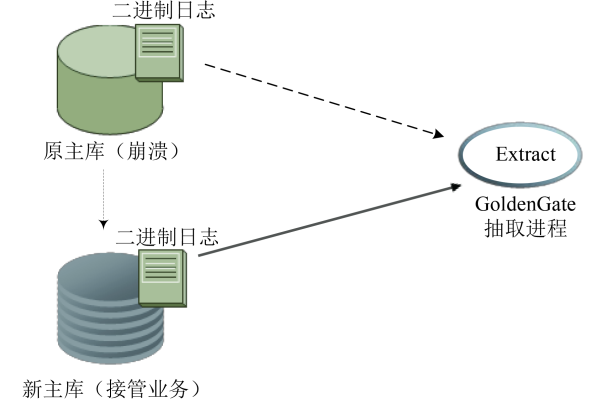

1、文件同步:当你开启阿里云网盘与相册的同步功能后,所有在相册中的图片都会被上传到阿里云网盘中,如果相册中的图片数量非常多,那么这些图片占用的空间就会使得网盘的已使用空间迅速增大。

2、文件大小:如果你的相册中有很多高清大图或者视频,那么这些文件的大小也会使得网盘的已使用空间增大,一张高清图片可能就有几百KB甚至几MB,一个高清视频可能就有几十MB甚至几GB。

3、文件格式:不同的文件格式,其占用的空间也是不同的,JPEG格式的图片通常比PNG格式的图片占用的空间要大,MP4格式的视频通常比FLV格式的视频占用的空间要大,如果你的相册中有很多大文件格式的图片或视频,那么网盘的已使用空间也会增大。

4、文件压缩:阿里云网盘提供了文件压缩的功能,可以有效地减小文件的大小,节省存储空间,如果你没有开启这个功能,那么所有的文件都会以原始的大小存储在网盘中,这也会导致网盘的已使用空间增大。

5、重复文件:如果你的相册中有很多重复的文件,那么这些重复的文件在同步到网盘后,会占用更多的空间,阿里云网盘提供了查找重复文件并删除的功能,可以帮助你节省存储空间。

6、自动备份:阿里云网盘还提供了自动备份的功能,可以定期将你的文件备份到云端,如果你的相册中的文件经常更新,那么这些更新的文件在备份后,也会占用更多的空间。

7、其他原因:除了以上的原因外,还有一些其他的原因可能会导致网盘的已使用空间增大,例如系统错误、网络问题等。

阿里云网盘与相册同步后,已使用空间突然变大的原因主要是文件的数量、大小和格式,如果你发现网盘的已使用空间过大,可以通过清理无用文件、压缩文件、删除重复文件等方式来节省存储空间。

FAQs

Q1: 为什么开启阿里云网盘与相册的同步功能后,网盘的已使用空间会突然变大?

A1: 当你开启阿里云网盘与相册的同步功能后,所有在相册中的图片都会被上传到阿里云网盘中,如果相册中的图片数量非常多,那么这些图片占用的空间就会使得网盘的已使用空间迅速增大,如果相册中的图片都是高清大图或者视频,那么这些文件的大小也会使得网盘的已使用空间增大。

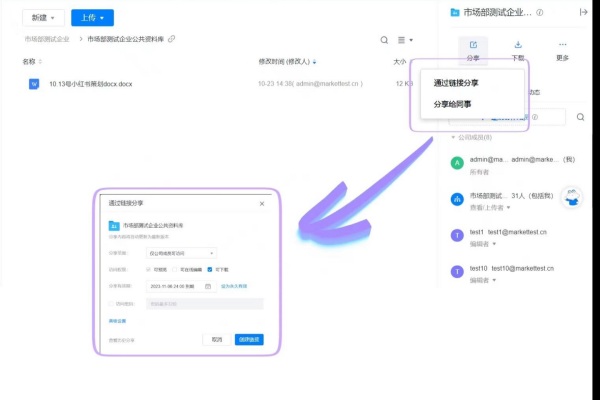

Q2: 如何查看阿里云网盘中哪些文件占用了最多的空间?

A2: 你可以在阿里云网盘的主界面上,点击“管理”按钮,然后选择“存储分析”,就可以看到哪些文件占用了最多的空间,你还可以选择“查找重复文件”,来找到并删除重复的文件,从而节省存储空间。