网站没有robots.txt如何解决

- 行业动态

- 2023-12-12

- 2

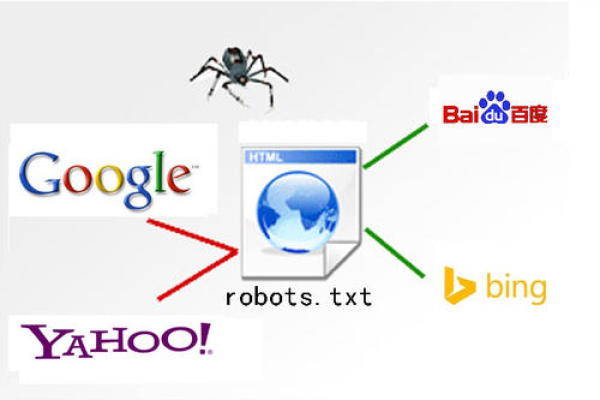

在互联网上,robots.txt文件是一个非常重要的文本文件,它可以告诉搜索引擎爬虫(也称为蜘蛛)哪些页面可以抓取,哪些页面不能抓取,这样可以有效地避免一些不必要的麻烦,例如网站被破解反面抓取、网站内容被错误地索引等,有时候我们可能会遇到一些没有robots.txt文件的网站,这对我们的搜索引擎优化(SEO)工作会产生一定的影响,面对这样的情况,我们应该如何解决呢?

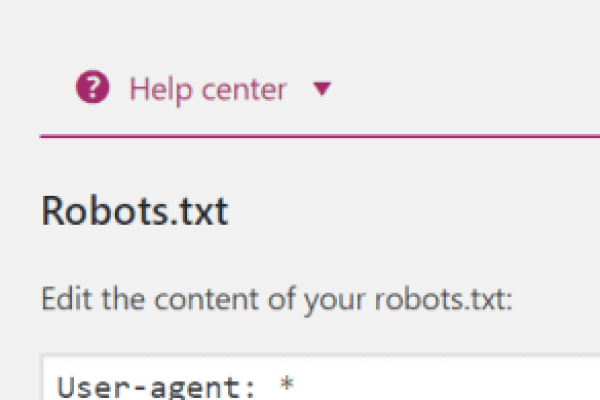

我们需要了解robots.txt文件的作用和规则,robots.txt文件的主要作用是指导搜索引擎爬虫如何抓取网站内容,它是一个纯文本文件,格式简单,通常以“User-agent: 用户代理”开头,后面跟着一系列的指令,这些指令可以用来限制爬虫的行为,例如允许或禁止抓取某个目录下的所有文件,或者只抓取特定的页面等,根据这些指令,搜索引擎爬虫会遵循相应的规则进行抓取。

当一个网站没有robots.txt文件时,我们可以从以下几个方面来解决这个问题:

1、分析网站的结构和内容,虽然没有robots.txt文件,但我们仍然可以通过分析网站的HTML代码、URL结构等信息,来判断哪些页面可以被抓取,哪些页面不能被抓取,如果一个网站的首页URL是一个相对路径,那么搜索引擎爬虫很可能会认为这个首页是可以被抓取的;而如果一个网站的登录页面URL是一个绝对路径,并且需要登录才能访问,那么搜索引擎爬虫可能就不会抓取这个页面。

2、使用第三方工具,有些第三方工具可以帮助我们分析网站的结构和内容,从而推测出哪些页面可以被抓取,哪些页面不能被抓取,一些网站结构分析工具可以帮助我们分析网站的导航结构、内部链接等信息,从而判断哪些页面是可以被抓取的,还有一些专门的robots.txt生成工具,可以帮助我们在没有robots.txt文件的情况下,自动生成一个合适的robots.txt文件。

3、与网站管理员沟通,如果我们对某个网站的结构和内容不是很了解,可以尝试与网站管理员沟通,询问他们关于robots.txt文件的问题,这样既可以获取到相关的信息,还可以建立良好的人际关系,为今后的工作打下基础。

4、采取适当的措施保护自己的网站,当一个网站没有robots.txt文件时,我们的网站可能会受到一些不必要的抓取和索引,为了保护自己的网站,我们可以采取以下措施:

a. 设置合理的robots.txt规则,即使没有robots.txt文件,我们也可以自己创建一个robots.txt文件,并设置合理的规则来限制搜索引擎爬虫的行为,我们可以规定搜索引擎爬虫不要抓取我们的登录页面、注册页面等敏感页面。

b. 对重要页面进行加密,对于一些重要的、不适合被搜索引擎抓取的页面,我们可以采用加密技术(如HTTPS)来保护它们的内容,这样一来,即使搜索引擎爬虫抓到了这些页面的内容,也无法直接查看和解析。

c. 定期检查网站日志,通过检查网站日志,我们可以发现是否有大量的搜索引擎爬虫在访问我们的网站,如果发现有异常情况,可以及时采取相应的措施进行处理。

当一个网站没有robots.txt文件时,我们可以从多个方面来解决这个问题,只要我们能够充分利用现有的信息和技术资源,相信一定能够找到合适的解决方案。

相关问题与解答:

1、robots.txt文件的作用是什么?

答:robots.txt文件的主要作用是指导搜索引擎爬虫如何抓取网站内容,它是一个纯文本文件,格式简单,通常以“User-agent: 用户代理”开头,后面跟着一系列的指令,这些指令可以用来限制爬虫的行为,例如允许或禁止抓取某个目录下的所有文件,或者只抓取特定的页面等,根据这些指令,搜索引擎爬虫会遵循相应的规则进行抓取。

2、如何分析一个没有robots.txt文件的网站?

答:虽然没有robots.txt文件,但我们仍然可以通过分析网站的HTML代码、URL结构等信息,来判断哪些页面可以被抓取,哪些页面不能被抓取,如果一个网站的首页URL是一个相对路径,那么搜索引擎爬虫很可能会认为这个首页是可以被抓取的;而如果一个网站的登录页面URL是一个绝对路径,并且需要登录才能访问,那么搜索引擎爬虫可能就不会抓取这个页面,还有一些第三方工具可以帮助我们分析网站的结构和内容,从而推测出哪些页面可以被抓取,哪些页面不能被抓取。

3、如果一个网站没有robots.txt文件,我们应该怎么办?

答:当一个网站没有robots.txt文件时,我们可以从以下几个方面来解决这个问题:1)分析网站的结构和内容;2)使用第三方工具;3)与网站管理员沟通;4)采取适当的措施保护自己的网站(如设置合理的robots.txt规则、对重要页面进行加密、定期检查网站日志等),只要我们能够充分利用现有的信息和技术资源,相信一定能够找到合适的解决方案。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/354980.html