diy 虚拟云桌面服务器

- 行业动态

- 2025-01-30

- 7

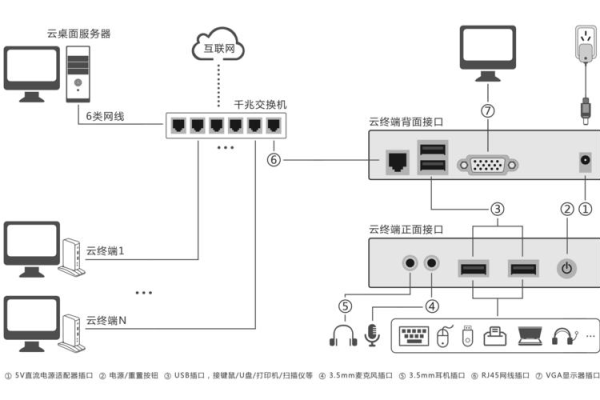

一、硬件准备

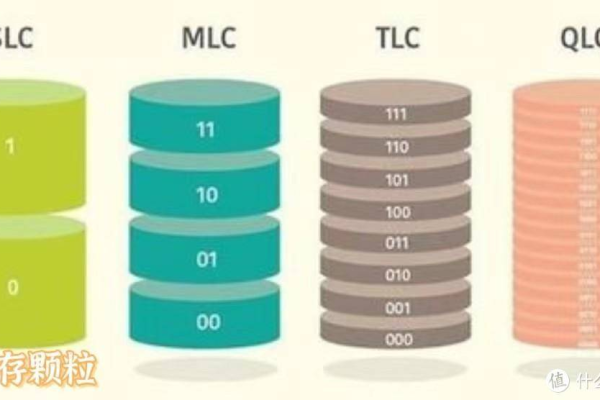

1、服务器主机:选择一台性能强大的服务器,具备足够的处理器核心数、大容量内存以及高速硬盘阵列,以满足多个用户同时访问的需求,可以选择带有多个处理器核心和64GB以上内存的服务器。

2、网络设备:确保服务器具有可靠的网络连接,配备高速网络交换机和路由器,以提供稳定的云桌面访问。

二、软件选择与安装

1、操作系统:常见的选择包括Windows Server和Linux发行版(如Ubuntu、CentOS等),根据个人喜好和需求进行选择,并按照要求进行安装和基本配置。

2、虚拟化软件:选择一种具备良好性能和管理功能的虚拟化软件,如VMware vSphere、Microsoft Hyper-V或Citrix XenServer等,将选定的虚拟化软件安装到服务器上,并按照软件提供的安装指南进行操作。

三、创建虚拟机

1、虚拟机模板:根据用户需求和操作系统版本,创建一个用于云桌面的虚拟机模板,该模板应包含操作系统、应用程序和设置等内容,通过复制该模板,可以快速创建新的云桌面。

2、虚拟机配置:在虚拟化软件中创建虚拟机,并为其分配适当的资源,如CPU核心数、内存大小、存储空间等,安装操作系统和必要的应用程序。

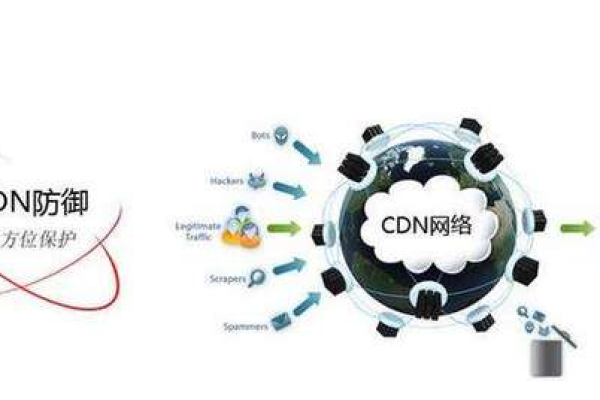

四、配置网络和安全

1、网络设置:为云桌面服务器配置网络接口、IP地址和域名等,确保用户能够通过网络连接到服务器,还需要配置防火墙规则和安全策略,以保护服务器的安全。

2、安全措施:实施适当的安全控制措施,如使用强密码、定期更新软件和操作系统、安装安全补丁、配置防火墙等,还可以考虑使用数据加密技术来保护用户数据的传输和存储。

五、用户管理与权限设置

1、用户账户创建:在云桌面服务器上创建用户账户,并为每个用户分配独立的用户名和密码。

2、权限分配:根据不同用户的需求和角色,设置不同的权限级别和访问规则,可以限制某些用户对特定资源的访问权限。

六、远程访问与监控

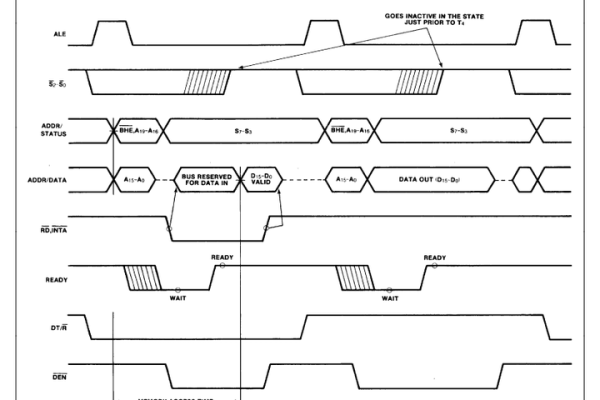

1、远程访问配置:配置远程桌面协议(如RDP或VNC),以便用户可以从任何地方通过互联网访问云桌面。

2、监控工具使用:使用监控工具来跟踪服务器的性能和资源利用率,及时发现和解决潜在的问题。

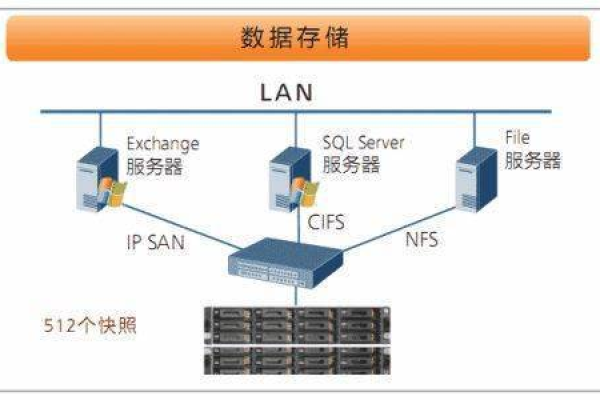

七、备份与恢复策略

1、数据备份:定期备份云桌面服务器的数据,以防止数据丢失和系统故障,可以使用自动备份工具或云存储服务来进行数据备份。

2、灾难恢复计划:制定灾难恢复计划,并测试恢复操作的有效性,确保在发生灾难时能够快速恢复云桌面服务器的运行。

八、性能优化与维护

1、性能监控:定期监控云桌面服务器的性能指标,如CPU使用率、内存占用率、网络带宽等,根据监控结果进行性能优化,如调整虚拟机的资源分配、升级硬件等。

2、软件更新:及时更新虚拟化软件、操作系统和应用程序的安全补丁和功能更新,以确保系统的稳定性和安全性。

九、常见问题解答

1、问:如何选择合适的虚拟化软件?

答:选择虚拟化软件时需要考虑多个因素,如性能、管理功能、兼容性、成本等,常见的虚拟化软件有VMware vSphere、Microsoft Hyper-V和Citrix XenServer等,建议根据自己的需求和预算选择合适的虚拟化软件。

2、问:如何确保云桌面服务器的安全性?

答:为了确保云桌面服务器的安全性,需要采取多种安全措施,如使用强密码、定期更新软件和操作系统、安装安全补丁、配置防火墙、使用数据加密技术等,还需要制定严格的安全策略和访问控制规则,限制非授权用户的访问。

十、小编有话说

搭建DIY虚拟云桌面服务器是一项复杂而有趣的任务,它不仅可以为用户提供灵活便捷的工作环境,还能提升企业的IT基础设施效率,这需要一定的技术基础和经验,如果您对技术不够熟悉或者没有足够的时间精力来搭建和维护云桌面服务器,也可以考虑使用专业的云服务提供商提供的云桌面解决方案。