从数据库收集统计数据

- 行业动态

- 2025-04-05

- 3

从数据库收集统计数据是一个复杂但至关重要的过程,它涉及多个步骤和考虑因素,以下是对这一过程的详细解释:

一、明确需求与目标

在开始从数据库收集统计数据之前,首先要明确需求和目标,这包括确定需要哪些数据、数据的类型、数据的来源以及数据的用途,如果是一家电商公司,可能需要收集关于销售额、客户购买行为、库存水平等方面的数据,这些数据将用于分析市场趋势、优化库存管理、提高客户满意度等。

二、选择合适的数据库

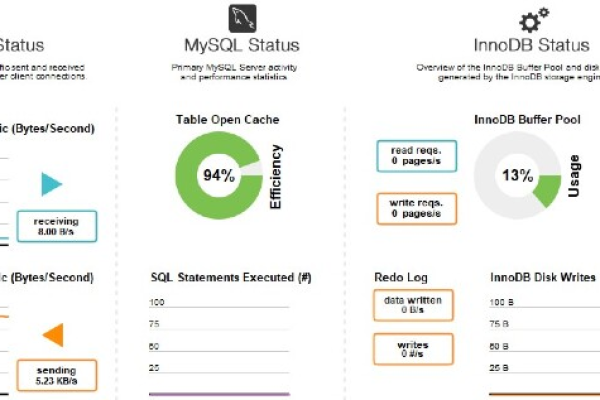

根据需求和目标,选择适合的数据库至关重要,常见的数据库类型包括关系型数据库(如MySQL、PostgreSQL)、非关系型数据库(如MongoDB、Cassandra)以及数据仓库(如Amazon Redshift、Google BigQuery),每种数据库都有其特点和适用场景,因此需要根据实际情况进行选择。

| 数据库类型 | 特点 | 适用场景 |

| 关系型数据库 | 数据结构化,支持复杂的SQL查询 | 适用于事务处理、数据分析等场景 |

| 非关系型数据库 | 灵活的数据模型,可扩展性强 | 适用于大数据处理、实时数据分析等场景 |

| 数据仓库 | 专为数据分析设计,支持高效的查询和聚合操作 | 适用于大规模数据分析、商业智能等场景 |

三、设计数据模型

一旦选择了合适的数据库,接下来就需要设计数据模型,数据模型定义了数据的结构、关系以及约束条件,是数据库设计的核心,在设计数据模型时,需要考虑数据的完整性、一致性以及性能等因素,通过合理的数据模型设计,可以确保数据的准确性和可靠性,同时提高查询效率。

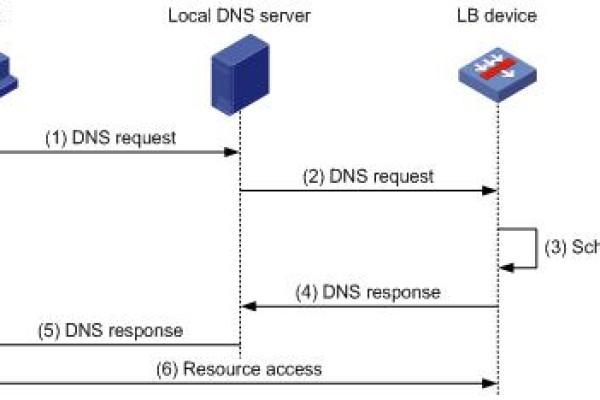

四、数据采集与导入

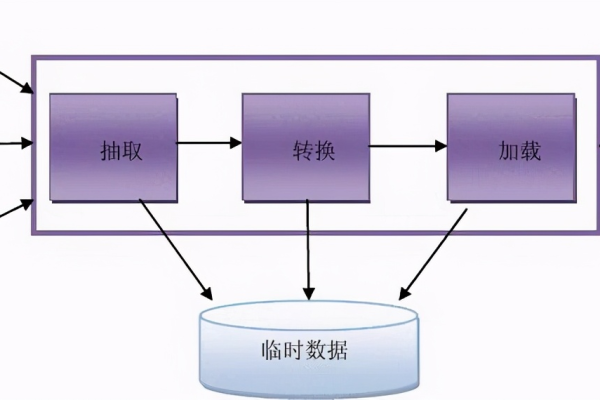

数据采集是从各种数据源(如日志文件、API接口、传感器等)获取数据的过程,采集到的数据需要经过清洗、转换和验证等步骤,以确保数据的质量,将清洗后的数据导入到数据库中,这一过程可以通过编写脚本或使用ETL(Extract, Transform, Load)工具来实现。

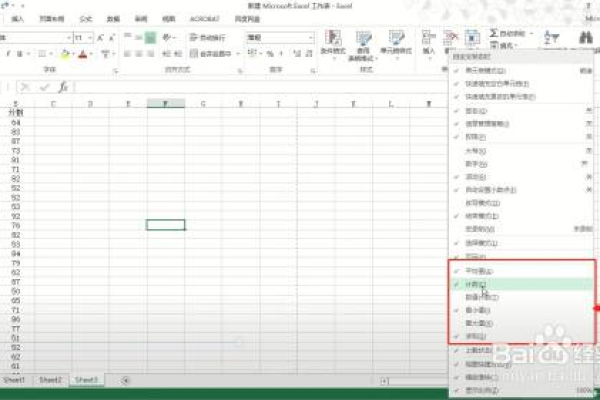

五、数据统计与分析

一旦数据被导入到数据库中,就可以开始进行数据统计和分析了,这通常涉及到执行SQL查询来提取所需的数据,并使用统计函数来计算各种指标(如平均值、中位数、标准差等),还可以使用数据分析工具(如Excel、Tableau、Python等)来可视化数据,以便更直观地理解数据和发现趋势。

六、持续监控与优化

从数据库收集统计数据是一个持续的过程,随着业务的发展,数据量可能会不断增加,因此需要定期监控数据库的性能并进行优化,这包括调整数据库配置、优化查询语句、添加索引等措施,以确保数据库能够高效地处理大量数据。

七、FAQs

Q1: 如何确保从数据库收集的统计数据的准确性?

A1: 确保数据准确性的关键步骤包括数据验证、去重、清洗以及定期审查数据质量,使用事务处理、外键约束和触发器等数据库功能可以帮助维护数据的一致性和完整性,实施数据治理策略,如数据标准化、元数据管理和数据质量监控,也是确保数据准确性的有效方法。

Q2: 当面对海量数据时,如何提高从数据库收集统计数据的效率?

A2: 面对海量数据,提高收集统计数据效率的方法包括使用分布式数据库系统、数据分片、建立合适的索引、优化查询语句以及采用并行处理技术,利用大数据处理框架(如Hadoop、Spark)和数据仓库技术也可以显著提高处理大规模数据的能力,定期对数据库进行性能分析和调优,以及采用缓存机制减少重复查询,都是提升效率的有效手段。

从数据库收集统计数据是一个涉及多个环节和技术的复杂过程,通过明确需求、选择合适的数据库、设计合理的数据模型、高效采集与导入数据、进行准确的统计与分析以及持续监控与优化,可以确保从数据库中收集到准确、有用的统计数据,为企业的决策提供有力支持。