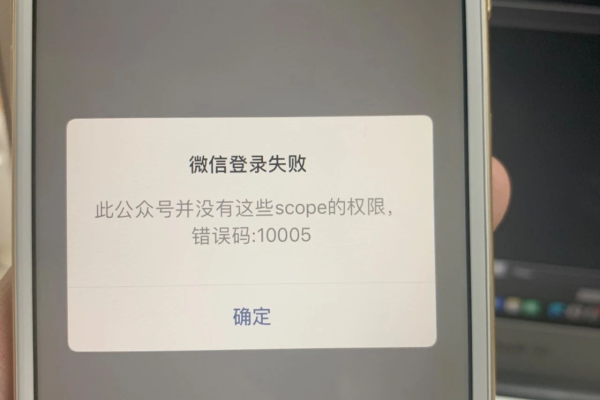

微信报错10005

- 行业动态

- 2024-03-02

- 2

微信出现10005报错,通常指网络连接问题或账号异常。建议检查网络后重新登录,若问题持续,可尝试联系客服或重启应用解决。

在使用微信的过程中,遇到报错代码10005是一个比较常见的问题,这个错误代码通常代表着微信客户端在尝试进行某些操作时,由于网络连接、服务器问题或客户端设置等原因,无法顺利完成,下面我将详细分析微信报错10005的原因及可能的解决方案。

微信报错10005可能是由以下几种原因导致的:

1、网络连接不稳定:在使用微信时,若网络连接不稳定或速度较慢,可能导致微信客户端无法与服务器正常通信,从而出现10005报错。

2、服务器问题:微信服务器可能会因为维护、故障等原因导致暂时无法提供服务,这时用户在尝试进行某些操作时,可能会遇到10005报错。

3、微信客户端版本问题:如果微信客户端版本过低,可能会导致兼容性问题,从而在使用过程中出现10005报错。

4、手机系统问题:手机系统版本过低或者系统设置问题,也可能导致微信出现10005报错。

5、账号问题:账号被封禁、异常或存在安全风险,也可能导致微信报错10005。

针对以上原因,我们可以尝试以下解决方案:

1、检查网络连接:请确保您的手机网络连接正常,您可以尝试切换到稳定的WiFi网络,或者在网络较好的环境下重新启动微信。

2、重启手机:手机系统资源占用过高或者后台运行程序过多,可能导致微信运行不稳定,重启手机可以清理系统资源,解决部分问题。

3、更新微信客户端:请前往应用商店检查微信客户端是否有更新,如有更新,请及时更新到最新版本。

4、清除微信缓存:进入微信设置,点击“通用”,然后选择“清理微信缓存”,清除缓存数据后重新启动微信。

5、检查手机系统设置:请确保手机系统版本在微信支持的范围内,并检查手机系统设置,如权限设置、网络设置等是否正常。

6、重新登录账号:尝试退出当前账号,然后重新登录,如果账号存在异常,请根据微信提示进行相应的操作,如解除封禁、修改密码等。

7、联系客服:如果以上方法都无法解决问题,您可以尝试联系微信客服,获取更详细的帮助。

需要注意的是,微信报错10005可能是由多种原因导致的,因此在解决问题时,请尝试多种方法,并结合自身情况进行排查。

以下是一些建议,以帮助您更好地使用微信,减少报错发生的概率:

1、保持手机系统更新,确保系统版本在微信支持的范围内。

2、使用稳定的网络连接,避免在信号差的环境下使用微信。

3、定期更新微信客户端,以获得最新的功能支持和优化。

4、不要使用第三方工具或修改微信客户端,以免造成兼容性问题。

5、注意账号安全,定期修改密码,不要轻易泄露个人信息。

6、遵守微信用户协议,避免发布违规内容,以免账号被封禁。

微信报错10005是一个常见的问题,但通过以上方法,相信您可以找到合适的解决方案,在使用微信的过程中,请保持耐心,并根据实际情况进行排查和解决问题,希望这篇文章能对您有所帮助。