DFS挂载文件存储HDFS

- 行业动态

- 2025-04-05

- 6

DFS(分布式文件系统)挂载HDFS(Hadoop分布式文件系统)是一种将远程HDFS中的文件系统挂载到本地文件系统的操作,使得用户可以像访问本地文件一样访问HDFS中的文件,以下是关于DFS挂载文件存储HDFS的详细解答:

一、前提条件

1、已创建文件系统和添加挂载点:在使用DFS挂载HDFS之前,需要确保已经在相应的云服务或集群管理平台上创建了文件系统,并为其添加了挂载点。

2、安装JDK:在Hadoop集群的所有节点上,都需要安装JDK,且版本不低于1.8,建议使用的JDK版本与Hadoop集群的版本兼容。

3、下载Hadoop源码包:需要下载与Hadoop集群版本相同的Hadoop源码包,以便后续编译和配置fuse-dfs工具。

二、配置步骤

1、配置core-site.xml:在Hadoop的配置文件中,找到并编辑core-site.xml文件,添加或修改以下配置项(具体配置可能因环境和需求而异):

<property>:<name>fs.defaultFS</name><value>hdfs://namenode:port</value>,其中namenode是NameNode的主机名,port是NameNode的端口号。

<property>:<name>hadoop.security.authentication</name><value>simple</value>(如果启用了Kerberos认证,则需要进行相应的Kerberos配置)。

2、编译fuse-dfs模块:由于官方提供的Hadoop预编译版本中通常不包含fuse-dfs功能模块,因此需要手动编译该模块,进入Hadoop源码目录,执行以下命令进行编译:

$ cd hadoop-src(假设Hadoop源码包解压后的目录为hadoop-src)。

$ mvn clean package -DskipTests -Pdist,native-win -pl hadoop-tools/hadoop-hdfs-project/hadoop-hdfs-rbf(对于Windows系统)或$ mvn clean package -DskipTests -Pdist,native -pl hadoop-tools/hadoop-hdfs-project/hadoop-hdfs-rbf(对于Linux系统)。

编译成功后,可以在hadoop-src/hadoop-dist/target/hadoop-.tar.gz目录下找到包含fuse-dfs模块的Hadoop发行版压缩包。

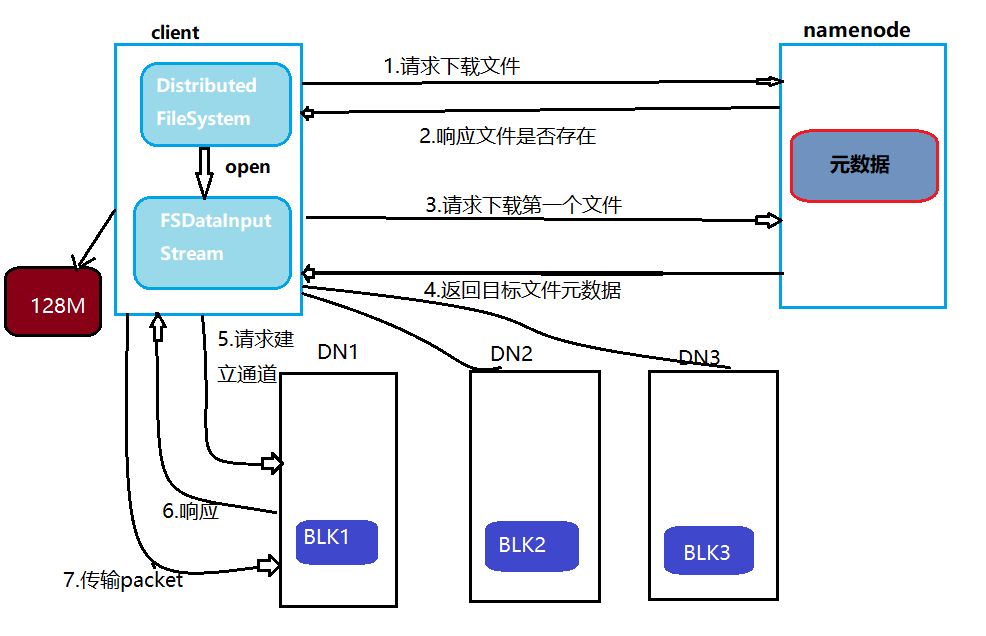

3、挂载HDFS:使用编译好的Hadoop发行版中的fuse-dfs工具进行挂载,执行以下命令:

$ hadoop fs -mount <挂载点> <HDFS路径>,其中<挂载点>是本地文件系统中的挂载点目录,<HDFS路径>是HDFS中的文件系统路径。

如果要将HDFS中的/user/hadoop/mydata目录挂载到本地的/mnt/hdfs目录,可以执行:$ hadoop fs -mount /mnt/hdfs hdfs://namenode:port/user/hadoop/mydata。

三、验证挂载结果

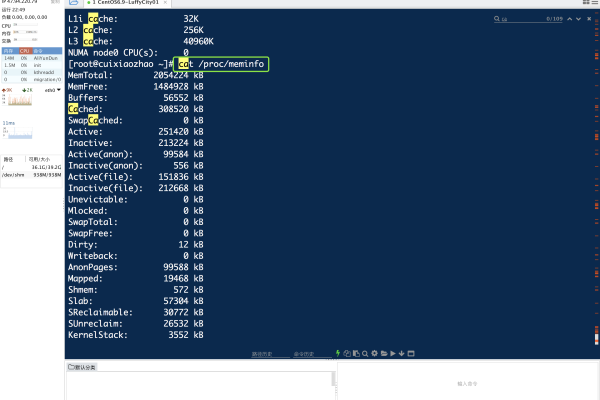

1、检查挂载状态:执行$ df -h命令,查看是否有新的文件系统挂载到本地,如果有,则说明挂载成功。

2、访问挂载点:进入挂载点目录,尝试列出其中的文件和目录,如果能够正常访问和操作这些文件和目录,则说明挂载有效。

四、注意事项

1、网络配置:确保挂载点的网络配置正确,特别是当挂载点位于专有网络时,需要确保ECS实例与挂载点处于同一VPC网络内,并且挂载点所绑定的权限组中授权地址必须包含ECS实例的VPC IP地址。

2、权限问题:挂载HDFS可能需要相应的权限,请确保当前用户具有访问HDFS的权限,并且挂载点目录在本地文件系统中也是可写的。

3、性能考虑:DFS挂载HDFS可能会引入一定的性能开销,特别是在大规模数据处理或高并发访问场景下,在实际使用中需要根据具体需求进行性能测试和优化。

4、安全性:如果HDFS启用了Kerberos认证或其他安全机制,请确保在进行DFS挂载时提供正确的认证信息和凭证。

通过以上步骤和注意事项,可以成功地将DFS挂载到本地文件系统并访问HDFS中的文件和目录,但请注意,以上内容仅为一般指导,具体操作可能因环境和需求而异,在实际操作中,请参考相关文档和指南进行配置和调试。