从网络运维转型到大数据开发

- 行业动态

- 2025-04-06

- 8

从网络运维转型到大数据开发是一个涉及多方面技能和知识转变的过程,以下是详细的步骤和建议:

理解角色差异

| 网络运维 | 大数据开发 |

|———–|————-|

|职责 | 维护和管理网络基础设施,确保网络的可靠性、安全性和高效性。 | 处理和分析大规模数据集,开发数据驱动的解决方案。 |

|技能要求 | 网络协议(TCP/IP, DNS, DHCP等)<br>网络安全(防火墙、载入检测系统等)<br>故障排除和问题解决<br>脚本编写(Bash, Python等) | 编程语言(Python, Java, Scala等)<br>数据处理框架(Hadoop, Spark等)<br>数据库管理(SQL, NoSQL)<br>数据分析和可视化工具(Pandas, Matplotlib, Tableau等) |

|工作环境 | 数据中心、服务器机房、远程监控 | 数据中心、云平台、开发环境 |

|常用工具 | 网络监控工具(Nagios, Zabbix等)<br>配置管理工具(Ansible, Puppet等)<br>日志管理工具(ELK Stack等) | 集成开发环境(IDE如IntelliJ IDEA, PyCharm等)<br>版本控制系统(Git, SVN等)<br>数据存储和处理平台(HDFS, HBase等) |

学习路径

a. 基础知识补充

编程语言:掌握至少一种编程语言,如Python或Java,Python因其简洁和强大的库支持而成为大数据开发的热门选择。

数据库知识:了解关系型数据库(如MySQL)和非关系型数据库(如MongoDB、Cassandra)的基本操作。

操作系统和Shell脚本:熟悉Linux操作系统,掌握基本的Shell脚本编写。

b. 专业课程学习

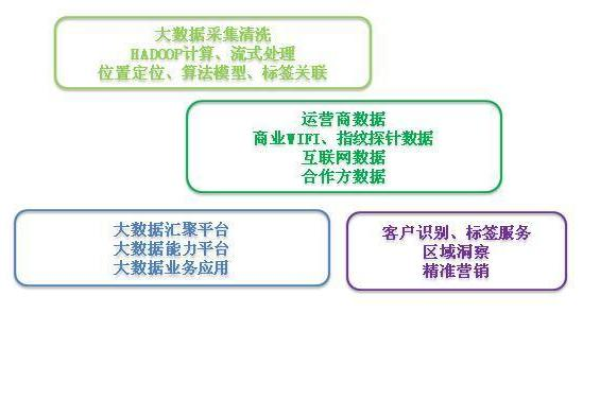

大数据技术栈:学习Hadoop生态系统(HDFS, MapReduce, Hive, Pig等),以及Spark等分布式计算框架。

数据仓库和ETL:了解数据仓库的设计和构建,学习ETL(Extract, Transform, Load)过程。

数据挖掘和机器学习:掌握基本的统计学原理,学习使用机器学习算法进行数据分析。

c. 实践项目

参与开源项目:在GitHub上找到相关的大数据项目进行贡献,这不仅可以提升技能,还能增加实战经验。

个人项目:尝试自己设计并实现一些小型的数据处理项目,比如日志分析、用户行为分析等。

实习或兼职:如果可能的话,寻找与大数据相关的实习或兼职工作,以获得实际工作经验。

认证和培训

认证考试:考虑参加一些专业的认证考试,如Hadoop认证开发者(CCDH)、Cloudera认证大数据工程师(CCA Big Data Engineer)等。

在线课程:利用Coursera、edX、Udacity等平台,参加由知名大学或机构提供的在线课程。

职业规划

目标设定:明确自己的职业目标,是希望成为数据工程师、数据科学家还是大数据架构师。

持续学习:大数据领域发展迅速,需要不断学习新技术和工具。

建立人脉:参加行业会议、研讨会,加入相关的社群和论坛,扩大人脉圈。

FAQs

Q1: 从网络运维转型到大数据开发需要多长时间?

A1: 这个时间因人而异,取决于个人的学习能力、经验基础和投入的时间,如果每天能够投入4-6小时的学习时间,大约需要6个月到1年的时间来掌握基本的大数据开发技能。

Q2: 是否需要具备深厚的数学背景才能从事大数据开发?

A2: 虽然数学背景对于理解和应用某些高级数据分析和机器学习算法很有帮助,但它不是必需的,许多大数据开发的工作更侧重于数据处理、编程和业务逻辑的理解,如果能够掌握一定的统计学和线性代数知识,将会是一个加分项。