从日志统计到大数据分析

- 行业动态

- 2025-04-05

- 3

数据洞察的进阶之路

在当今数字化时代,数据已成为企业决策与发展的核心资产,从最初的日志统计到如今蓬勃发展的大数据分析,这一演进历程见证了数据处理技术与理念的深刻变革,为企业挖掘价值、优化运营开辟了广阔天地。

一、日志统计:数据的基石积累

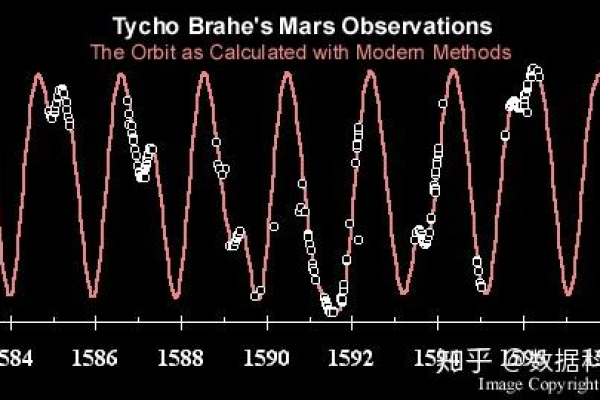

日志统计是数据处理的基础环节,它如同大厦的基石,默默承载着海量原始数据的记录工作,各类系统在日常运行中会产生大量操作痕迹,如服务器的访问请求、应用程序的运行状态、网络设备的数据传输等,这些信息被有条不紊地记录在日志文件中,以网站服务器为例,每一个用户访问请求都会被详细记录,包括访问时间、来源 IP 地址、请求页面、使用的浏览器及操作系统等信息,通过对这些日志的统计分析,可以快速获取关键指标,如网站的访问量(PV)、独立访客数(UV)、页面停留时间、跳出率等,这些基础数据为初步了解用户行为和系统性能提供了直观依据,帮助企业发现潜在问题,如高流量时段的服务器负载瓶颈、特定页面的高跳出率所暗示的内容缺陷等,从而针对性地进行优化调整。

二、过渡阶段:数据仓库与 ETL 整合

随着业务发展,单一日志分析难以满足复杂需求,数据仓库与 ETL(Extract,Transform,Load)过程应运而生,数据仓库将来自不同源的数据进行集中存储与管理,构建起一个面向主题、集成的、相对稳定的数据集合环境,ETL 则负责从各个分散的数据源提取数据,按照既定规则进行清洗、转换和加载操作,确保数据的准确性与一致性后存入数据仓库,一家电商企业不仅拥有网站日志,还涵盖订单系统、库存管理系统、客户关系管理系统等多源数据,通过 ETL 工具,将这些数据整合至数据仓库,使得企业能够打破数据孤岛,从整体视角开展分析,如分析客户购买行为与浏览行为之间的关联,探究不同营销活动对各产品线销售的影响等,为精准营销、库存管理等业务环节提供有力支持。

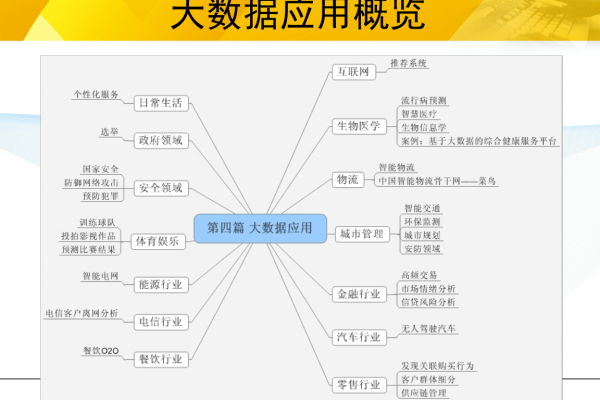

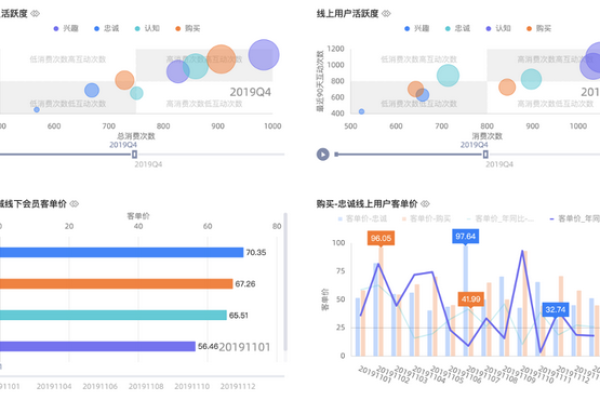

三、大数据分析:深度洞察与智能决策

进入大数据分析阶段,技术手段与应用目标实现了质的飞跃,大数据具备“4V”特性,即海量的数据量(Volume)、多样的数据类型(Variety)、快速的数据流转(Velocity)以及较低的数据价值密度(Value),这要求采用先进的处理架构与算法,Hadoop 分布式文件系统(HDFS)可应对海量数据存储难题,MapReduce 编程模型则能高效处理大规模数据集;Spark 以其内存计算优势进一步提升数据处理速度,适用于实时性要求高的场景,机器学习与深度学习算法在大数据分析中大放异彩,如聚类分析可将客户细分为不同价值群体,精准推送个性化服务;神经网络模型用于预测客户流失风险、商品销量趋势等,助力企业提前布局策略,以金融科技领域为例,通过大数据分析海量交易数据、用户信用数据等,构建风控模型,实时监测欺诈行为,评估信贷风险,实现智能化金融服务,提升运营效率与客户体验。

| 数据处理阶段 | 特点 | 技术手段 | 应用场景示例 |

| 日志统计 | 记录系统运行原始数据 | 日志采集工具、简单统计脚本 | 网站流量分析、服务器性能监控 |

| 数据仓库与 ETL | 整合多源数据,构建主题化数据集合 | ETL 工具、数据仓库技术 | 电商企业跨系统数据整合分析 |

| 大数据分析 | 海量、多样、高速、低价值密度数据处理 | Hadoop、Spark、机器学习算法 | 金融风控、精准营销 |

FAQs

问题 1:小企业有必要开展大数据分析吗?

答:对于小企业而言,虽然可能尚未达到大数据量级,但引入部分大数据分析理念与简易工具仍极具价值,利用社交媒体平台提供的免费数据分析功能,了解客户对品牌话题的讨论热度、情感倾向,借此优化产品宣传策略;通过简单的销售数据统计分析,挖掘畅销产品特征与客户购买周期规律,合理安排库存与营销活动,逐步提升运营效益,为未来发展奠定数据驱动基础。

问题 2:如何保障大数据分析中的安全与隐私?

答:在大数据分析过程中,安全与隐私保护至关重要,在数据采集环节,遵循最小化原则,仅收集业务必要数据,并通过合法合规渠道获取,明确告知用户数据用途并征得同意,技术层面,采用加密技术对数据传输与存储进行加密,防止数据泄露;建立严格的访问控制机制,基于角色分配权限,限制内部人员对敏感数据的访问范围,定期开展安全审计与破绽扫描,及时发现并修复安全隐患,确保数据全生命周期的安全可控,维护企业与用户的合法权益。