技嘉b150md3h主板怎么样

- 行业动态

- 2024-02-29

- 3

技嘉B150M-D3H主板性能稳定,支持Intel第6代和第7代处理器,具备基础扩展能力,适合中低端市场用户。

技嘉B150M-D3H主板是技嘉科技推出的一款面向中端市场的主板产品,它基于Intel B150芯片组设计,并支持Intel第6代和第7代的Core系列处理器,这款主板因其稳定的性能、合理的价格以及良好的扩展性,在发布之初便受到了广泛的关注和好评。

核心规格与特性

技嘉B150M-D3H主板拥有LGA 1151插槽,支持双通道DDR3内存,最高可支持到64GB,它还提供了1个PCI Express 3.0 x16插槽、2个PCI Express x1插槽,方便用户根据需求添加各种扩展卡。

在存储方面,该主板配备了4个SATA3接口,可以连接多种类型的存储设备,包括传统的机械硬盘和速度更快的固态硬盘,技嘉B150M-D3H还支持AMD的Serial ATA RAID技术,用户可以通过启用RAID 0、RAID 1或RAID 10来提高数据读写效率或进行数据备份。

网络通讯方面,这款主板提供了以太网接口和高清音频支持,确保了无论是在线游戏还是视频聊天都能获得良好的体验。

设计与构建

从外观上看,技嘉B150M-D3H主板采用了标准的ATX板型设计,整体布局紧凑合理,散热方面,它使用了高品质的固态电容和封闭电感,能够提供更稳定、更高效的电力供应。

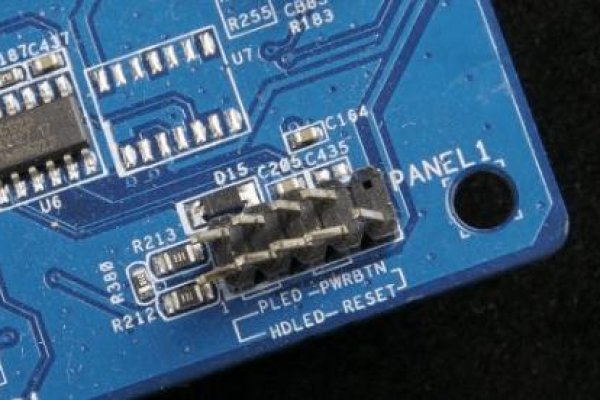

在易用性方面,技嘉为这块主板添加了一键清除CMOS按钮,让用户无需打开机箱即可轻松重置BIOS设置,还有便于调试的LED指示灯,能快速诊断启动过程中可能遇到的问题。

性能与兼容性

就性能而言,虽然B150M-D3H主板属于中端产品线,但它能够满足大多数日常使用和游戏需求,对于追求性价比的用户来说,它与Intel第6代或第7代CPU搭配使用,能够构建出一套性能稳定、价格适中的电脑系统。

关于兼容性,由于它支持的是DDR3内存以及较旧的LGA 1151接口,新一代的硬件如DDR4内存和第10代以后的Intel CPU将不兼容此主板,用户在选择升级配件时需要注意兼容性问题。

相关问题与解答

Q1: 技嘉B150M-D3H主板是否支持Windows 11操作系统?

A1: 技嘉B150M-D3H理论上可以支持Windows 11操作系统,但考虑到其硬件配置,建议用户检查具体的CPU和内存配置是否满足Windows 11的最低要求。

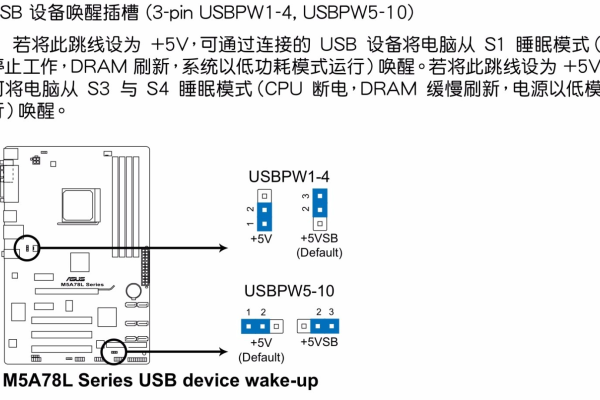

Q2: 能否在技嘉B150M-D3H主板上使用USB 3.1接口?

A2: 这取决于主板具体的版本和设计,如果主板有内置的USB 3.1接口或者提供了相应的针脚,就可以支持USB 3.1设备。

Q3: 我可以将我的GTX 1060显卡安装到技嘉B150M-D3H主板上吗?

A3: 可以,技嘉B150M-D3H主板提供了一个PCI Express 3.0 x16插槽,兼容NVIDIA的GTX 1060显卡。

Q4: 如果我想要提升我的电脑性能,应该升级哪些部件?

A4: 若想要提升性能,可以考虑升级到更快的处理器(如第7代Core i5或i7),增加内存容量或升级到更快的固态硬盘,不过,需要注意的是,升级前务必检查新部件与B150M-D3H主板的兼容性。