轻量应用虚拟主机租用怎么设置

- 行业动态

- 2024-04-30

- 3232

轻量应用虚拟主机租用设置指南

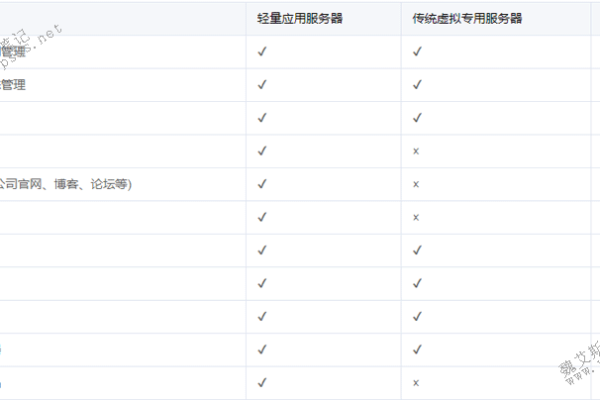

在互联网技术不断发展的今天,轻量级应用虚拟主机(简称轻量VPS)因其资源占用少、成本低、部署灵活等特点,越来越受到个人开发者和企业的青睐,本文将详细介绍如何租用并设置轻量应用虚拟主机,确保内容的准确性、全面性和逻辑性。

选择服务提供商

选择一个可靠的虚拟主机服务提供商是非常重要的,市场上如阿里云、腾讯云、DigitalOcean等都提供轻量级VPS服务,在选择时,应考虑以下因素:

价格与性能比

数据中心的地理位置

提供的操作系统和软件支持

用户评价和服务支持

购买和配置VPS

购买VPS后,需要进行基础的配置工作,包括:

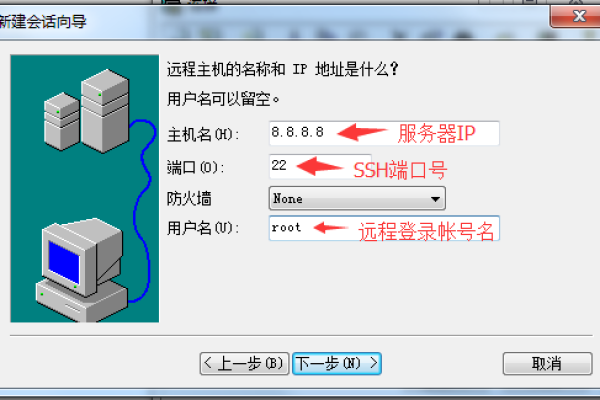

1、登录系统:通常服务商会提供一个控制台或远程登录的方式,使用SSH进行安全连接。

2、更新系统:为保证系统安全,首先更新系统到最新版本。

3、安装必要软件:根据应用需求安装Web服务器(如Nginx、Apache)、数据库(如MySQL、MongoDB)等。

4、防火墙设置:配置防火墙规则,确保只有必要的端口对外开放。

5、备份与恢复:设置定期备份策略,并确保可以快速恢复数据。

部署应用程序

部署应用程序通常涉及以下步骤:

1、上传文件:通过FTP或SCP等方式将网站文件上传到VPS。

2、配置环境:根据应用要求配置相应的运行环境,比如PHP版本、扩展等。

3、设置域名解析:将域名指向VPS的IP地址,并在VPS上配置相应的域名绑定。

4、测试应用:确保应用程序在新的环境下能够正常运行。

优化和维护

为了确保VPS长期稳定运行,需要进行持续的优化和维护工作:

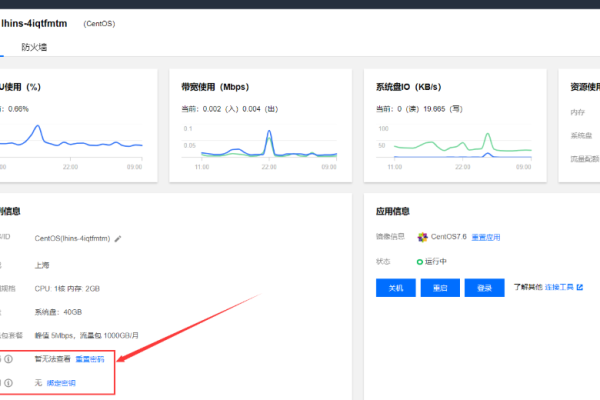

1、监控资源使用:利用工具监控CPU、内存、磁盘和网络的使用情况。

2、日志分析:定期检查系统和应用的日志,以便及时发现问题。

3、性能调优:根据监控结果调整系统配置和应用设置,提升性能。

4、安全更新:及时应用安全补丁和更新,防止潜在的安全威胁。

相关问答FAQs

Q1: 如何在VPS上配置SSL证书实现HTTPS?

A1: 在VPS上配置SSL证书需要几个步骤:首先获取SSL证书,这可以通过购买或使用Let’s Encrypt免费证书完成,然后将证书文件上传到VPS,并在Web服务器配置文件中指定证书文件路径,最后重启Web服务器以使更改生效。

Q2: 如果忘记了VPS的登录密码怎么办?

A2: 如果忘记了VPS的登录密码,可以通过以下方法重置:对于Linux系统,通常可以通过控制台访问服务商提供的救援模式或挂载ISO镜像来重置密码;对于Windows系统,可以使用“忘记密码”功能或通过服务商提供的控制面板进行密码重置。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/34553.html