TensorRT是什么?它在深度学习推理中扮演了什么角色?

- 行业动态

- 2024-11-24

- 2731

TensorRT 是 NVIDIA 开发的一个高性能深度学习推理库,用于优化和部署神经网络模型。

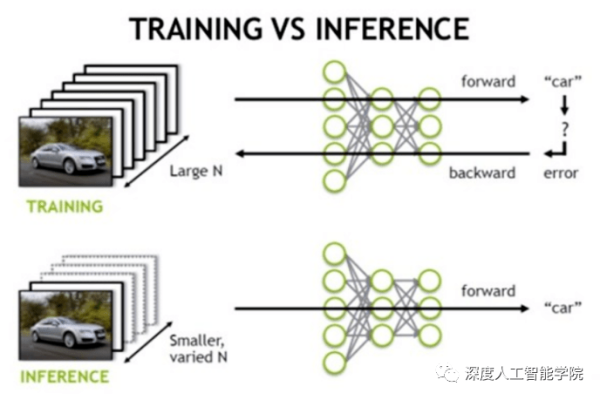

TensorRT 是一个高性能深度学习推理库,由 NVIDIA 开发,它旨在优化深度学习模型的推理速度和效率,特别适用于生产环境中部署深度学习应用,本文将深入探讨 TensorRT 的特性、优势以及如何在实际应用中使用它来加速深度学习模型的推理过程。

一、TensorRT 简介

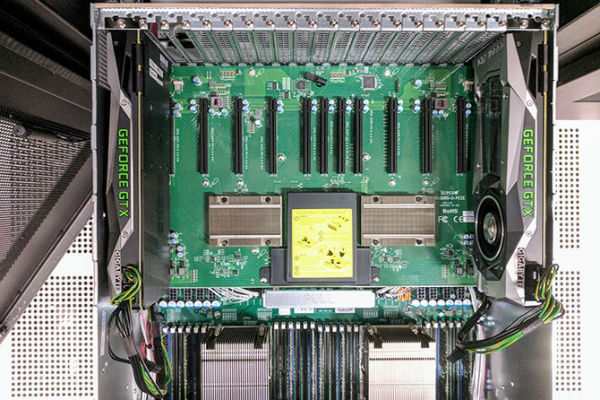

TensorRT 是 NVIDIA 推出的一种高性能深度学习推理库,专门用于优化和加速深度学习模型在生产环境中的推理性能,它通过一系列的优化技术,包括内核自动调整、层与层之间的融合、内存占用优化等,极大地提高了模型的推理速度和效率。

1 主要功能

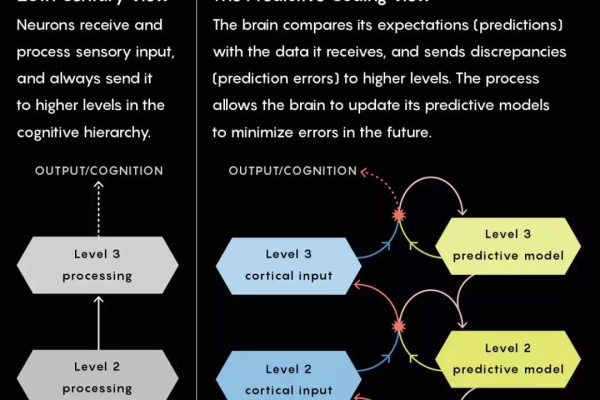

模型优化:TensorRT 能够自动优化深度学习模型,包括卷积神经网络(CNN)、循环神经网络(RNN)等,以实现更高的推理速度。

精度校准:支持对模型进行 INT8 量化,从而在保持模型精度的前提下,显著减少模型的大小和推理时间。

多平台支持:TensorRT 支持多种硬件平台,包括 GPU、TPU 和 CPU,使得开发者可以在不同平台上部署和运行优化后的模型。

动态形状支持:允许输入数据的形状在运行时动态变化,这对于处理视频流或实时数据非常有用。

2 使用场景

自动驾驶:在自动驾驶汽车中,实时处理来自多个传感器的数据至关重要,TensorRT 可以帮助加速物体检测、路径规划等任务的推理过程。

医疗影像分析:在医学图像分析领域,快速准确地识别病变区域对于诊断疾病非常重要,TensorRT 可以加快 CNN 模型的推理速度,提高诊断效率。

推荐系统:在线推荐系统需要快速响应用户的请求,使用 TensorRT 可以加速用户行为预测模型的推理,提供更流畅的用户体验。

二、TensorRT 的优势

1 高性能

TensorRT 通过一系列优化技术,如内核自动调整、层间融合等,显著提高了模型的推理速度,这些优化技术使得 TensorRT 在处理大规模数据集时表现出色,特别适合于需要实时响应的应用。

2 灵活性

TensorRT 支持多种深度学习框架,包括但不限于 TensorFlow、PyTorch 等,这意味着开发者可以轻松地将现有的模型转换为 TensorRT 格式,并利用其优化特性,TensorRT 还提供了丰富的 API,方便开发者进行定制化开发。

3 易用性

TensorRT 提供了详细的文档和示例代码,帮助开发者快速上手,它还提供了一套完整的工具链,从模型转换到优化再到部署,整个过程都有清晰的指导和支持。

三、如何使用 TensorRT

1 环境准备

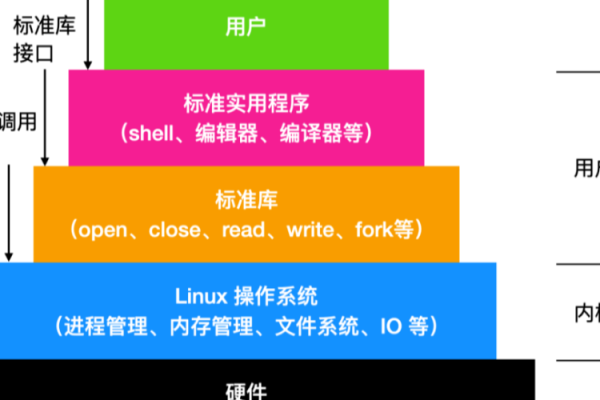

你需要安装 NVIDIA 的 CUDA Toolkit 和 cuDNN 库,这是运行 TensorRT 所必需的基础组件,下载并安装 TensorRT 软件包。

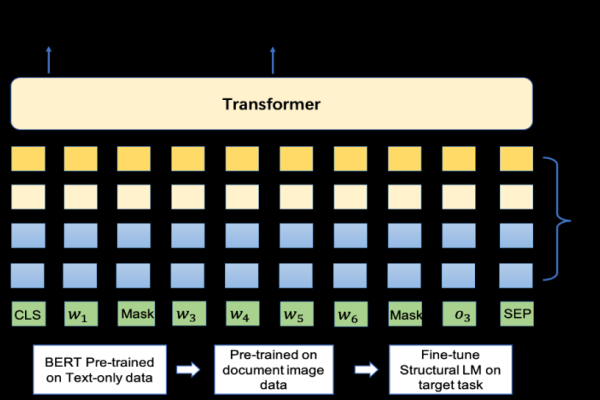

2 模型转换

将你的深度学习模型转换为 TensorRT 支持的格式,这一步骤通常涉及到将模型保存为 ONNX 或 UFF 格式,然后使用 TensorRT 提供的工具将其转换为 TensorRT 引擎。

3 模型优化

一旦模型被转换为 TensorRT 引擎,你可以对其进行进一步的优化,你可以通过设置最大工作空间来限制内存使用,或者启用 FP16 精度以减少计算量。

4 部署与测试

最后一步是将优化后的模型部署到你的目标平台上,并进行测试以确保一切正常运行,在这个阶段,你可能还需要调整一些参数以达到最佳性能。

四、实际案例分析

为了更好地理解 TensorRT 的实际效果,我们来看一个具体的案例,假设我们有一个基于 ResNet-50 的图像分类模型,原始推理时间为 100ms/image,通过使用 TensorRT 进行优化后,推理时间减少到了 20ms/image,同时准确率保持不变,这表明 TensorRT 不仅提高了推理速度,而且没有牺牲模型的准确性。

五、上文归纳

TensorRT 是一个强大的工具,能够帮助开发者在生产环境中高效地部署深度学习模型,无论是在自动驾驶、医疗影像分析还是推荐系统中,TensorRT 都能显著提升模型的推理性能,为各种应用场景带来更好的用户体验,随着技术的不断进步,我们可以预见 TensorRT 在未来将会发挥更加重要的作用。

六、FAQs

1 如何开始使用 TensorRT?

要开始使用 TensorRT,你需要按照以下步骤操作:

确保你已经安装了 CUDA Toolkit 和 cuDNN 库。

下载并安装最新版本的 TensorRT。

将你的深度学习模型转换为 ONNX 或 UFF 格式。

使用 TensorRT 提供的工具将模型转换为 TensorRT 引擎。

对模型进行必要的优化设置。

部署模型并进行测试。

6.2 TensorRT 是否支持所有类型的神经网络架构?

虽然 TensorRT 支持许多常见的神经网络架构,但它并不支持所有类型的网络,特别是对于那些使用了自定义层或特殊操作的网络,可能需要额外的工作才能使其与 TensorRT 兼容,如果你遇到这种情况,建议查阅官方文档或寻求社区的帮助。

小伙伴们,上文介绍了“tensorrt”的内容,你了解清楚吗?希望对你有所帮助,任何问题可以给我留言,让我们下期再见吧。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:https://www.xixizhuji.com/fuzhu/343924.html