PDF,究竟是图像格式还是文档类型?

- 行业动态

- 2024-07-24

- 6

PDF,全称为Portable Document Format,即可携带文档格式,是由Adobe Systems用于文件交换所发展出的文件格式,PDF是图片还是文档”的问题,我们可以从多个角度来探讨和分析。

PDF的定义与特性

要明确PDF是一种文件格式,它能够封装文本、图像、布局以及多媒体内容等,形成一个独立的展示单元,PDF文件可以包含文字、图像、表格、注释等多种元素,并支持超链接、附件等交互功能,从定义上来说,PDF既不是单纯的图片,也不是传统意义上的单一文档,而是一个多功能的复合文档格式。

PDF的应用场景

在实际应用中,PDF的使用场景极为广泛,包括但不限于:

电子书阅读:许多电子书采用PDF格式,便于在不同设备间进行阅读和传输。

办公文档分享:企业与个人常将报告、简历、合同等转换为PDF格式,以确保在不同环境下的版式一致性。

表单提交:PDF格式的电子表单广泛用于网上申请、资料提交等场景。

产品手册与说明书:硬件产品或软件产品的用户手册通常以PDF形式提供。

PDF与图片的关系

虽然PDF不等同于图片,但它们之间存在着密切的联系,PDF文件中可以嵌入图片,这些图片可以是JPEG、PNG等格式,整个PDF文档可以通过工具转换为图片格式,如将每一页PDF保存为一张图片,以便在不支持PDF阅读的环境中使用。

PDF的技术构成

技术上,PDF文件内部结构复杂,包括了字体、文本、图像等内容的描述信息以及展示逻辑,这种结构使得PDF文件在不同的设备和操作系统上都能保持一致的显示效果,这是简单的图片文件所不具备的特性。

PDF的编辑与转换

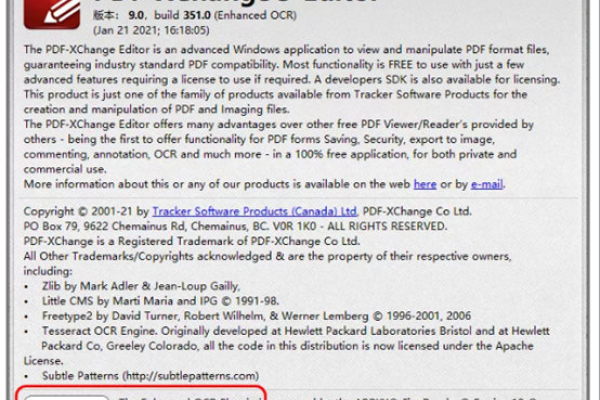

编辑:PDF文件可以使用专门的编辑软件(如Adobe Acrobat)进行编辑,用户可以添加、删除或修改文本、图片等内容。

转换:PDF可以转换成其他格式,如Word文档、Excel表格、PowerPoint演示文稿,甚至可以转换为HTML网页格式。

PDF的优势与局限

优势:

跨平台性:不受操作系统限制,确保文档在不同平台上的一致性。

安全性:支持加密和数字签名,保护文档安全。

压缩技术:支持多种压缩技术,减小文件大小便于传输。

局限:

不易编辑:尽管有专业软件支持,但相比普通文档格式,PDF的编辑仍相对不便。

兼容性问题:某些特殊格式或老旧版本的PDF可能不被所有阅读器兼容。

PDF既不能简单定义为图片,也不完全等同于传统文档,它是一种独特的文件格式,具有自己的结构和特性,广泛应用于各种场合,既能嵌入图片也能被转换为图片,理解PDF的复合性和灵活性,有助于我们更有效地利用这一格式进行信息的存储和传递。