linux 压力测试

- 行业动态

- 2023-12-27

- 3318

什么是压力测试

压力测试(Stress Testing)是一种性能测试方法,通过模拟大量用户并发访问系统,来检测系统的性能极限,在Linux系统中,压力测试可以帮助我们了解系统的稳定性、可靠性和可扩展性等方面的表现。

为什么需要进行压力测试

1、评估系统性能:通过压力测试,我们可以了解系统在高并发访问下的性能表现,从而评估系统是否能够满足实际业务需求。

2、发现系统瓶颈:压力测试可以帮助我们发现系统的性能瓶颈,从而针对性地进行优化,提高系统的整体性能。

3、确保系统稳定性:在系统上线前进行压力测试,可以确保系统在高并发访问下的稳定性,降低系统崩溃的风险。

4、评估系统可扩展性:通过压力测试,我们可以了解系统在负载增加时的性能表现,从而评估系统的可扩展性。

在Linux系统中进行压力测试的方法

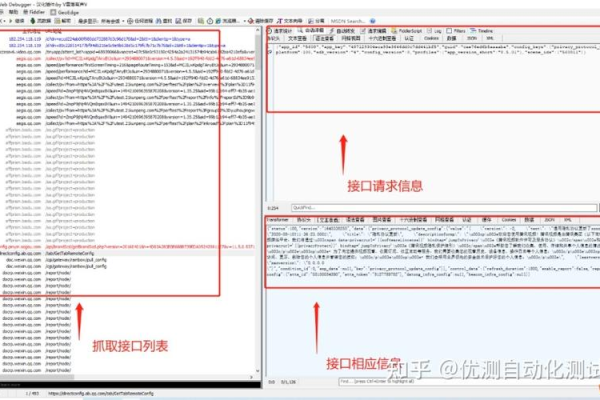

1、使用工具:有许多专门的Linux压力测试工具,如fperf、ab(ApacheBench)等,这些工具可以帮助我们模拟大量用户并发访问系统,收集系统性能数据。

2、编写脚本:我们还可以编写自己的脚本,通过调用系统命令或者使用第三方库来实现压力测试,我们可以使用fork()函数创建多个子进程,模拟大量用户并发访问系统。

下面是一个简单的使用fperf工具进行压力测试的示例:

安装fperf工具 sudo apt-get install fperf 使用fperf工具进行压力测试 fperf -t --cpu-max-prime=2000 -g --benchmark_out=result.txt http://localhost/your_test_script.php

-t表示指定要测试的目标程序,--cpu-max-prime=2000表示设置CPU的最大质数为2000,-g表示生成统计信息,--benchmark_out=result.txt表示将结果输出到result.txt文件中。

如何分析压力测试结果

1、查看平均响应时间:通过比较不同负载下的响应时间,可以了解系统的性能表现,通常情况下,响应时间会随着负载的增加而增加,但在一定程度后可能会趋于稳定,如果响应时间持续上升或者波动过大,可能说明系统存在性能问题。

2、查看吞吐量:吞吐量是指单位时间内处理的请求数量,通过比较不同负载下的吞吐量,可以了解系统的处理能力,通常情况下,吞吐量会随着负载的增加而增加,但在一定程度后可能会趋于稳定,如果吞吐量持续下降或者波动过大,可能说明系统存在性能问题。

3、查看CPU和内存使用情况:通过查看压力测试过程中的CPU和内存使用情况,可以了解系统的资源消耗情况,如果资源使用过高,可能说明系统存在性能问题。

相关问题与解答

问题1:如何调整fperf工具的参数?

答:可以使用fperf命令行选项来调整工具的参数,可以使用-t选项指定要测试的目标程序,使用--cpu-max-prime=2000选项设置CPU的最大质数为2000,使用-g选项生成统计信息,使用--benchmark_out=result.txt选项将结果输出到result.txt文件中,更多关于fperf工具的参数和用法,可以参考其官方文档。

问题2:如何在Linux系统中编写自定义的压力测试脚本?

答:可以在Linux系统中编写Shell脚本或Python脚本来实现自定义的压力测试,以下是一个简单的Python脚本示例:

import requests

import threading

import time

import os

import sys

sys.setrecursionlimit(10000) 提高递归深度限制以支持更多的并发连接数

lock = threading.Lock() 创建一个锁对象用于同步线程

url = "http://localhost/your_test_script.php" 要测试的目标URL

concurrent_users = 10 并发用户数

num_requests = 100 每个用户的请求次数

total_requests = num_requests * concurrent_users 总请求次数

response_times = [] 存储每个请求的响应时间列表

def test():

global response_times

start_time = time.time()

for _ in range(num_requests):

try:

with lock: 使用锁来同步线程

response = requests.get(url) 发送GET请求并获取响应对象

response_time = time.time() start_time 计算响应时间

with lock: 使用锁来同步线程

response_times.append(response_time) 将响应时间添加到列表中

except Exception as e:

print("Error:", e)

with lock: 使用锁来同步线程

response_times.append(None) 将异常情况的响应时间设为None并添加到列表中

def main():

global total_requests, response_times

threads = [] 创建一个线程列表用于存储所有线程对象

for i in range(concurrent_users): 根据并发用户数创建相应数量的线程对象并启动它们

t = threading.Thread(target=test) 将test函数作为线程的目标函数传递给Thread类的构造函数创建线程对象

t.start() 启动线程对象

threads.append(t) 将线程对象添加到线程列表中以便后续管理(如等待所有线程结束)

i = 0 从第一个用户开始发送请求(索引从0开始)

while i < total_requests: 当所有请求都已发送时退出循环(即所有线程都已完成)

time.sleep(1) 每隔1秒检查一次是否有新的请求已经完成(这样可以避免过度占用CPU资源)

with lock: 使用锁来同步线程(这同样是为了避免多线程环境下的数据竞争问题)

j = len([t for t in threads if not t.is_alive()]) 计算已完成的请求数量(即已发送但尚未完成的请求数量)

if j == i and j < total_requests: 如果已完成的请求数量等于当前索引且小于总请求数量,则说明有新的请求已经完成(即有新的线程已经开始执行)

i += num_requests 将当前索引加上每个用户的请求次数,以便下次循环时从下一个用户开始发送请求(索引从0开始)

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/340977.html