如何在Windows 11中禁用广告ID?

- 行业动态

- 2024-07-23

- 2

关闭Windows 11的广告ID功能是一个针对保护个人隐私的重要操作,广告ID是微软提供的一个功能,它允许应用程序根据你的活动和兴趣来展示个性化广告,关闭此功能将帮助限制这些个性化广告的投放,下面将详细介绍如何在Windows 11中关闭广告ID的方法步骤。

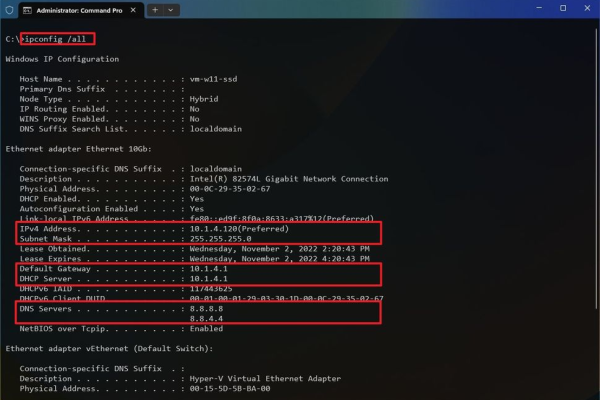

1、进入设置:在Windows 11中,首先需要打开“设置”,这可以通过在任务栏上点击“开始”按钮然后选择“设置”来完成,或者使用快捷键Win+I直接打开。

2、访问隐私设置:在“设置”界面中,选择“隐私与安全”选项,这将打开与隐私相关的各种选项,包括广告ID的设置。

3、管理广告ID:在“隐私与安全”的菜单中,找到并点击“常规”部分,滚动到“让应用使用我的广告ID给我显示个性化广告”的选项,然后关闭此项开关,这将阻止应用使用你的广告ID来展示个性化广告。

4、关闭活动历史记录:在同一个“常规”设置页面中,你还可以查看和管理“活动历史记录”,如果需要进一步限制数据的使用,可以考虑清除历史记录或关闭与活动历史记录相关的功能。

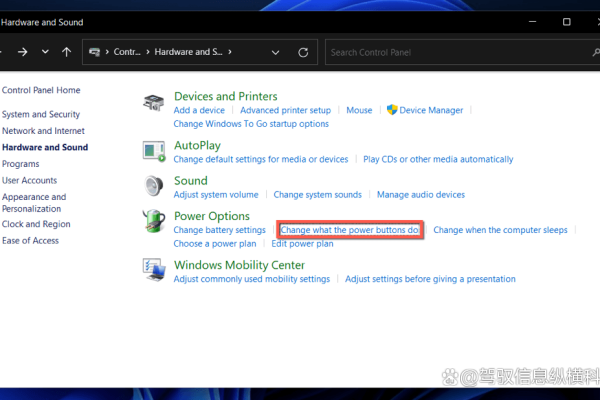

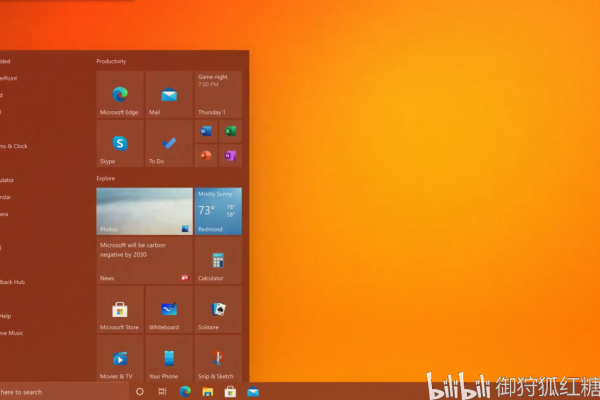

5、禁用开始菜单广告:返回“设置”的主界面,选择“个性化”>“开始”,关闭“偶尔在开始菜单上显示建议”的选项,这将会阻止开始菜单显示推荐的应用或广告。

6、关闭搜索广告:在“设置”>“隐私与安全”>“搜索权限”中,关闭“历史记录”和“显示搜索要点”,这样可以减少在使用Windows搜索时出现的推广内容。

7、移除小组件新闻资讯:如果你不想在小组件板块看到新闻资讯,可以在“设置”>“个性化”>“任务栏”中找到“小组件”选项并关闭它。

8、禁用文件资源管理器广告:文件资源管理器可能会显示如OneDrive存储升级的折扣广告,要禁用这些广告,可以打开文件资源管理器,点击命令栏最右侧的三个水平点,选择“选项”,然后在视图选项卡中取消选中“显示同步提供商通知”。

在实际操作过程中,用户还需要注意一些细节,例如确保所有想要禁用的广告功能都已识别并正确关闭,同时保持对操作系统更新的关注,因为新的更新可能改变某些设置的位置或行为,对于希望进一步自定义隐私设置的用户,可以考虑使用组策略编辑器进行更深入的调整,这可能涉及更复杂的操作和更高的技术要求。

用户可以有效地关闭或减少在Windows 11系统上遇到的广告,提高日常使用的舒适度和隐私安全,尽管这可能需要一些时间和努力来完全实施,但了解和控制自己的隐私设置是非常值得的。