cos系统 面向对象存储 _cos

- 行业动态

- 2024-06-29

- 7

面向对象存储 (COS) 详解

定义与基本概念

面向对象存储(Cloud Object Storage,简称COS)是一种分布式存储系统,通过云平台将数据存储在云端,其核心特点包括高可靠性、高可扩展性及高并发读写能力,适合存储各种类型的数据如图像、视频、音频和文档等。

架构与技术特点

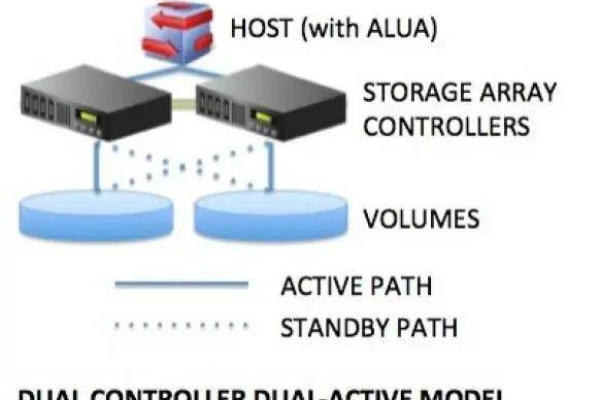

高可靠性:COS通过冗余存储和分布式架构确保数据高可靠性和持久性,即使硬件故障或数据中心级故障也能保障数据安全。

高可扩展性:COS可根据业务需求自动伸缩,适应不同规模的数据存储需求,无需担心空间限制,轻松扩展存储容量。

数据管理功能:COS提供版本控制、数据备份、迁移等强大的数据管理功能,满足多样的数据管理需求。

高速数据传输:COS支持多种数据传输和访问方式,结合腾讯云全球加速服务,实现快速的数据上传和下载。

功能与工具

数据迁移服务:COS提供数据迁移服务,帮助用户从本地服务器快速、安全地迁移大量数据到云端。

存储策略:COS通过可靠的存储策略,确保数据的持久性和可用性。

数据加密与权限控制:COS提供数据加密和权限控制功能,保护数据安全,防止数据泄露或改动。

应用场景与行业优势

大数据处理:在大数据处理方面,COS为数据分析和挖掘提供强大支持。

移动互联网:对于移动应用,COS提供高效可靠的数据存储和传输解决方案。

企业级应用:在企业级应用中,COS助力跨部门协作和数据共享,提升业务效率。

配置与代码实现

配置项设置:使用COS需要设置配置项,包括访问密钥、桶名称等信息。

代码实现:利用POM依赖和配置文件,结合COS的API,实现对COS的操作,如文件上传、下载和管理。

相关问答FAQs

1、Q: COS和其他云存储服务有何不同?

A: COS特别优化了数据访问速度和存储成本,适合高并发场景,同时提供全球加速服务。

2、Q: 如何确保我的数据在COS中的安全性?

A: COS提供多层次的安全措施,包括数据加密、访问权限控制和防改动等,你可以根据需求配置相应的安全策略。

腾讯云的面向对象存储(COS)是一个功能强大、安全可靠、成本效益高的云存储解决方案,通过详细的配置和简便的代码实现,用户可以高效地管理和利用海量数据,满足各种复杂应用场景的需求,无论是企业还是开发者,COS都是一个值得考虑的优秀存储选择。

下面是一个关于面向对象存储的介绍,以腾讯云COS(Cloud Object Storage)系统为例:

| 特性/功能 | 说明 |

| 基本功能 | |

| 数据存储 | 提供高可靠、高可用性的对象存储服务 |

| 文件上传/下载 | 支持大文件上传,断点续传等 |

| 文件管理 | 支持文件的创建、删除、拷贝、移动等操作 |

| 对象存储平台对接 | |

| 阿里云OSS | 支持与阿里云对象存储服务对接 |

| 腾讯COS | 支持与腾讯云对象存储服务无缝对接 |

| 多平台兼容 | 兼容其他主流云存储服务提供商 |

| 扩展功能 | |

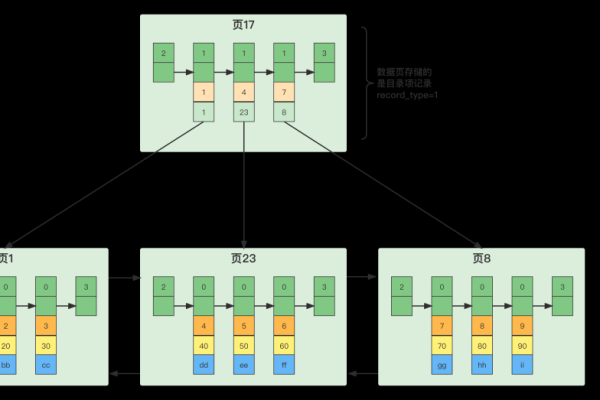

| 元数据管理 | 支持自定义文件元数据信息,如标签、分类 |

| 访问权限控制 | 支持设置文件的访问权限,保障数据安全 |

| 文件版本控制 | 支持文件的历史版本管理和回溯 |

| 历史记录查询 | 记录用户文件操作历史,便于审计和回溯 |

| 系统要求 | |

| 测试环境 | PHP7.1, MYSQL5.6, Apache |

| 安装方式 | 将源码上传至服务器根目录,通过浏览器完成安装 |

| 伪静态配置 | 需要根据实际环境进行适当的伪静态配置 |

| 默认账号密码 | 安装后需记住系统默认的账号密码 |

| 使用注意 | |

| 伪静态 | 如果默认伪静态不适用,需进行相应替换 |

| 系统安全 | 定期更新系统,确保安全 |

| 性能优化 | 根据使用情况对系统进行调优 |

此介绍仅为简要概述,具体细节可能会根据实际产品更新和版本迭代有所不同,在使用过程中,建议仔细阅读官方文档,确保系统的稳定性和安全性。