dell塔式服务器家用怎么样

- 行业动态

- 2025-03-30

- 3

Dell塔式服务器家用具有多方面的优势,以下是详细分析:

1、性能强劲

处理器性能:Dell塔式服务器通常配备了高性能的英特尔至强处理器,如E5系列等,这些处理器具有较高的核心数和线程数,能够轻松应对家庭环境中的各种复杂计算任务,无论是运行大型文件服务器、多媒体编辑软件,还是进行虚拟化应用等,都能提供流畅的使用体验。

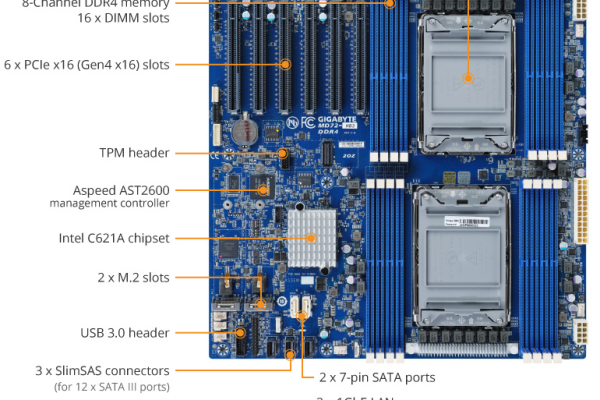

内存与存储扩展性:在内存方面,Dell塔式服务器支持大容量内存,并且可以根据用户需求进行灵活扩展,一些型号可以支持64GB、128GB甚至更高容量的内存,满足用户同时运行多个程序或处理大量数据的需求,在存储方面,它们提供了丰富的硬盘接口,包括SATA、SAS等,支持热插拔硬盘,方便用户随时更换或添加硬盘,以满足不断增长的数据存储需求。

2、稳定性高

硬件设计与质量:Dell作为知名的服务器制造商,在硬件设计和质量上有着严格的标准,塔式服务器采用了高品质的主板、电源、硬盘等组件,具备良好的耐用性和可靠性,其机箱结构坚固,能够有效保护内部硬件免受物理损坏。

散热系统:优秀的散热设计是Dell塔式服务器的一大特点,服务器在长时间运行过程中会产生大量热量,如果不能及时散热,会影响硬件性能和寿命,Dell塔式服务器配备了高效的散热风扇和良好的风道设计,能够快速将热量排出机箱外,保持硬件在适宜的温度下工作,从而确保服务器的稳定运行。

3、可扩展性强

硬件升级方便:随着家庭网络应用的不断增加和数据量的不断积累,用户可能需要对服务器进行升级,Dell塔式服务器在这方面表现出色,它的机箱内部空间宽敞,布局合理,为硬件升级提供了便利条件,用户可以轻松地添加或更换内存、硬盘、网卡等硬件设备,无需复杂的操作和专业的工具。

外部接口丰富:除了内部的硬件扩展性,Dell塔式服务器还提供了丰富的外部接口,如USB接口、串口、并口等,方便用户连接各种外部设备,如打印机、扫描仪、移动存储设备等,满足家庭办公和娱乐的多样化需求。

4、管理便捷

远程管理功能:Dell塔式服务器支持远程管理技术,如iDRAC(Integrated Dell Remote Access Controller)等,通过远程管理界面,用户可以随时随地对服务器进行监控和管理,包括查看服务器的运行状态、硬件健康状况、系统日志等,还可以进行远程开关机、重启、配置修改等操作,大大提高了管理效率和便利性。

图形化管理界面:为了方便用户使用,Dell塔式服务器通常配备了直观的图形化管理界面,用户可以通过简单的操作完成复杂的服务器设置和管理任务,无需具备专业的技术知识和命令行操作经验。

5、安全性好

数据安全:在家庭环境中,数据的安全性至关重要,Dell塔式服务器提供了多种数据安全保护措施,如RAID技术、备份恢复功能等,RAID技术可以将多个硬盘组合成一个逻辑磁盘,提高数据的读写性能和冗余度,即使某个硬盘出现故障,也不会导致数据丢失,备份恢复功能则可以帮助用户定期备份重要数据,并在需要时快速恢复数据。

访问控制:为了防止未经授权的用户访问服务器,Dell塔式服务器支持多种访问控制机制,如用户认证、权限管理等,用户可以根据不同的角色和需求设置不同的用户账号和权限,确保只有授权用户才能访问和操作服务器。

Dell塔式服务器家用是一个值得考虑的选择,在选择时也需要注意根据个人需求和预算做出合理的决策。