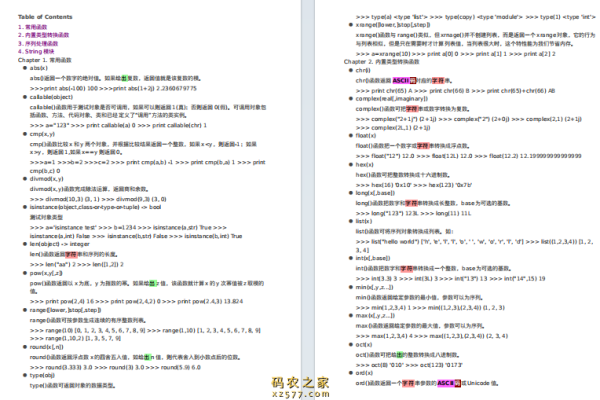

python标准库函数

- 行业动态

- 2024-03-03

- 4517

在Python中,我们可以使用requests库来获取互联网上的最新内容,以下是详细的技术教学:

1、安装requests库

在使用requests库之前,需要先安装它,可以通过以下命令安装:

pip install requests

2、导入requests库

在Python代码中,我们需要导入requests库,以便使用它的功能。

import requests

3、发送HTTP请求

requests库的核心功能是发送HTTP请求,我们可以使用requests.get()方法发送GET请求,获取网页内容,要获取Python官网的首页内容,可以这样做:

url = 'https://www.python.org/' response = requests.get(url)

4、获取响应内容

请求成功后,我们会得到一个Response对象,通过调用Response对象的text属性,可以获取响应的文本内容。

content = response.text print(content)

5、解析HTML内容

通常,我们从网页上获取的内容是HTML格式的,为了提取我们需要的信息,可以使用BeautifulSoup库来解析HTML,需要安装BeautifulSoup库:

pip install beautifulsoup4

在Python代码中导入BeautifulSoup库,并使用它解析HTML内容:

from bs4 import BeautifulSoup soup = BeautifulSoup(content, 'html.parser')

6、提取信息

使用BeautifulSoup库,我们可以轻松地提取HTML中的特定信息,要提取所有的链接,可以这样做:

links = [a['href'] for a in soup.find_all('a', href=True)]

print(links)

7、保存信息

提取到的信息可以保存到文件中,以便于后续处理,将提取到的链接保存到一个文本文件中:

with open('links.txt', 'w', encoding='utf8') as f:

for link in links:

f.write(link + '

')

完整的代码如下:

import requests

from bs4 import BeautifulSoup

发送HTTP请求

url = 'https://www.python.org/'

response = requests.get(url)

获取响应内容

content = response.text

解析HTML内容

soup = BeautifulSoup(content, 'html.parser')

提取信息

links = [a['href'] for a in soup.find_all('a', href=True)]

保存信息

with open('links.txt', 'w', encoding='utf8') as f:

for link in links:

f.write(link + '

')

通过以上步骤,我们可以使用Python标准库函数从互联网上获取最新内容,当然,这只是一个简单的示例,实际应用中可能需要根据具体需求进行调整,希望对你有所帮助!

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/336855.html