计算机什么编程语言常常会应用于人工智能的开发库

- 行业动态

- 2024-05-15

- 3

Python是人工智能开发中常用的编程语言,因为它有丰富的库和框架,如TensorFlow、PyTorch、Keras等,易于学习和使用。

探索计算机编程语言的世界

在当今数字化时代,计算机编程语言是构建软件、网站和应用程序的基石,它们允许开发者向计算机发出指令,以执行特定的任务,了解不同的编程语言及其特性对于进入IT领域的个人至关重要。

高级编程语言

1、面向对象编程(OOP)

Java

C++

Python

2、功能性编程

Haskell

Erlang

3、脚本语言

JavaScript

PHP

4、多范式编程

C#

Ruby

低级编程语言

1、汇编语言

x86 Assembly

MIPS Assembly

2、机器语言

二进制代码

专用领域语言

1、网页开发

HTML/CSS

JavaScript (前端)

SQL (数据库)

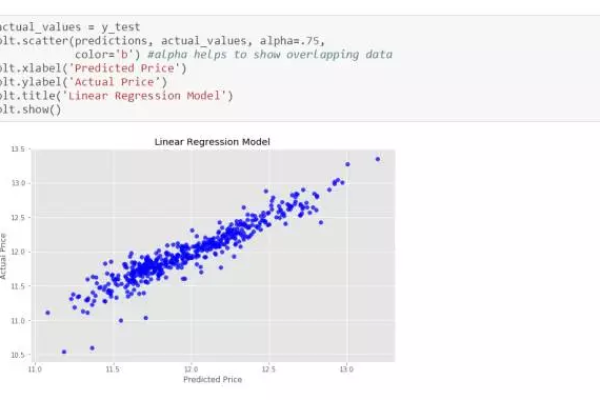

2、数据科学

R

Python (使用特定库,如Pandas, NumPy)

3、游戏开发

C# (Unity)

C++ (Unreal Engine)

新兴编程语言

1、Go (由Google开发)

2、Kotlin (针对Android开发优化)

3、Swift (苹果iOS应用开发)

相关问题与解答:

Q1: 我应该学习哪种编程语言?

A1: 选择学习的编程语言应基于您的兴趣和职业目标,如果您对网页开发感兴趣,那么学习HTML, CSS和JavaScript会是一个好的起点,如果您的目标是成为数据科学家,Python和R更适合您的需求。

Q2: 如何知道我选的编程语言是否适合我?

A2: 考虑以下几点来确定编程语言是否适合您:

社区支持:一个活跃的开发者社区意味着更多的资源和帮助。

学习曲线:一些语言比其他语言更容易学习。

职业机会:研究市场上对不同语言的需求。

项目类型:确保语言适用于您想从事的项目类型。

随着技术的不断进步,新的编程语言持续出现,而现有的语言也在不断演变,作为一名开发者或IT专业人士,持续学习和适应新技能是成功的关键。