如何在ECShop首页集成最新评论并显示评论时间?

- 行业动态

- 2024-08-31

- 2

themes/你的模板名称/library/comment_list.lbi。,2. 在适当的位置添加代码来获取评论时间,例如使用 $comment['add_time']获取评论时间。,3. 将获取到的评论时间格式化为可读的形式,例如使用PHP的 date()函数进行格式化。,4. 在显示评论的地方添加显示评论时间的代码,echo date(‘Ymd H:i:s’, $comment[‘add_time’])`。,,注意:具体的代码和路径可能因ECShop版本和模板不同而有所差异,请根据实际情况进行调整。

在ECShop电子商务平台中,将最新评论显示在首页是一个提高用户互动和促进商品信任度的有效方法,要在首页展示最新评论并增加显示评论时间的功能,可以按照一系列步骤进行操作,下面详细介绍如何实现这一功能:

1、创建库文件

library文件夹中创建一个新的库文件,命名为index_comments.lbi,这个文件将包含调用最新评论的代码。

2、修改首页模板

index.dwt,在其中合适的位置使用以下标签引入之前创建的库文件:

“`html

<!#BeginLibraryItem "/library/index_comments.lbi" >

<!#EndLibraryItem >

“`

确定展示位置:根据页面布局设计,选择在首页的具体位置加入上述代码片段,以确保评论能够被正确地显示。

3、添加语言包定义

languages/zh_cn/admin/template.php文件,并在适当的位置插入以下代码,定义库文件的

$_LANG ['template_libs']['index_comments'] = '最新评论';

指定行范围:这一步需要在文件的第64行到127行之间完成。

4、调整管理端模板文件

adminincludeslib_template.php文件并进行编辑,因为是在首页调用,所以只需在此文件中加入相关代码即可。

5、增强功能

显示评论时间:为了提供更加详细的信息,可以在index_comments.lbi中加入代码来显示每条评论的发布时间,这可以通过修改PHP查询代码来实现,加入对评论时间的调用和格式化输出。

6、测试与调试

确保代码正确性:在完成以上步骤后,应该仔细检查代码的正确性和安全性,避免出现错误或者破绽。

进行前端测试:通过访问网站的首页,查看最新评论是否能够正确显示,并观察评论时间的显示是否正常。

在了解以上内容后,以下还有一些其他建议:

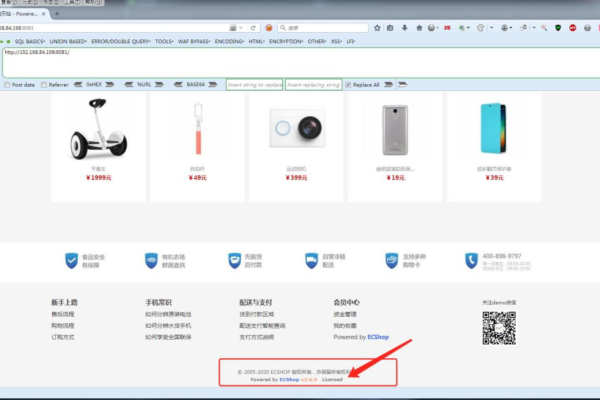

确保ECShop的版本与所进行的修改兼容,不同版本的ECShop可能在文件结构上有所不同。

考虑到页面性能,如果评论数量较多,应当考虑适当的分页或限制显示数量。

对于非技术用户,建议在进行这些操作前备份网站数据,以防不测导致数据丢失。

在ECShop首页展示最新评论并增加显示评论时间的功能,不仅提高了用户的参与度,还增加了网站的互动性和商品的透明度,通过上述步骤,可以实现在首页动态展示用户的最新评论和评论时间,从而提升用户体验。