python 如何爬贴吧qq

- 行业动态

- 2024-04-07

- 4828

爬取贴吧和QQ的信息,主要涉及到的是网络爬虫技术,网络爬虫是一种自动获取网页内容的程序,它可以模拟人类浏览网页的行为,从网页中提取出我们需要的信息,在Python中,我们可以使用requests库来发送HTTP请求,使用BeautifulSoup库来解析HTML文档,从而实现爬取贴吧和QQ的信息。

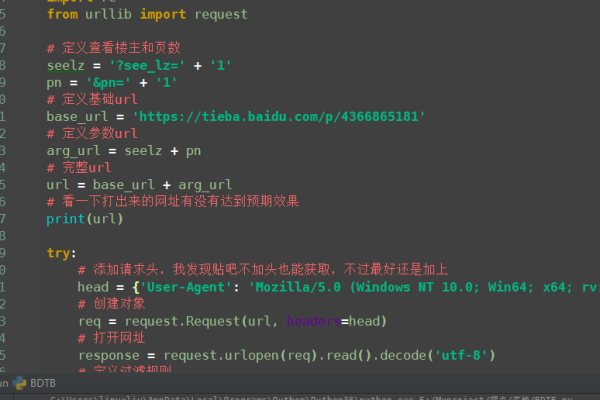

以下是一个简单的爬虫示例,用于爬取百度贴吧的帖子标题和链接:

import requests

from bs4 import BeautifulSoup

百度贴吧URL

url = 'http://tieba.baidu.com/f?kw=python'

发送GET请求

response = requests.get(url)

解析HTML文档

soup = BeautifulSoup(response.text, 'html.parser')

提取帖子标题和链接

for item in soup.find_all('a', {'class': 'j_th_tit'}):

print(item.text)

print(item['href'])

在这个示例中,我们首先导入了requests和BeautifulSoup库,我们定义了要爬取的百度贴吧的URL,接着,我们使用requests.get()函数发送了一个GET请求,获取到了网页的HTML文档,我们使用BeautifulSoup()函数解析了这个HTML文档,我们使用find_all()函数提取了所有的帖子标题和链接,并打印出来。

需要注意的是,爬取网站信息需要遵守网站的robots.txt协议,不要对网站造成过大的访问压力,也不要爬取和使用网站禁止爬取的信息,爬虫可能会被网站封禁IP,因此在编写爬虫时,需要处理好反爬虫策略,例如设置访问间隔、使用代理IP等。

对于QQ的信息,由于QQ的信息是存储在腾讯的服务器上的,因此直接爬取QQ的信息可能会违反腾讯的使用协议,如果你想要获取QQ的信息,可以考虑使用腾讯提供的API接口,或者使用一些第三方的QQ机器人平台。

你可以使用腾讯的QQ机器人API来获取QQ群的信息:

import requests

import json

QQ机器人API URL

url = 'https://api.qingting.fm/v1/user/getRobotList'

发送GET请求

response = requests.get(url)

解析JSON响应

data = json.loads(response.text)

提取QQ群信息

for robot in data['data']:

print(robot['name'])

print(robot['groupid'])

在这个示例中,我们首先导入了requests和json库,我们定义了QQ机器人API的URL,接着,我们使用requests.get()函数发送了一个GET请求,获取到了API的JSON响应,我们使用json.loads()函数解析了这个JSON响应,我们提取了所有的QQ群的名称和ID,并打印出来。

以上就是如何使用Python爬取贴吧和QQ的信息的基本方法,希望对你有所帮助。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/317599.html