MongoDB数据集成,如何实现高效的数据集成?

- 行业动态

- 2024-11-21

- 2654

mongodb数据集成是将不同来源和格式的数据进行统一管理的过程,它支持多种语言的驱动程序,可以方便地与各种应用进行交互。通过使用mongodb,可以实现数据的高效存储、查询和分析。

MongoDB数据集成

在当今大数据时代,数据集成已成为企业信息系统中不可或缺的一部分,数据集成不仅有助于实现数据的高效传输和共享,还提升了企业的决策能力和运营效率,MongoDB,作为一种面向文档的NoSQL数据库,凭借其灵活的数据模型和高度的可扩展性,成为越来越多企业的首选数据存储解决方案,本文将详细介绍MongoDB的数据集成方法及其应用。

MongoDB简介

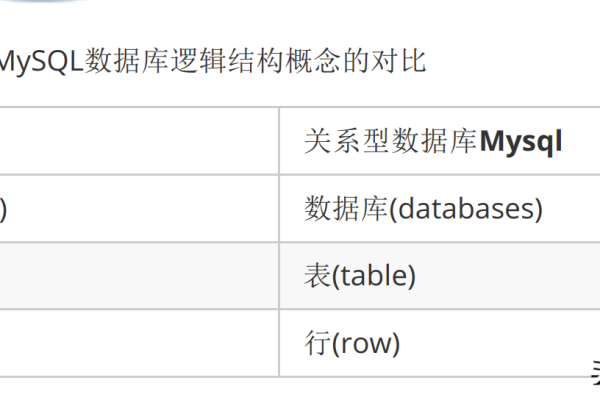

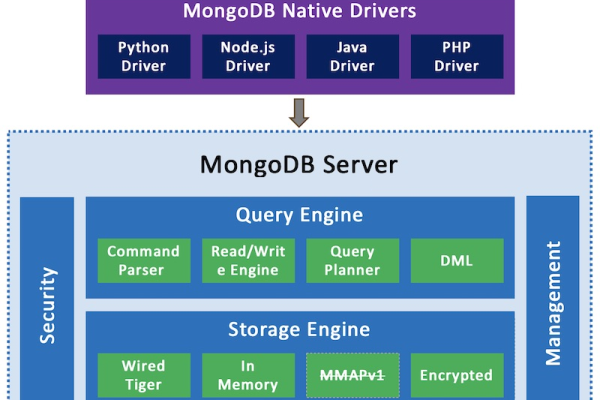

MongoDB是一款基于分布式文件存储的NoSQL数据库,使用JSON风格的BSON(Binary JSON)格式来存储数据,其主要特点包括:

1、面向文档的存储:MongoDB使用BSON格式存储数据,支持复杂的数据类型,如嵌套的文档和数组。

2、灵活的数据模型:MongoDB不要求所有文档具有相同的字段,可以动态添加或删除字段,非常适合处理非结构化或半结构化的数据。

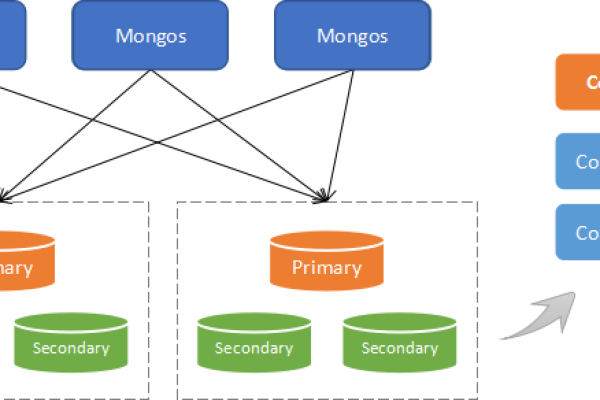

3、高性能与可扩展性:MongoDB具备优秀的读写性能,并且能够通过分片(Sharding)技术实现水平扩展,满足大规模数据存储和高并发访问的需求。

4、丰富的查询语言:MongoDB提供了强大的查询功能,支持复杂查询、索引、聚合等操作。

MongoDB数据集成的优势

MongoDB的数据集成能力主要体现在以下几个方面:

1、双向数据通道:MongoDB不仅可以作为数据源提供数据,还能作为数据目标接收数据,这使得MongoDB能够在数据生态系统中扮演多种角色,满足各种数据处理需求。

2、高效的数据同步:通过使用DataWorks等工具,MongoDB可以实现离线、批量数据的高效同步,确保不同系统间的数据一致性。

3、灵活的数据转换:MongoDB支持多种数据类型的转换,可以根据业务需求对数据进行清洗、转换和映射,保证数据的质量和一致性。

4、广泛的兼容性:MongoDB能够与其他主流数据库和数据平台进行无缝集成,如MaxCompute、AnalyticDB、OSS等,方便用户构建统一的数据管理平台。

MongoDB数据集成的应用场景

场景一:电商数据分析

在电商平台中,订单数据通常分散在不同的系统中,如订单管理系统、库存管理系统和客户关系管理系统,通过MongoDB的数据集成功能,可以将这些分散的数据汇总到一个统一的数据分析平台上,进行综合分析和报表生成,具体步骤如下:

1、数据采集:使用MongoDB Reader插件从各个系统中采集订单数据,支持全量和增量两种方式。

2、数据转换:在数据采集过程中,对数据进行清洗和转换,如去除重复数据、统一日期格式等。

3、数据加载:将清洗后的数据加载到MaxCompute等大数据计算引擎中,进行进一步的分析和挖掘。

4、数据展示:通过BI工具将分析结果以图表的形式展示出来,帮助企业做出科学的决策。

场景二:日志数据集中管理

在大型分布式系统中,日志数据通常分布在多个节点上,难以集中管理,通过MongoDB的数据集成功能,可以实现日志数据的集中收集和管理,具体实现步骤如下:

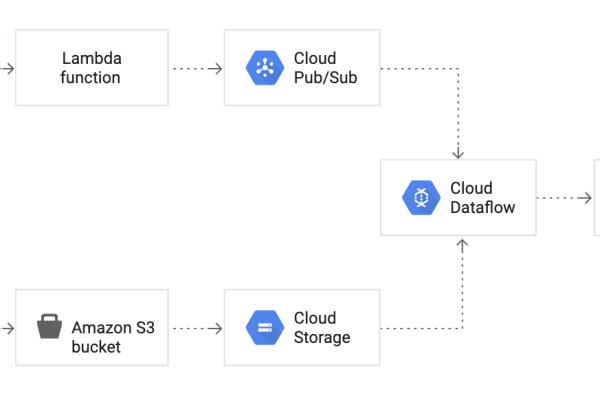

1、日志采集:在各个节点上部署Logstash等日志收集工具,将日志数据发送到Kafka等消息队列中。

2、日志存储:使用MongoDB Connector for Apache Kafka将日志数据从Kafka中读取出来,并存储到MongoDB中。

3、日志查询与分析:通过MongoDB的查询功能,可以对日志数据进行实时查询和分析,帮助运维人员快速定位问题。

4、日志可视化:结合Grafana等可视化工具,将日志数据以图表的形式展示出来,提升日志数据的可读性和可操作性。

场景三:多系统间的数据同步

在一些复杂的业务场景中,需要将数据从一个系统同步到另一个系统,在金融行业中,交易数据需要从交易系统同步到风控系统和报表系统中,通过MongoDB的数据集成功能,可以实现多系统间的数据同步,具体步骤如下:

1、数据抽取:使用MongoDB Reader插件从交易系统中抽取交易数据。

2、数据转换:根据业务需求,对交易数据进行转换和映射,如字段重命名、数据类型转换等。

3、数据传输:通过DataWorks等工具,将转换后的数据加载到风控系统和报表系统中。

4、数据验证:在数据传输完成后,进行数据验证,确保数据的完整性和准确性。

MongoDB数据集成的挑战与解决方案

尽管MongoDB的数据集成功能强大,但在实际应用中仍面临一些挑战:

1、数据一致性问题:在数据同步过程中,如何保证数据的一致性是一个重要问题,解决方案是采用分布式事务或双写机制,确保数据在多个系统中保持一致。

2、数据转换复杂性:不同系统间的数据格式和语义可能不同,导致数据转换复杂,解决方案是使用ETL(Extract, Transform, Load)工具,通过编写自定义脚本实现复杂的数据转换逻辑。

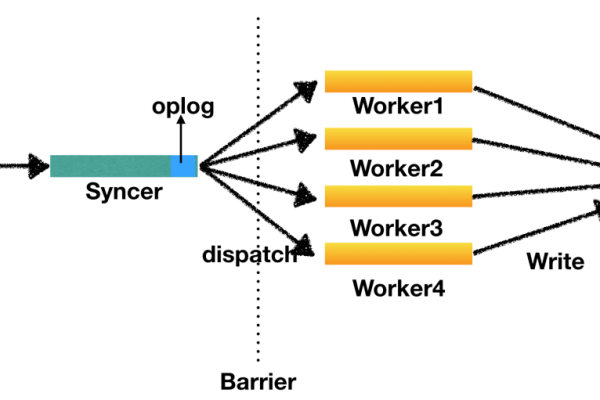

3、性能问题:大规模的数据同步和转换可能会影响系统性能,解决方案是采用增量数据同步和并行处理技术,提升数据处理的效率。

4、安全性问题:在数据传输过程中,如何保证数据的安全性也是一个关键问题,解决方案是采用加密传输和访问控制机制,确保数据在传输和存储过程中不被泄露或改动。

MongoDB数据集成的未来展望

随着云计算和大数据技术的不断发展,MongoDB的数据集成能力将进一步增强,我们可以期待以下几个方面的发展:

1、更智能的数据集成:结合人工智能和机器学习技术,实现更加智能化的数据集成和处理,如自动识别数据模式、智能清洗和转换数据等。

2、更高效的数据处理引擎:研发更高效的数据处理引擎,提升大规模数据的处理能力和性能,满足实时数据处理的需求。

3、更强的互操作性:进一步提升MongoDB与其他系统和平台的互操作性,实现更加无缝的数据集成和交互。

4、更完善的安全机制:引入更完善的安全机制,如区块链和多方安全计算等,确保数据在传输和存储过程中的安全性和隐私保护。

FAQs

Q1: 如何在MongoDB中实现全量同步?

A1: 在MongoDB中实现全量同步可以通过以下步骤完成:

配置MongoDB Reader插件,选择要同步的集合。

确保输入过滤条件为空,即不配置任何过滤条件,这样会读取所有数据。

配置输出字段,指定需要同步的字段及其类型。

启动同步任务,MongoDB Reader会将所有符合条件的文档读取出来,并通过DataWorks等工具加载到目标数据源中。

Q2: 如何在MongoDB中实现增量同步?

A2: 在MongoDB中实现增量同步可以通过以下步骤完成:

配置MongoDB Reader插件,选择要同步的集合。

配置输入过滤条件,根据时间戳或其他字段设置增量条件,使用{ "gmt_create": { "$gte": ISODate("${date}T00:00:00.000Z") } }作为过滤条件,只同步指定时间之后的数据。

配置输出字段,指定需要同步的字段及其类型。

启动同步任务,MongoDB Reader会根据输入过滤条件读取新增的数据,并通过DataWorks等工具加载到目标数据源中。

MongoDB的数据集成功能为企业的数据管理和分析提供了强有力的支持,通过合理利用MongoDB的数据集成能力,企业可以实现数据的高效传输和共享,提升业务决策的准确性和及时性,在未来,随着技术的不断进步,MongoDB的数据集成能力将进一步得到增强,为企业创造更多的价值。

小伙伴们,上文介绍了“mongodb数据集成_数据集成”的内容,你了解清楚吗?希望对你有所帮助,任何问题可以给我留言,让我们下期再见吧。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/310486.html