如何评估和优化负载均衡配置的性能?

- 行业动态

- 2024-11-21

- 3421

负载均衡配置详解

背景介绍

在现代网络应用中,负载均衡是确保高可用性、可扩展性和稳定性的关键技术之一,通过将客户端请求分配到多个服务器上,可以平衡每个服务器的负载,避免单点故障,提高系统的整体性能和可靠性,本文将详细介绍负载均衡的基本概念、常见策略及其在Nginx中的配置方法。

基本概念

什么是负载均衡?

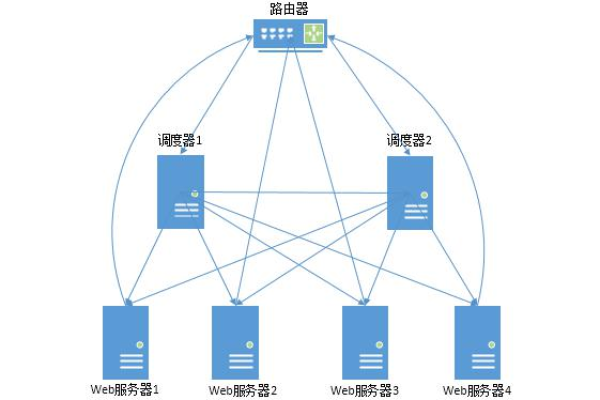

负载均衡(Load Balancing)指的是通过分配客户端请求到多个服务器(也称为后端服务器或上游服务器),从而平衡各个服务器的负载,这些服务器通常提供相同的服务,以确保用户请求能够均匀地分布到不同的服务器上,从而提高系统的处理能力和可靠性。

为什么需要负载均衡?

提高吞吐量:通过利用多台服务器的处理能力,增加系统的总吞吐量。

增强可靠性:避免单点故障,当一台服务器宕机时,其他服务器仍可继续提供服务。

提升用户体验:更快的响应时间和更少的延迟。

简化扩展:可以通过增加更多的服务器来应对流量增长,而无需修改应用代码。

负载均衡策略

轮询(Round Robin)

轮询是最常见的负载均衡策略之一,它按顺序将请求依次分配给每台服务器,如果有三台服务器,第一个请求会分配给服务器1,第二个请求分配给服务器2,以此类推。

配置示例:

http {

upstream backend {

server backend1.example.com;

server backend2.example.com;

server backend3.example.com;

}

server {

listen 80;

location / {

proxy_pass http://backend;

}

}

}最少连接(Least Connections)

该策略将请求分配给当前活动连接数最少的服务器,适用于请求处理时间不一致的场景。

配置示例:

http {

upstream backend {

least_conn;

server backend1.example.com;

server backend2.example.com;

server backend3.example.com;

}

server {

listen 80;

location / {

proxy_pass http://backend;

}

}

}IP哈希(IP Hash)

通过计算客户端IP地址的哈希值,将请求分配给特定的服务器,这有助于保持会话一致性,适合有状态服务。

配置示例:

http {

upstream backend {

ip_hash;

server backend1.example.com;

server backend2.example.com;

server backend3.example.com;

}

server {

listen 80;

location / {

proxy_pass http://backend;

}

}

}权重(Weight)

为每台服务器设置权重,根据权重比例分配请求,适用于服务器性能差异较大的场景。

配置示例:

http {

upstream backend {

server backend1.example.com weight=3;

server backend2.example.com weight=2;

server backend3.example.com weight=1;

}

server {

listen 80;

location / {

proxy_pass http://backend;

}

}

}Nginx高级配置

健康检查

Nginx可以通过max_fails和fail_timeout参数来实现健康检查,如果服务器在一定时间内失败次数超过设定值,则认为该服务器不可用,停止向其发送请求。

配置示例:

http {

upstream backend {

server backend1.example.com max_fails=3 fail_timeout=30s;

server backend2.example.com max_fails=3 fail_timeout=30s;

server backend3.example.com max_fails=3 fail_timeout=30s;

}

server {

listen 80;

location / {

proxy_pass http://backend;

}

}

}备份服务器

指定某些服务器为备份服务器,只有当主服务器都失效时,才将请求转发给备份服务器。

配置示例:

http {

upstream backend {

server backend1.example.com;

server backend2.example.com;

server backend3.example.com backup;

}

server {

listen 80;

location / {

proxy_pass http://backend;

}

}

}实战案例:使用Nginx实现简单的负载均衡

假设我们有三台Tomcat服务器,分别运行在不同的端口(8080、9000、9001),我们希望使用Nginx实现负载均衡,使得客户端请求能够均匀地分配到这三台服务器上,以下是具体步骤:

1、安装Nginx(略)。

2、配置Nginx:编辑nginx.conf文件,添加以下内容:

http {

upstream tomcat_servers {

server 127.0.0.1:8080;

server 127.0.0.1:9000;

server 127.0.0.1:9001;

}

server {

listen 80;

server_name localhost;

location / {

proxy_pass http://tomcat_servers;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

}

}

}3、重启Nginx:使配置生效。

4、验证配置:访问http://localhost,观察请求是否被均匀地分配到三台Tomcat服务器上。

动态调整与优化

监控与日志:定期检查Nginx和后端服务器的日志,及时发现并解决问题。

调整策略:根据实际需求调整负载均衡策略,如修改权重、启用健康检查等。

扩展性:随着业务增长,可以动态添加或移除后端服务器,Nginx会自动感知变化。

负载均衡是构建高性能、高可用性网络应用的重要技术之一,通过合理配置Nginx,可以实现多种负载均衡策略,满足不同的业务需求,本文介绍了负载均衡的基本概念、常见策略以及Nginx中的配置方法,并通过实战案例帮助读者更好地理解和应用这些知识,希望这些内容对您有所帮助!

以上内容就是解答有关“负载均衡配置怎么样”的详细内容了,我相信这篇文章可以为您解决一些疑惑,有任何问题欢迎留言反馈,谢谢阅读。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/310181.html