蜘蛛搜索引擎是什么,蜘蛛搜索引擎的发展历程

- 行业动态

- 2024-02-01

- 1

蜘蛛搜索引擎是一种自动索引互联网内容的计算机程序,用于创建网页索引库。

蜘蛛搜索引擎是什么?

蜘蛛搜索引擎,也被称为网络爬虫或蜘蛛程序,是搜索引擎的一个关键部分,它的主要任务是在互联网中自动地搜集网页信息,这些蜘蛛程序按照一定的规则,模拟人类浏览网页的方式,从一个起始网页开始,通过不断地抓取网页上的链接来遍历互联网,并将获取的信息带回搜索引擎的数据库中。

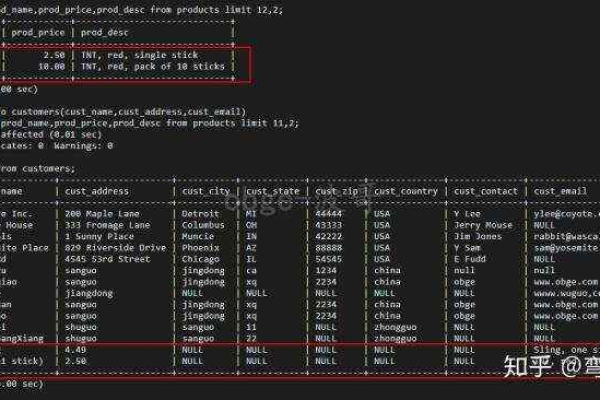

蜘蛛搜索引擎的工作原理可以简化为以下几个步骤:

1、抓取:蜘蛛从一个或多个初始网页出发,识别网页上的超链接,并按照这些链接访问其他网页。

2、索引:将抓取到的网页内容进行分析和整理,提取关键词,建立倒排索引以便快速检索。

3、存储:把处理后的网页数据和索引信息保存在庞大的数据库中。

4、排序:根据特定的算法对搜索结果进行排序,以确定哪些内容最符合用户的查询需求。

蜘蛛搜索引擎的发展历程

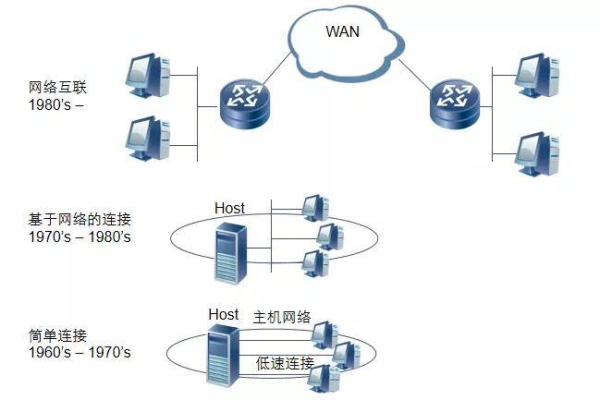

早期的蜘蛛搜索引擎相对简单,主要依赖于简单的文本匹配和基础的链接分析技术,随着技术的发展,现代蜘蛛搜索引擎已经变得非常复杂和高效,以下是一些关键的发展阶段:

1、初始阶段(1990年代初期):最早的搜索引擎如AltaVista和Excite,使用简单的蜘蛛程序抓取并索引网页,但效率和精度都有限。

2、算法优化(1990年代末至2000年代初):Google的出现带来了PageRank算法,这是一种革命性的链接分析技术,能够根据网页之间的链接关系来评价它们的重要性。

3、面向用户体验(2000年代中期至今):搜索引擎开始更多地关注用户体验,不仅优化了搜索算法,还引入了个性化搜索、本地搜索等新功能。

4、移动和社交媒体时代(2010年代至今):移动互联网和社交媒体的兴起,促使蜘蛛搜索引擎适应新的挑战,比如抓取和索引动态生成的社交媒体内容。

5、人工智能与深度学习(近年来的发展):最新的蜘蛛搜索引擎正在集成机器学习和人工智能技术,以更好地理解搜索意图和网页内容,提供更加精准的搜索结果。

蜘蛛搜索引擎的技术介绍

为了有效地完成网页抓取和索引的任务,蜘蛛搜索引擎采用了多种技术手段:

抓取策略:包括深度优先遍历、广度优先遍历以及更智能的抓取策略,如基于内容新鲜度、网页重要性等动态调整抓取频率。

反科技技术:为了防止被反面网站欺骗(如隐藏文本、链接农场等),现代蜘蛛会采用各种反科技技术检测和过滤这类行为。

多线程和分布式抓取:为了提高抓取效率,蜘蛛程序通常采用多线程技术和分布式系统设计,允许同时从多个点抓取网页。

用户代理切换:为了避免被网站管理员阻止,蜘蛛程序能够更换不同的用户代理标识自己的身份。

遵守robots协议:这是互联网上的一个标准协议,用来告诉蜘蛛哪些页面可以抓取,哪些不可以。

相关问题与解答

Q1: 蜘蛛搜索引擎是如何辨别重要网页的?

A1: 蜘蛛搜索引擎通常会使用链接分析算法,如Google的PageRank,通过分析网页间的链接关系来确定哪些网页更重要,还会考虑网页内容的质量和相关性。

Q2: 为什么有些网站不愿意被蜘蛛搜索引擎抓取?

A2: 一些网站可能因为带宽限制或者想要保护版权内容,不希望被公开索引,他们可以通过robots.txt文件或meta标签来告知蜘蛛不要抓取或索引某些内容。

Q3: 蜘蛛搜索引擎如何处理动态网页?

A3: 动态网页的内容是在用户请求时才生成的,蜘蛛搜索引擎可以通过执行JavaScript代码或访问网站的预渲染版本来抓取动态内容。

Q4: 什么是蜘蛛池,它有什么作用?

A4: 蜘蛛池是一种包含大量蜘蛛程序的集群,它们协同工作以提高抓取效率,蜘蛛池常用于处理大规模的网页抓取任务,确保及时更新索引信息。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:https://www.xixizhuji.com/fuzhu/305918.html