gpu和cuda的关系

- 行业动态

- 2024-01-30

- 4087

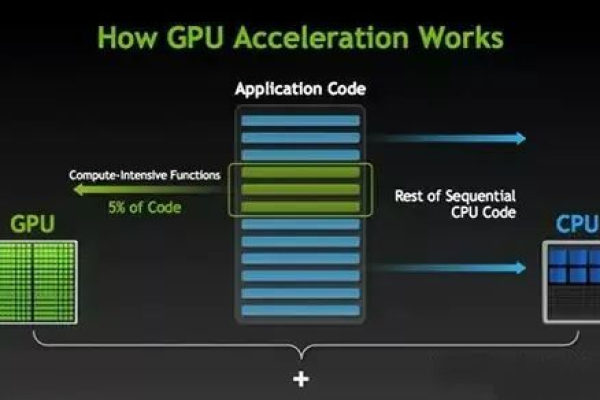

GPU是显卡的核心,负责处理图像数据,而CUDA则是NVIDIA推出的一种编程模型和软件环境。它允许开发者使用C、C++、Python等高级语言进行编程,并能加速GPU的运算和处理。CUDA和GPU的关系十分密切,它们共同构成了计算机图形处理和并行计算的重要部分。

在计算机图形处理和深度学习领域,GPU、CUDA和cuDNN是三个非常重要的概念,它们之间的关系密切,共同推动了这两个领域的发展,本文将对这三者的关系进行详细的介绍。

1、GPU(图形处理器)

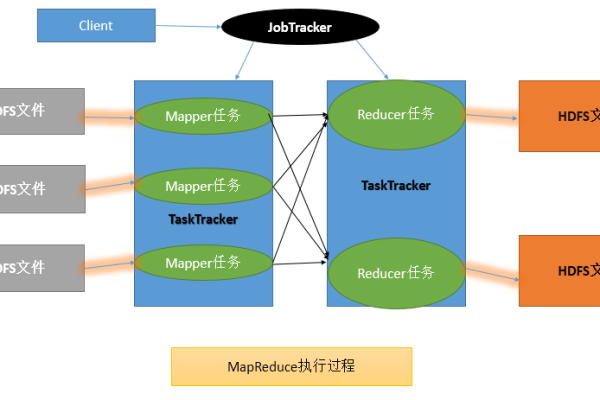

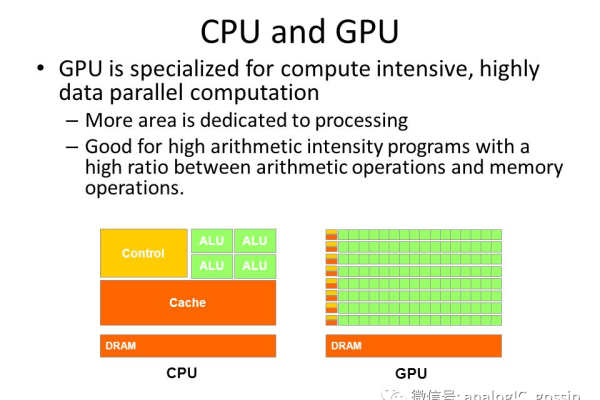

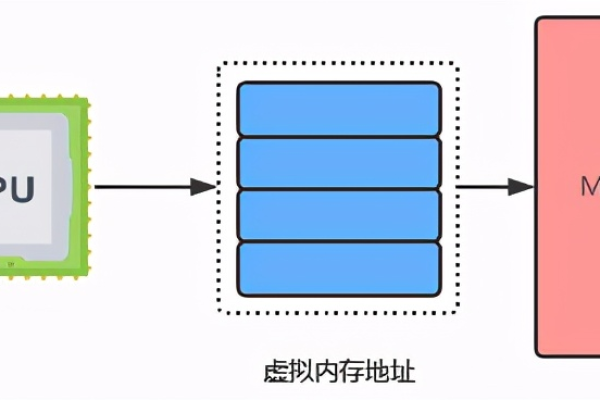

GPU(Graphics Processing Unit)是一种专门用于处理图形和图像的处理器,与CPU(中央处理器)相比,GPU具有更多的计算单元和更高的并行计算能力,因此在处理大量数据时具有更高的性能,随着技术的发展,GPU已经不仅仅局限于图形处理,而是广泛应用于各种需要大量并行计算的场景,如科学计算、深度学习等。

2、CUDA(统一计算设备架构)

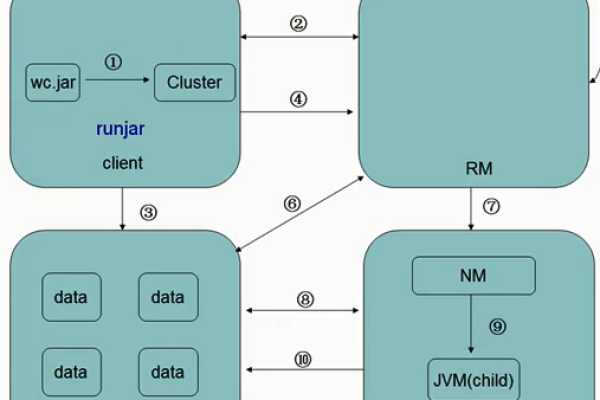

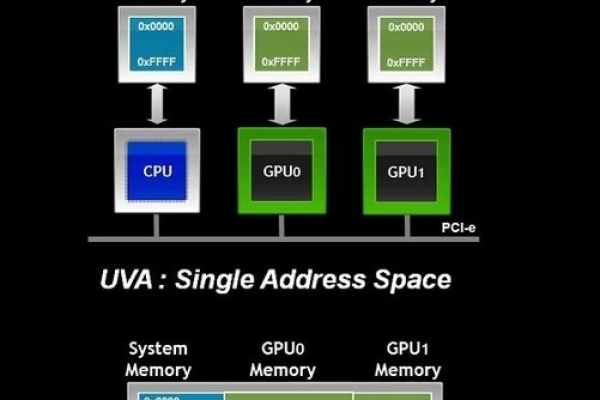

CUDA(Compute Unified Device Architecture)是由NVIDIA公司开发的一种通用并行计算架构,它允许开发人员使用C语言和CUDA C/C++编写程序,利用GPU的强大计算能力进行高性能计算,CUDA提供了一套完整的软件开发工具包,包括编译器、调试器、库函数等,帮助开发人员更容易地将应用程序移植到GPU上运行。

3、cuDNN(深度神经网络库)

cuDNN是NVIDIA公司开发的一个针对深度神经网络的GPU加速库,它基于CUDA架构,为深度学习框架(如TensorFlow、PyTorch等)提供了高效的卷积、池化、归一化等基本操作的实现,通过使用cuDNN,开发人员可以在GPU上实现高速的深度学习模型训练和推理。

4、三者之间的关系

GPU、CUDA和cuDNN之间的关系可以概括为:GPU是硬件设备,负责执行计算任务;CUDA是软件平台,提供了一种编程模型,使得开发人员可以利用GPU的强大计算能力;cuDNN是基于CUDA的深度学习库,为深度学习应用提供了高效的算法实现。

具体来说,CUDA为开发人员提供了一个统一的编程模型,使得他们可以使用C语言和CUDA C/C++编写程序,将这些程序部署到GPU上运行,而cuDNN则进一步扩展了CUDA的功能,为深度学习应用提供了专门的加速库,通过使用cuDNN,开发人员可以在GPU上实现高速的深度学习模型训练和推理。

GPU、CUDA和cuDNN三者共同构成了一个完整的高性能计算生态系统,推动了计算机图形处理和深度学习领域的发展。

相关问题与解答:

1、GPU、CUDA和cuDNN分别适用于哪些场景?

答:GPU主要适用于需要大量并行计算的场景,如图形处理、科学计算、深度学习等;CUDA是一种通用并行计算架构,适用于所有需要利用GPU计算能力的应用程序;cuDNN是一个针对深度神经网络的GPU加速库,主要用于深度学习模型的训练和推理。

2、CUDA和cuDNN之间有什么区别?

答:CUDA是一个通用并行计算架构,提供了一套完整的软件开发工具包,帮助开发人员更容易地将应用程序移植到GPU上运行;而cuDNN是基于CUDA的深度学习库,为深度学习框架提供了高效的算法实现,主要用于深度学习模型的训练和推理。

3、如何选择合适的GPU、CUDA版本和cuDNN版本?

答:选择合适的GPU需要考虑应用程序的需求和预算;选择合适的CUDA版本需要考虑应用程序的兼容性和支持程度;选择合适的cuDNN版本需要考虑深度学习框架的支持程度和性能需求,建议查阅相关文档和社区资源,了解各个版本的详细信息。

4、除了NVIDIA公司的GPU、CUDA和cuDNN之外,还有其他类似的技术吗?

答:除了NVIDIA公司的GPU、CUDA和cuDNN之外,还有一些其他类似的技术,AMD公司的ROCm平台提供了类似的GPU计算能力;Google的TPU(张量处理单元)提供了专门为深度学习设计的硬件加速器;还有一些开源的深度学习框架(如MXNet、TensorFlow等)提供了类似的功能,开发者可以根据自己的需求和技术背景选择合适的技术和平台。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/302817.html