VPS空间分割优化:提高使用效率的技巧

- 行业动态

- 2024-04-26

- 3

VPS空间分割优化是一种提高服务器使用效率的技巧,它可以将一个物理服务器划分为多个虚拟私有服务器(VPS),每个VPS都具有独立的操作系统、资源和文件系统,通过合理的空间分割,可以提高服务器的资源利用率,降低单个用户的开销,以下是一些建议和技巧,可以帮助您进行VPS空间分割优化:

1、选择合适的虚拟化技术

选择合适的虚拟化技术是进行VPS空间分割优化的基础,目前市场上常见的虚拟化技术有KVM、Xen、VMware等,不同的虚拟化技术具有不同的特点和性能,需要根据实际需求进行选择。

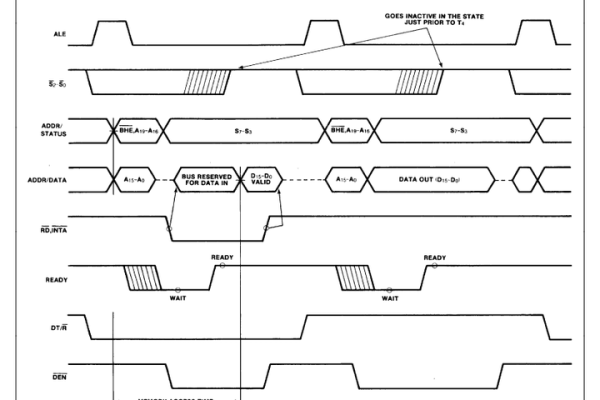

2、合理分配CPU资源

CPU资源是影响VPS性能的关键因素之一,在进行空间分割时,需要根据每个VPS的负载情况合理分配CPU资源,可以使用CPU亲和性(CPU affinity)功能,将某个VPS的进程绑定到特定的CPU核心上,从而提高其性能。

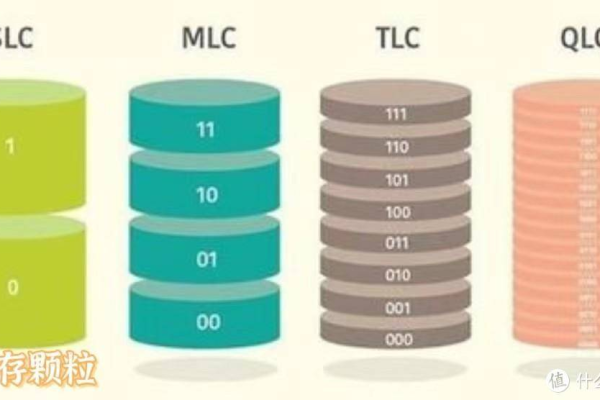

3、内存资源管理

内存资源对VPS的性能也有很大影响,在进行空间分割时,需要根据每个VPS的内存需求合理分配内存资源,可以使用内存共享(memory sharing)功能,让多个VPS共享同一块内存,从而节省内存资源。

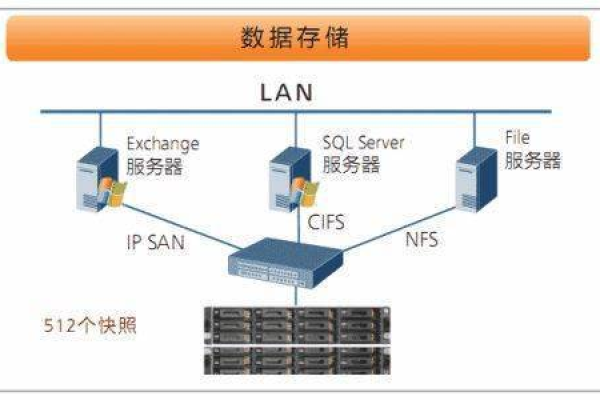

4、磁盘空间管理

磁盘空间是VPS存储数据的关键,在进行空间分割时,需要根据每个VPS的磁盘需求合理分配磁盘空间,可以使用磁盘配额(disk quota)功能,限制每个VPS的磁盘使用量,防止某个VPS过度占用磁盘空间。

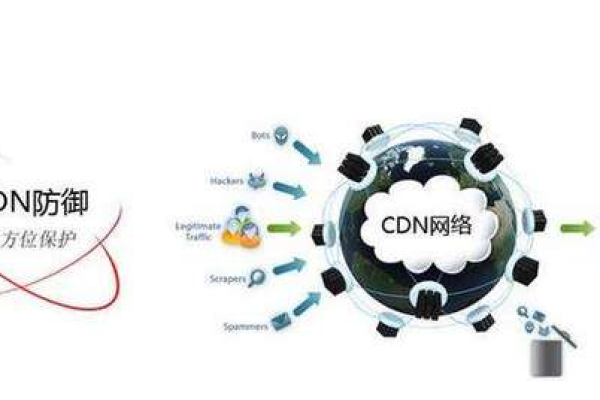

5、网络带宽管理

网络带宽是影响VPS访问速度的关键因素之一,在进行空间分割时,需要根据每个VPS的网络需求合理分配网络带宽,可以使用流量控制(traffic control)功能,限制每个VPS的网络流量,防止某个VPS过度占用网络带宽。

6、监控和调整

在进行VPS空间分割优化后,需要定期监控各个VPS的性能和使用情况,根据实际情况进行调整,可以使用性能监控工具(如cacti、Nagios等)来实时监控服务器的CPU、内存、磁盘和网络使用情况。

7、负载均衡

为了提高服务器的整体性能和可用性,可以使用负载均衡技术将请求分发到多个VPS上,常见的负载均衡技术有LVS、Nginx、HAProxy等,通过负载均衡,可以确保在某个VPS出现故障时,其他VPS仍然可以正常提供服务。