python如何开发爬虫

- 行业动态

- 2024-04-14

- 2980

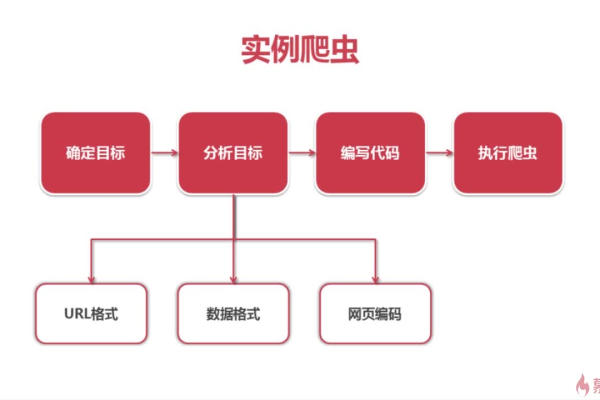

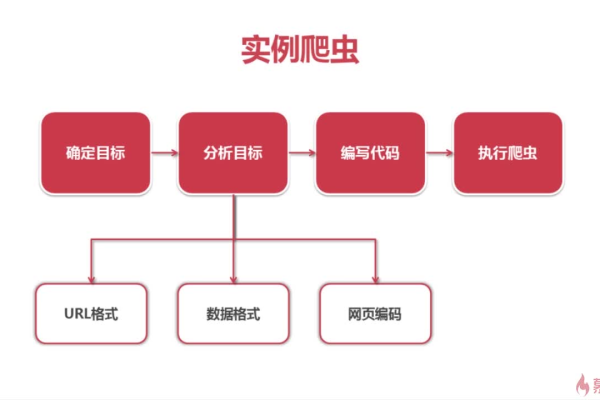

要开发一个Python爬虫,可以按照以下步骤进行:

1、安装所需库

确保已经安装了Python,使用pip安装以下库:

requests:用于发送HTTP请求

BeautifulSoup:用于解析HTML文档

re:用于正则表达式匹配

2、导入所需库

在Python脚本中,导入所需的库:

“`python

import requests

from bs4 import BeautifulSoup

import re

“`

3、发送HTTP请求

使用requests库发送HTTP请求,获取网页内容,访问一个网页并获取其HTML内容:

“`python

url = ‘https://example.com’

response = requests.get(url)

html_content = response.text

“`

4、解析HTML文档

使用BeautifulSoup库解析HTML文档,提取所需的信息,提取所有的标题标签(h1、h2等):

“`python

soup = BeautifulSoup(html_content, ‘html.parser’)

titles = soup.find_all([‘h1’, ‘h2’, ‘h3’, ‘h4’, ‘h5’, ‘h6’])

“`

5、提取所需信息

根据需求,使用正则表达式或其他方法提取所需的信息,提取所有链接的URL:

“`python

links = []

for link in soup.find_all(‘a’):

href = link.get(‘href’)

if href:

links.append(href)

“`

6、保存数据

将提取到的数据保存到文件或数据库中,将标题和链接保存到CSV文件中:

“`python

with open(‘output.csv’, ‘w’, encoding=’utf8′) as f:

f.write(‘Title,Link

‘)

for title, link in zip(titles, links):

f.write(f'{title.text},{link}

‘)

“`

7、处理异常和错误

在开发过程中,可能会遇到各种异常和错误,为了确保程序的稳定性,需要使用tryexcept语句处理异常,并在出现错误时输出有用的错误信息。

“`python

try:

# 爬虫代码

except Exception as e:

print(f’Error: {e}’)

“`

8、循环和调度爬虫任务(可选)

如果需要定期更新数据或爬取多个网页,可以使用循环和调度库(如schedule)来定时执行爬虫任务。

“`python

import schedule

import time

def crawl():

# 爬虫代码

pass

# 每天凌晨1点执行爬虫任务

schedule.every().day.at(’01:00′).do(crawl)

while True:

schedule.run_pending()

time.sleep(60) # 每分钟检查一次是否有任务需要执行

“`

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/284414.html