Python爬虫是干什么的

- 行业动态

- 2024-07-11

- 2202

Python爬虫是一种自动获取网页内容的程序,它通过模拟浏览器发送请求,从网站上抓取所需的数据。Python爬虫可以用于数据采集、网络监控、自动化测试等领域。

Python爬虫,也称为网络爬虫或网页蜘蛛,是一种自动从互联网上抓取信息的程序或脚本。

在当今信息化、数据驱动的时代,Python爬虫技术以其灵活性和强大的数据处理能力成为不可或缺的重要工具,下面将详细阐述Python爬虫的相关内容:

1、Python爬虫的定义与基本原理

定义:Python爬虫,按照一定规则自动地抓取万维网信息的程序。

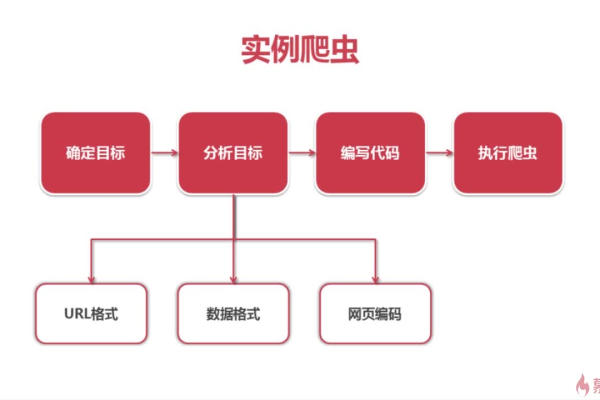

基本原理:包括发起请求、获取响应内容、解析内容以及保存数据等步骤。

2、Python爬虫的应用领域

数据收集:如搜索引擎、学术研究、竞品分析等。

价格监控:商家和消费者可以使用爬虫监控商品价格。

自动化任务:例如批量下载文件、数据备份、自动化测试等。

网络监测:如网站状态监控、舆情分析等。

API数据的获取:模拟用户操作获取数据。

个人信息自动化处理:自动登录、收集信息、自动填表等。

3、Python爬虫的架构

调度器、URL管理器、网页下载器、网页解析器和应用程序五个部分相互协调工作完成爬虫任务。

Python爬虫不仅为人们提供了高效获取互联网数据的手段,还因其灵活的应用场景和强大的功能而受到广泛欢迎,掌握Python爬虫技术,意味着能够更好地利用互联网上的海量数据资源,无论是对个人学习提升、企业市场分析还是科研数据采集都有着不可估量的价值。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/267173.html