Java中的时间戳是什么?如何获取和处理?

- 行业动态

- 2024-10-30

- 5

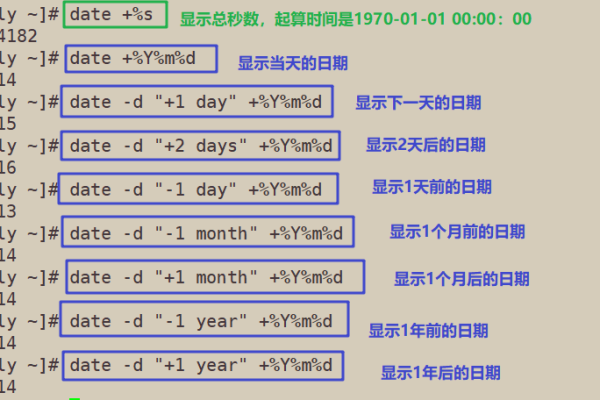

Java时间戳是指从1970年1月1日00:00:00 UTC到当前时间的总毫秒数。

Java时间戳是编程中常用的概念,它表示自1970年1月1日00:00:00 UTC以来的毫秒数,在Java中,时间戳通常用于记录事件发生的时间点,便于后续的时间计算和比较,本文将深入探讨Java时间戳的概念、使用方法以及常见问题解答。

Java时间戳的基本概念

在Java中,时间戳通常通过System.currentTimeMillis()方法获取,该方法返回当前时间的毫秒数,这个值是一个长整型(long),可以用来表示从1970年1月1日00:00:00 UTC到当前时刻所经过的毫秒数。

获取当前时间戳

要获取当前时间的时间戳,可以使用以下代码:

long currentTimeMillis = System.currentTimeMillis();

System.out.println("Current Time Millis: " + currentTimeMillis);

这段代码会输出当前时间的毫秒数,1625079045123。

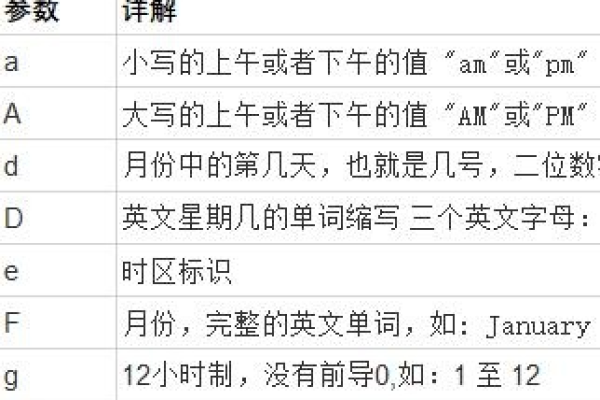

将时间戳转换为日期格式

为了将时间戳转换为可读的日期格式,可以使用SimpleDateFormat类,以下是一个例子:

import java.text.SimpleDateFormat;

import java.util.Date;

public class TimeStampExample {

public static void main(String[] args) {

long timeStamp = System.currentTimeMillis();

Date date = new Date(timeStamp);

SimpleDateFormat formatter = new SimpleDateFormat("yyyy-MM-dd HH:mm:ss");

String formattedDate = formatter.format(date);

System.out.println("Formatted Date: " + formattedDate);

}

}

这段代码会将当前时间戳转换为格式化的日期字符串,2021-07-01 12:30:45。

表格展示时间戳与日期的转换

| 时间戳 (毫秒) | 日期格式 (yyyy-MM-dd HH:mm:ss) |

| 1625079045123 | 2021-07-01 12:30:45 |

常见问题解答

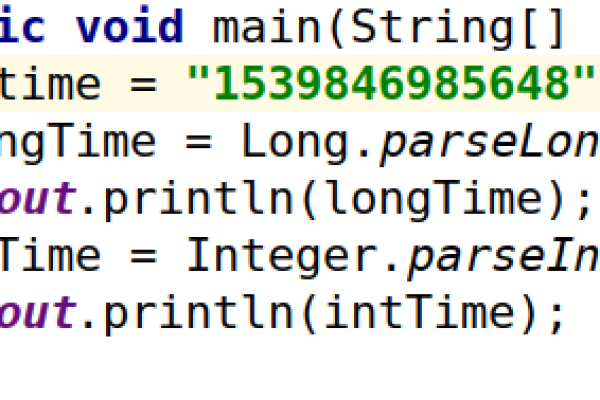

问题1:如何将字符串形式的时间戳转换为日期对象?

要将字符串形式的时间戳转换为Date对象,首先需要将字符串解析为长整型,然后使用new Date(long time)构造函数创建日期对象,以下是一个示例:

import java.text.ParseException;

import java.text.SimpleDateFormat;

import java.util.Date;

public class StringToDateExample {

public static void main(String[] args) {

String timeStampStr = "1625079045123";

long timeStamp = Long.parseLong(timeStampStr);

Date date = new Date(timeStamp);

SimpleDateFormat formatter = new SimpleDateFormat("yyyy-MM-dd HH:mm:ss");

String formattedDate = formatter.format(date);

System.out.println("Formatted Date: " + formattedDate);

}

}

问题2:如何计算两个时间戳之间的差值?

要计算两个时间戳之间的差值,可以直接相减得到结果,结果单位为毫秒,以下是一个示例:

public class TimeDifferenceExample {

public static void main(String[] args) throws InterruptedException {

long startTime = System.currentTimeMillis();

// 模拟一些操作,这里使用Thread.sleep来模拟耗时操作

Thread.sleep(2000); // 休眠2秒

long endTime = System.currentTimeMillis();

long difference = endTime startTime;

System.out.println("Time Difference in milliseconds: " + difference);

}

}

这段代码会输出大约2000毫秒,表示两个时间戳之间的差值。

Java时间戳是一个非常重要的概念,它不仅用于记录时间点,还广泛应用于日志记录、性能监控等领域,通过上述介绍和示例,相信读者对Java时间戳有了更深入的了解。