如何在安卓平板上安装Linux操作系统?

- 行业动态

- 2024-09-10

- 6

将安卓平板更换为Linux操作系统,不仅能提升平板的使用效率,还能让用户体验到不同操作系统带来的多样化功能,下面将详细介绍如何实现这一转换过程:

1、准备工作

检查平板电脑兼容性:确保平板电脑满足安装Linux系统的必备条件,检查启动引导模式是否为UEFI,因为Linux系统和Windows系统的引导模式不同,确认平板的存储容量是否足够以容纳Linux系统及其后续可能的软件安装需要。

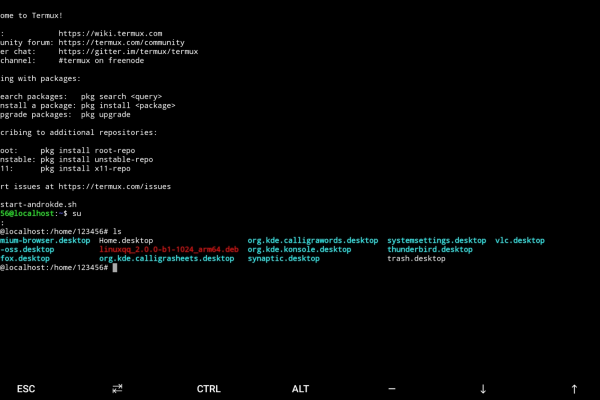

开启开发者模式和USB调试:在平板的设置中找到开发者选项并将其启用,对于MatePad设备,可以在“关于本机”中连续点击版本号来启用开发者模式,启用后,打开USB调试选项,以便让平板能够与电脑进行ADB通讯。

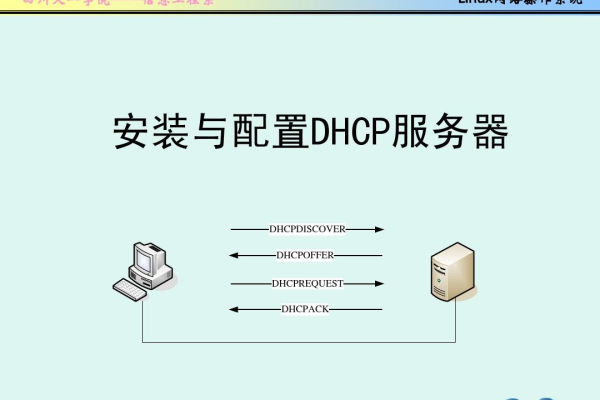

2、安装流程

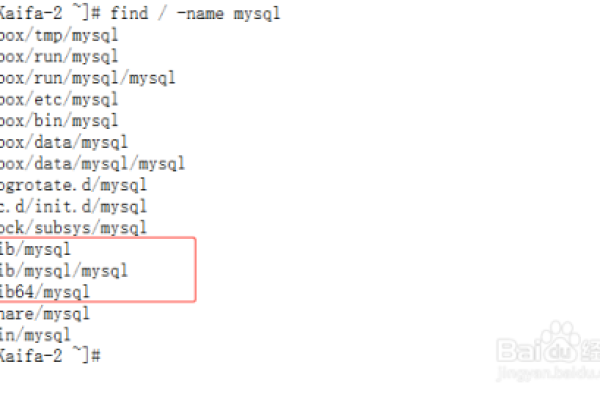

格式化存储介质:在开始安装Linux之前,需要将USB插口对应的存储设备进行格式化,以准备存放Linux系统的安装文件。

烧录Linux ISO文件:下载合适的Linux ISO文件并使用工具将其烧录到已格式化的USB存储设备上,这一步是整个安装过程的关键,决定了安装是否能够顺利进行。

手动分区:使用Linux安装程序对平板进行手动分区,并确定Linux系统的安装位置,分区时需谨慎,避免破坏原有数据。

选择启动操作系统:在安装过程中需要选择默认的开机启动操作系统,这里通常可以选择Linux作为主要或唯一的操作系统启动选项。

完成安装并重启:按照指引完成Linux系统的安装过程,并在结束后重新启动平板电脑,如果一切顺利,开机后应该能够进入新装的Linux操作系统开始使用。

3、后期配置

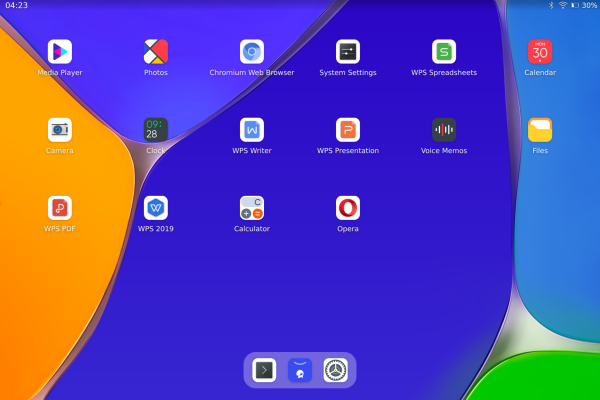

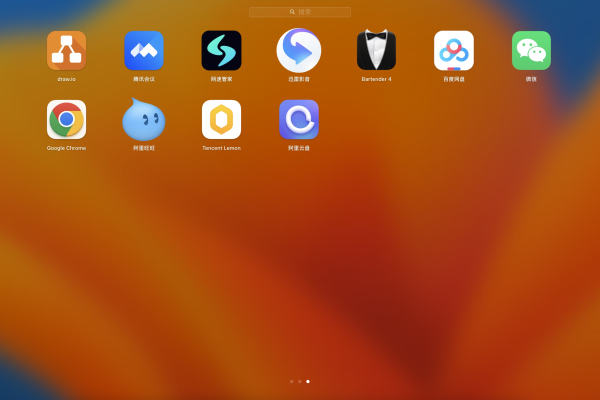

安装桌面和软件:根据个人需求,用户可以选择合适的桌面环境并进行安装,Linux的生态系统提供了丰富的免费程序和应用,可以根据需要自行安装,大大增强平板的实用性。

适配驱动:安装Linux系统后,最重要的一步是确保所有硬件都能正常工作,这可能需要寻找或自行编译适配平板电脑硬件的驱动,没有正确的驱动,一些硬件(如屏幕、WiFi模块等)可能无法正常工作。

至此,用户应该能够在其安卓平板上顺利运行Linux操作系统,享受不同于安卓系统的全新体验,在操作过程中可能会遇到各种问题,以下是一些常见问题及其解决方法:

问题一:如何选择合适的Linux发行版?

解答:选择Linux发行版时,应考虑平板的硬件配置及个人使用需求,对于资源受限的设备,可以选择轻量级的发行版如Ubuntu MATE或Lubuntu,还需要考虑发行版的技术支持和社区活跃度,以确保使用过程中遇到问题能够及时得到解决。

问题二:Linux系统安装失败怎么办?

解答:确认ISO文件是否完好无损,并且烧录过程是否正确,检查USB驱动是否正确加载,以及平板是否识别USB存储设备,重新检查分区过程是否有误,有时不正确的分区会导致安装失败,如果问题依旧,建议搜索具体的错误信息寻求解决方案或访问相关论坛求助。

将安卓平板更换为Linux系统是一个复杂但有趣的过程,只要严格遵循步骤并注意细节,大多数用户都能成功实现系统的转换,通过更换系统,不仅能够延长平板的使用寿命,还能探索更多操作系统带来的可能性。