什么是拒绝服务攻击,它如何影响网络安全?

- 行业动态

- 2024-11-14

- 5

拒绝服务攻击(Denial of Service Attack,简称DoS攻击)是一种通过向目标系统发送大量请求或数据包,使其无法正常响应合法用户的请求,从而造成服务中断的攻击行为,随着互联网的普及和技术的发展,DoS攻击已经成为网络安全领域的一大威胁,本文将对拒绝服务攻击进行详细介绍,包括其定义、分类、原理、危害及防御措施等方面的内容。

拒绝服务攻击的定义

拒绝服务攻击是指利用网络协议和系统的缺陷,通过向目标系统发送大量请求或数据包,使其无法正常响应合法用户的请求,从而造成服务中断的攻击行为,这种攻击通常会导致目标系统的资源耗尽,如CPU、内存、带宽等,从而使其无法正常工作。

拒绝服务攻击的分类

根据攻击方式的不同,拒绝服务攻击可以分为以下几种类型:

1、洪水攻击(Flood Attack):通过向目标系统发送大量的请求或数据包,使其资源耗尽,从而无法响应合法用户的请求,洪水攻击又可以分为UDP洪水攻击、TCP洪水攻击、ICMP洪水攻击等。

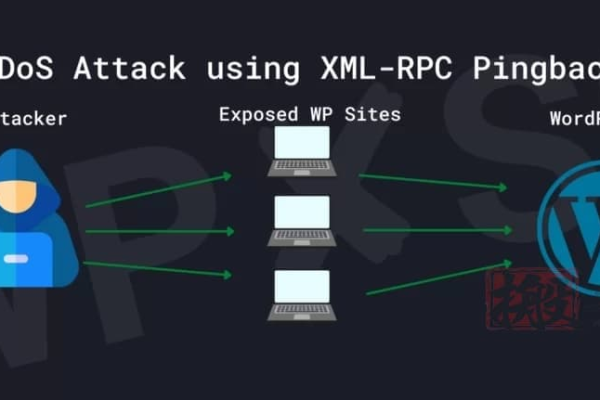

2、放大攻击(Amplification Attack):利用网络协议的破绽,将少量的请求放大成大量的响应,从而消耗目标系统的资源,DNS放大攻击就是利用DNS协议的破绽,将少量的DNS查询请求放大成大量的DNS响应。

3、分布式拒绝服务攻击(Distributed Denial of Service Attack,简称DDoS攻击):通过控制大量的僵尸计算机(也称为“肉鸡”),同时向目标系统发起攻击,使其资源耗尽,DDoS攻击具有更高的破坏力和更难防范的特点。

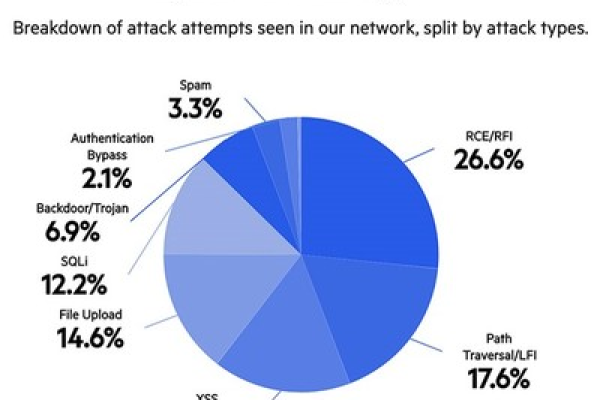

4、应用层拒绝服务攻击(Application Layer Denial of Service Attack):针对特定应用程序的破绽进行攻击,使其无法正常工作,针对Web服务器的HTTP洪水攻击、针对数据库的SQL注入攻击等。

拒绝服务攻击的原理

拒绝服务攻击的原理主要是通过向目标系统发送大量的请求或数据包,使其资源耗尽,从而无法响应合法用户的请求,攻击者可以利用以下几种手段实现这一目的:

1、利用网络协议的破绽:TCP协议中的SYN Flood攻击,攻击者发送大量的SYN请求包,但不完成三次握手过程,导致目标系统的TCP连接表被占满,从而无法接受新的连接请求。

2、利用系统资源的有限性:CPU、内存、带宽等资源都是有限的,攻击者可以通过发送大量的请求或数据包,使目标系统的这些资源耗尽,从而导致服务中断。

3、利用应用程序的破绽:针对Web服务器的HTTP洪水攻击,攻击者发送大量的HTTP请求,使Web服务器的线程池被占满,从而无法处理新的请求。

拒绝服务攻击的危害

拒绝服务攻击对目标系统和服务造成了极大的危害,主要表现在以下几个方面:

1、服务中断:拒绝服务攻击会导致目标系统无法正常响应合法用户的请求,从而使服务中断,这会给企业和个人带来严重的经济损失和信誉损失。

2、数据丢失:在拒绝服务攻击过程中,目标系统可能会因为资源耗尽而崩溃,从而导致数据丢失,这对于依赖数据的企业和个人来说,无疑是一场灾难。

3、系统瘫痪:严重的拒绝服务攻击可能会导致目标系统长时间无法恢复正常工作,甚至需要重新安装操作系统和应用软件,这将给企业和个人带来巨大的恢复成本和时间损失。

4、法律风险:对于发起拒绝服务攻击的攻击者来说,一旦被查获,将面临严重的法律责任,受害者还可以通过法律途径追究攻击者的赔偿责任。

拒绝服务攻击的防御措施

为了有效防范拒绝服务攻击,可以采取以下几种防御措施:

1、增加带宽和硬件资源:提高目标系统的带宽和硬件资源,可以在一定程度上抵御洪水攻击和DDoS攻击,但这种方法并不能解决所有问题,因为攻击者可以通过不断增加攻击流量来消耗更多的资源。

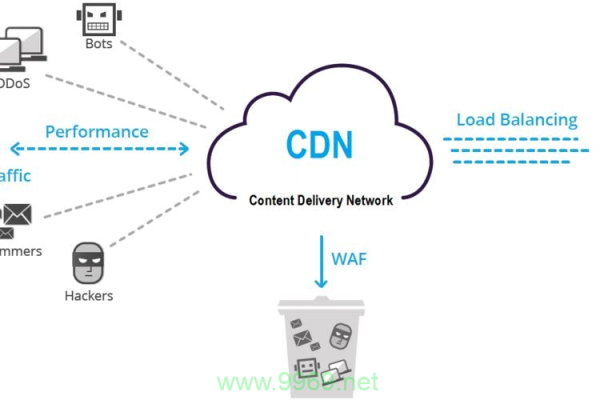

2、使用防火墙和载入检测系统:防火墙可以过滤掉一部分反面请求和数据包,载入检测系统可以及时发现并报警异常流量,这两种设备可以帮助管理员快速定位和应对攻击事件。

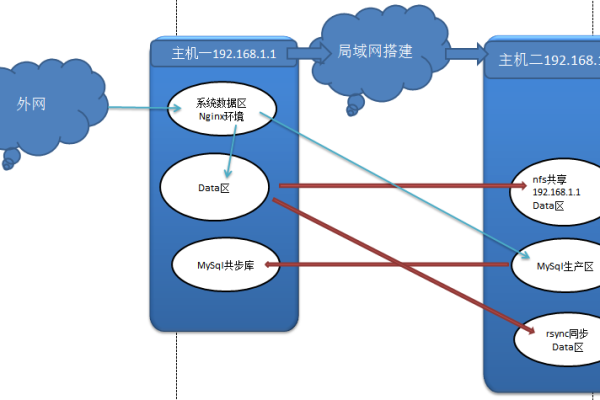

3、采用负载均衡技术:通过将流量分散到多个服务器上进行处理,可以降低单个服务器的压力,从而提高整个系统的抗攻击能力,常见的负载均衡技术有DNS轮询、IP哈希等。

4、优化应用程序和服务器配置:针对特定应用程序的破绽进行修复和优化,可以提高其抗攻击能力,合理配置服务器参数(如最大连接数、超时时间等),也可以降低被攻击的风险。

5、建立应急响应机制:制定详细的应急预案和流程,明确各部门和个人的职责和任务,可以在发生攻击事件时迅速采取措施进行应对和恢复,定期进行演练和培训也是提高应急响应能力的重要手段。

相关问答FAQs

1、什么是拒绝服务攻击?它有哪些特点?

答:拒绝服务攻击是一种通过向目标系统发送大量请求或数据包,使其无法正常响应合法用户的请求,从而造成服务中断的攻击行为,它具有以下特点:(1)利用网络协议和系统的缺陷;(2)通过消耗目标系统的资源来实现目的;(3)可能导致服务中断、数据丢失、系统瘫痪等严重后果;(4)发起攻击的攻击者可能面临法律责任。

2、如何防范拒绝服务攻击?有哪些有效的防御措施?

答:为了有效防范拒绝服务攻击,可以采取以下几种防御措施:(1)增加带宽和硬件资源;(2)使用防火墙和载入检测系统;(3)采用负载均衡技术;(4)优化应用程序和服务器配置;(5)建立应急响应机制,这些措施可以帮助提高目标系统的抗攻击能力,降低被攻击的风险。

以上内容就是解答有关“拒绝服务攻击”的详细内容了,我相信这篇文章可以为您解决一些疑惑,有任何问题欢迎留言反馈,谢谢阅读。