如何正确使用服务器IP地址,它是关键网络标识吗?

- 行业动态

- 2024-10-09

- 10

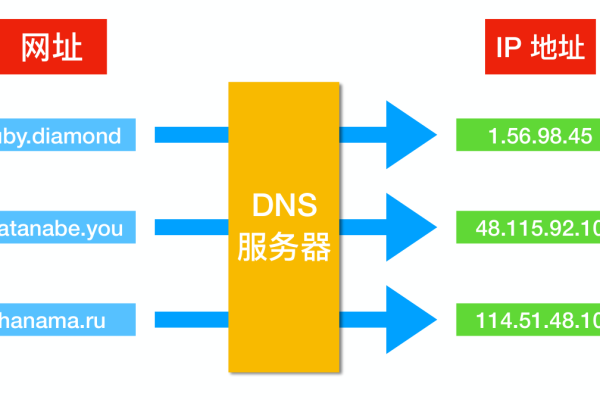

服务器的IP地址是网络中用于标识和定位服务器的数字标签,它是互联网协议(Internet Protocol)的一部分,IP地址使得设备能够在互联网或局域网中相互通信,以下是关于如何使用服务器IP地址的详细介绍。

什么是IP地址?

IP地址是一个32位的数字序列,通常表示为四个十进制数,每个数字之间用点分隔,192.168.1.1,每个数字的取值范围是0到255。

IP地址的类型

IP地址分为两种主要类型:IPv4和IPv6,IPv4是最常见的版本,而IPv6是为了解决IPv4地址耗尽问题而开发的新版本。

IPv4: 如上所述,由四个十进制数组成,总共有大约43亿个可能的地址。

IPv6: 由八个十六进制数组成,每四个数字用冒号分隔,2001:0db8:85a3:0000:0000:8a2e:0370:7334。

如何获取服务器的IP地址

要使用服务器的IP地址,首先需要知道它是什么,以下是几种获取服务器IP地址的方法:

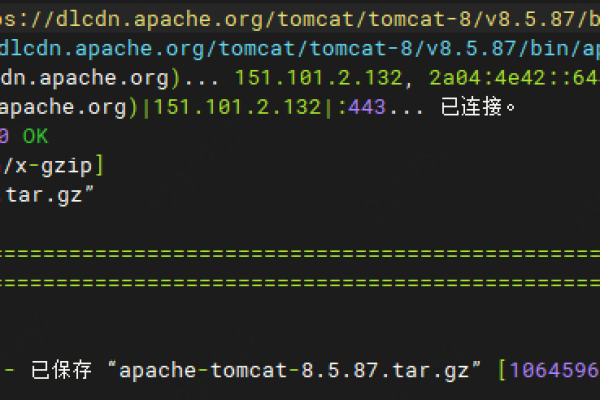

1、通过命令提示符/终端:

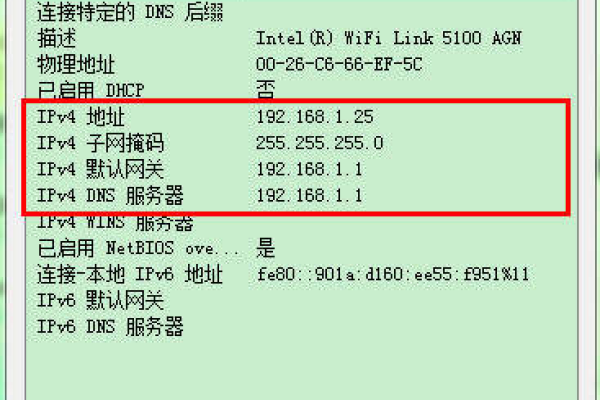

在Windows中,打开命令提示符,输入ipconfig并按回车键,查找“IPv4 地址”。

在Linux或MacOS中,打开终端,输入ifconfig或ip a并按回车键,查找“inet”后面的地址。

2、通过网络管理界面:

许多路由器和网络设备提供了基于Web的管理界面,可以从中查看连接设备的IP地址。

3、询问ISP或网络管理员:

如果你是从ISP或网络管理员处租用的服务器,他们可以提供服务器的IP地址。

如何使用服务器的IP地址

一旦你有了服务器的IP地址,你可以用它来执行多种操作,例如远程登录、文件传输、网站访问等。

远程登录

如果你需要远程登录到服务器,可以使用SSH(对于Linux服务器)或RDP(对于Windows服务器)。

SSH: 在终端或命令提示符中输入以下命令:

ssh username@server_ip_address

替换username为你的用户名,server_ip_address为服务器的IP地址。

RDP: 在Windows中,点击“开始”>“运行”,输入mstsc并按回车键,在弹出的窗口中输入服务器的IP地址。

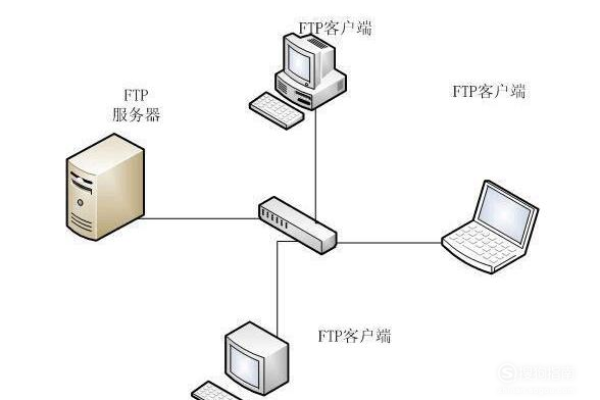

文件传输

使用FTP(文件传输协议)客户端,如FileZilla,连接到服务器并传输文件。

1、打开FTP客户端。

2、输入主机名(即服务器的IP地址)。

3、输入用户名和密码。

4、点击“快速连接”按钮。

网站访问

如果你想访问托管在服务器上的网站,只需在浏览器的地址栏中输入服务器的IP地址即可,输入http://192.168.1.1将尝试访问该IP地址上的网站。

注意事项

确保你有权限访问和使用该IP地址对应的服务器。

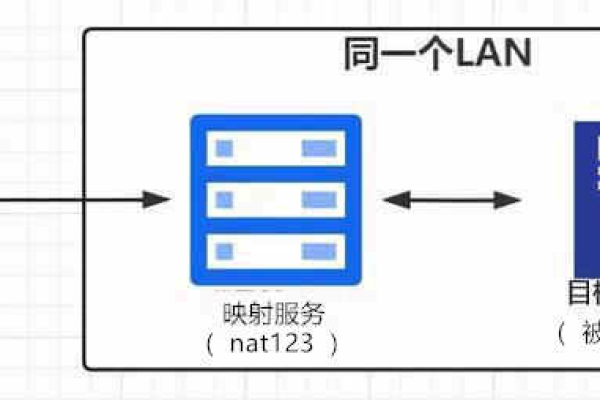

如果服务器位于防火墙后面,可能需要进行端口转发或网络传输层设置才能访问。

保持服务器的安全配置,避免未授权的访问。

通过上述方法,你可以有效地使用服务器的IP地址来管理和访问服务器资源。

| 问题 | 答案 |

| 什么是服务器的IP地址? | 服务器的IP地址是互联网上唯一标识一个服务器的数字地址,类似于家庭地址,用于在互联网中定位和识别特定的服务器。 |

| 服务器的IP地址有什么用? | 帮助用户访问服务器上的资源和服务,如网站、数据库、电子邮件等。 确保数据传输的安全性,因为IP地址可以用于网络访问控制和身份验证。 在网络中识别和区分不同的服务器。 |

| 如何获取服务器的IP地址? | 在浏览器中输入服务器的域名,浏览器会自动解析域名并获取对应的IP地址。 使用命令行工具,如ping命令,直接查询服务器的IP地址。 通过网络管理工具或服务查看服务器的配置信息。 |

| 如何使用服务器的IP地址? | 使用IP地址通过浏览器访问服务器上的网站。 使用IP地址通过SSH连接到服务器进行远程管理。 使用IP地址进行网络通信,如发送邮件、访问数据库等。 |

| 需要注意什么? | 确保输入正确的IP地址,以避免连接到错误的服务器。 注意网络安全,避免泄露IP地址等敏感信息。 定期检查IP地址的可用性和安全性。 |