如何使用xlsread函数在MATLAB中读取Excel文件?

- 行业动态

- 2024-12-09

- 5

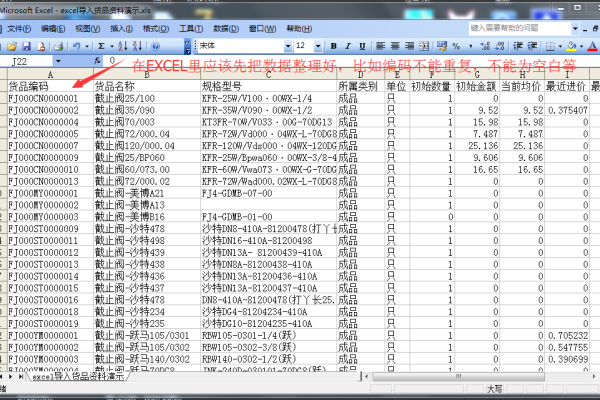

在处理数据和分析工作中,Excel 文件是最常用的格式之一,Python 提供了多种库来读取和操作 Excel 文件,其中xlsread 是一种非常流行的工具,本文将详细介绍如何使用xlsread 来读取 Excel 文件,并提供相关示例和常见问题解答。

一、安装与导入 `xlsread`

需要确保你已经安装了xlsread 库,如果尚未安装,可以使用以下命令进行安装:

pip install xlsread

安装完成后,可以在 Python 脚本中导入该库:

import xlsread

二、基本使用方法

xlsread 可以读取 Excel 文件中的数据并将其转换为 Pandas DataFrame,以便进一步处理和分析,以下是一个简单的示例:

示例代码

import xlsread 读取 Excel 文件 file_path = 'example.xlsx' data = xlsread(file_path) 打印读取的数据 print(data)

在这个示例中,我们使用xlsread 函数读取名为example.xlsx 的 Excel 文件,并将读取到的数据存储在变量data 中,我们打印出读取的数据。

三、读取多个工作表

如果你的 Excel 文件包含多个工作表,xlsread 也可以一次性读取所有工作表的数据,以下是一个示例:

示例代码

import xlsread

读取 Excel 文件并获取所有工作表的数据

file_path = 'example.xlsx'

all_sheets_data = xlsread(file_path, sheet_names=None)

打印每个工作表的名称和数据

for sheet_name, data in all_sheets_data.items():

print(f"Sheet Name: {sheet_name}")

print(data)

在这个示例中,我们使用xlsread 函数读取 Excel 文件,并通过设置sheet_names=None 参数来读取所有工作表的数据,返回的结果是一个字典,键为工作表名称,值为对应的数据。

四、指定工作表读取

如果你只想读取特定的工作表,可以通过sheet_name 参数来指定工作表的名称:

示例代码

import xlsread 读取指定的工作表 file_path = 'example.xlsx' sheet_name = 'Sheet1' data = xlsread(file_path, sheet_name=sheet_name) 打印读取的数据 print(data)

在这个示例中,我们使用xlsread 函数读取名为Sheet1 的工作表,并将读取到的数据存储在变量data 中。

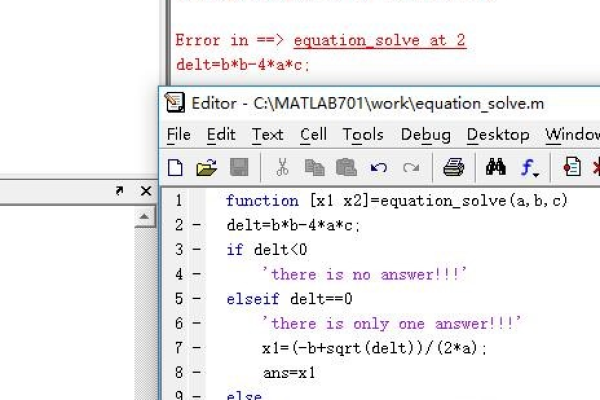

五、常见错误及解决方法

在使用xlsread 过程中,可能会遇到一些常见的错误,以下是几个常见问题及其解决方法:

1. 文件路径错误

问题描述:文件路径不正确或文件不存在。

解决方法:确保文件路径正确且文件存在,可以使用绝对路径来避免路径错误。

2. 工作表名称错误

问题描述:指定的工作表名称不存在。

解决方法:确保工作表名称正确,可以使用xlsread 读取所有工作表的名称来确认。

3. 依赖库缺失

问题描述:缺少必要的依赖库,如 Pandas。

解决方法:安装所需的依赖库,安装 Pandas:

pip install pandas

六、FAQs

Q1:如何读取 Excel 文件中的特定单元格?

A1:可以使用xlsread 读取整个工作表后,通过索引访问特定的单元格。

import xlsread 读取 Excel 文件 file_path = 'example.xlsx' data = xlsread(file_path) 访问特定单元格(第1行第1列) cell_value = data.iloc[0, 0] print(cell_value)

Q2:如何处理 Excel 文件中的空值?

A2:Pandas 会自动处理空值并将其表示为NaN,你可以使用 Pandas 的方法来填充或删除空值。

import xlsread 读取 Excel 文件 file_path = 'example.xlsx' data = xlsread(file_path) 填充空值为0 data.fillna(0, inplace=True) print(data)

小编有话说

通过本文的介绍,相信大家对xlsread 的使用有了更深入的了解,无论是读取整个工作表还是特定单元格,xlsread 都提供了简单而强大的功能,在实际工作中,可以根据具体需求选择合适的方法来读取和处理 Excel 文件,希望本文对你有所帮助,祝大家在数据处理的道路上越走越远!