如何创建SQL节点以拉取已有表数据?

- 行业动态

- 2024-12-10

- 8

sql,SELECT * FROM your_table_name;,`

,,请将 your_table_name` 替换为你要查询的实际表名。这段代码将从指定的表中拉取所有数据。

在数据库管理中,创建SQL节点以拉取已有表数据是一项常见的操作,通过这一过程,我们可以从现有的数据库表中提取数据,进行进一步的分析、处理或展示,下面将详细介绍如何创建SQL节点并拉取已有表数据的步骤和注意事项。

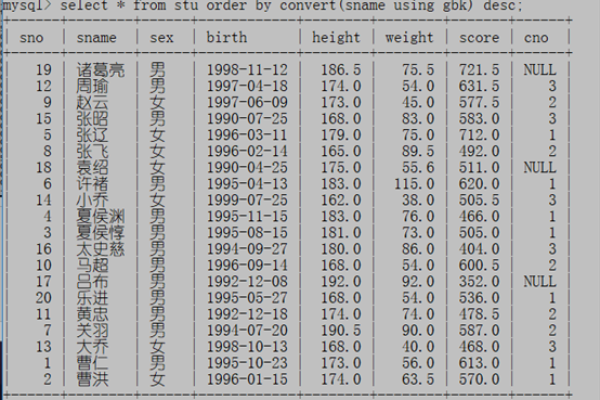

我们需要明确要拉取的数据来源,即确定目标数据库和表,这可以通过数据库管理系统(DBMS)的界面或者命令行工具来完成,如果我们使用的是MySQL数据库,可以通过以下命令连接到数据库:

mysql -u username -p database_name

username是数据库用户名,database_name是要连接的数据库名称,输入密码后,我们就可以进入数据库的命令行界面,开始执行SQL语句。

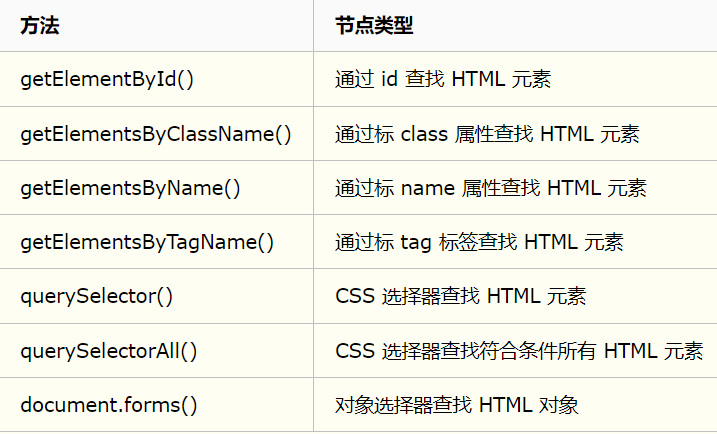

我们需要创建一个SQL节点,在SQL中,节点通常指的是一个查询或操作,它可以用来拉取、过滤、排序等处理数据,为了拉取已有表的数据,我们通常会使用SELECT语句,假设我们要从一个名为employees的表中拉取所有员工的信息,可以使用以下SQL语句:

SELECT * FROM employees;

这条语句会返回employees表中的所有列和所有行的数据,如果我们只对某些特定的列感兴趣,比如员工的姓名和职位,可以修改为:

SELECT name, position FROM employees;

这样,我们就只会拉取员工的姓名和职位信息。

在实际应用中,我们可能还需要对拉取的数据进行一些条件过滤,这时,可以在SELECT语句中加入WHERE子句,如果我们只想拉取职位为“Manager”的员工信息,可以使用以下语句:

SELECT * FROM employees WHERE position = 'Manager';

我们还可以利用ORDER BY子句对结果进行排序,以及使用LIMIT子句限制返回的记录数,按员工入职日期倒序排列,并只拉取前10条记录:

SELECT * FROM employees ORDER BY hire_date DESC LIMIT 10;

在拉取数据的过程中,还需要注意一些性能优化的问题,对于大表来说,全表扫描可能会非常耗时,建议在可能的情况下为经常查询的列建立索引,以提高查询效率,也要注意避免在WHERE子句中使用会导致全表扫描的条件。

为了方便后续的数据处理和分析,我们可能需要将拉取的数据导出到文件或另一个数据库中,大多数DBMS都提供了数据导出的功能,在MySQL中,可以使用INTO OUTFILE语句将查询结果导出到文本文件:

SELECT * FROM employees INTO OUTFILE '/path/to/file.txt' FIELDS TERMINATED BY ',' ENCLOSED BY '"' LINES TERMINATED BY ' ';

这条语句会将employees表的所有数据导出到一个CSV文件中,每条记录占一行,字段之间用逗号分隔,字段值用双引号包围。

相关问答FAQs:

Q1: 如何在SQL中拉取特定条件下的数据?

A1: 在SQL中,可以使用WHERE子句来指定拉取数据的条件。SELECT * FROM table_name WHERE condition;,其中condition是你要筛选的条件表达式。

Q2: 如何提高SQL查询的性能?

A2: 提高SQL查询性能的方法有很多,包括为经常查询的列建立索引、避免使用会导致全表扫描的条件、合理使用JOIN操作减少数据传输量、以及使用专业的数据库优化工具进行分析和调优。

小编有话说:创建SQL节点拉取已有表数据是数据库管理和数据分析的基本技能之一,通过掌握这些技能,我们可以更高效地处理和利用数据库中的信息,希望本文的介绍能够帮助大家更好地理解和应用SQL查询,从而在实际工作中发挥更大的作用。