本地磁盘怎么转移

- 行业动态

- 2024-03-03

- 6

本地磁盘转移通常涉及物理拆卸硬盘、连接新系统,或使用数据传输工具将数据复制到新位置。确保备份数据以防丢失。

在当今数字化时代,数据已成为个人和企业最宝贵的资产之一,随着云计算技术的成熟和普及,将本地硬盘数据迁移到云端成为了一种趋势,不仅能够提供更加灵活的数据访问方式,还能够增强数据的安全性和可靠性,下面将详细介绍如何将本地硬盘数据迁移到云服务器,并确保数据安全。

数据迁移前的准备

选择合适的云服务提供商

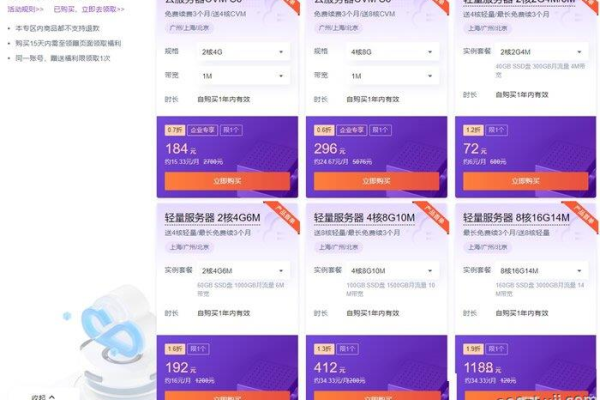

选择一个可靠的云服务提供商是关键,目前市场上主流的云服务商如阿里云、腾讯云、华为云等,都提供了丰富的迁移工具和服务,在选择时需考虑其稳定性、安全性、价格以及是否满足特定的业务需求。

评估数据量和类型

在进行迁移之前,需要对本地硬盘的数据量和类型进行详细的评估,这包括了解数据的大小、文件的数量、数据的结构等,以便选择正确的迁移策略和工具。

制定迁移计划

制定一个详细的迁移计划,其中包括迁移的时间安排、人员分工、预期目标等,还需要备份所有数据以防万一。

数据迁移过程

数据备份

在迁移之前,务必对本地硬盘的所有数据进行备份,可以使用本地备份或云备份服务来确保数据的安全。

选择合适的迁移方法

根据数据量和网络条件,可以选择不同的迁移方法:

1、直接复制:适合数据量较小,网络条件良好的情况。

2、使用迁移工具:云服务商通常提供数据传输服务(如阿里云的OSS Migration,腾讯云的COS Migration),这些工具支持大批量数据的快速迁移。

3、离线迁移:对于数据量巨大或者网络条件不佳的情况,可以选择使用物理介质进行离线迁移。

执行迁移

按照制定的计划开始执行数据迁移,过程中要监控迁移进度和性能指标,确保迁移顺利进行。

验证和测试

迁移完成后,需要对数据进行完整性校验,并进行必要的功能测试,确保数据在云端的可用性。

数据安全与保障

加密传输

在数据迁移的过程中,应确保数据在传输过程中的安全,使用SSL/TLS等加密协议可以保证数据在传输过程中不被窃取或改动。

权限管理

合理设置云存储服务的访问权限,避免未授权的访问和操作,通过身份认证和访问控制列表(ACL)等手段加强数据安全管理。

定期备份

即使在云端,也需要定期对数据进行备份,防止意外情况导致数据丢失,多数云服务商提供自动、定时备份的功能。

监控和审计

启用监控服务记录数据的操作日志,及时发现和处理异常行为,进行定期的安全审计,评估数据安全状况。

相关问题与解答

Q1: 迁移到云端后,如何确保我的数据的隐私性和安全性?

A1: 确保数据隐私性和安全性的措施包括使用端到端加密技术,配置严格的访问控制策略,以及定期进行安全审计和破绽扫描。

Q2: 如果迁移过程中出现网络中断怎么办?

A2: 在迁移之前制定应急计划,比如使用离线迁移作为备选方案,或者利用云服务商提供的断点续传功能来恢复迁移过程。

Q3: 迁移到云端是否会对我的应用程序性能产生影响?

A3: 合理的迁移规划和优化可以最小化影响,确保应用程序和云服务之间的兼容性和高效连接,必要时进行代码调整以适应云端环境。

Q4: 是否可以将数据从云服务器迁移回本地硬盘?

A4: 可以,但需要考虑数据的格式和兼容性,同样需要确保数据在迁移过程中的安全,并可能需要重新配置应用程序以适应本地环境。