如何优化大理网站设计的API接口以提高用户体验?

- 行业动态

- 2024-08-03

- 6

大理网站设计_API设计

1. API设计

API(Application Programming Interface,应用程序编程接口)是一组预定义的函数或方法,允许开发者调用以实现特定的功能,在大理网站设计中,API设计是核心环节之一,它关系到网站的功能性、扩展性以及与其他系统的集成能力,一个良好的API设计可以极大地提升网站的用户体验和开发效率。

2. API设计原则

在设计API时,需要遵循一些基本原则来确保其可用性、稳定性和安全性:

简洁性:API应该简单易用,避免不必要的复杂性。

一致性:API的设计应当保持一致,使得使用者能够快速理解和使用。

可扩展性:考虑到未来可能的需求变化,API应设计得易于扩展。

版本控制:通过合理的版本管理,确保API升级不会影响到现有用户。

文档齐全:提供详细的API文档和使用示例。

安全性:确保API的安全性,防止未授权访问和数据泄露。

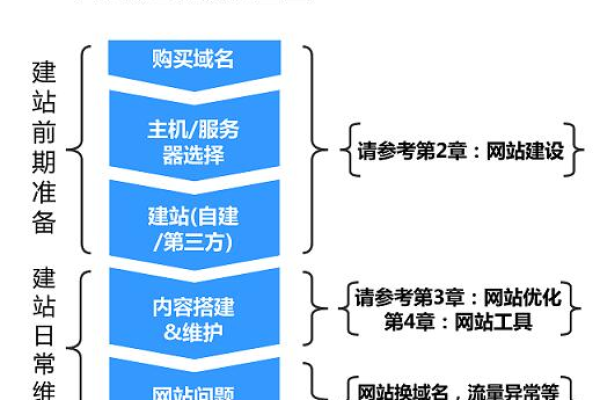

3. API设计流程

API的设计流程通常包括以下几个步骤:

需求分析:确定API需要实现的功能和服务。

设计规范:制定API的设计规范,包括命名规则、参数格式等。

编写API:根据设计规范进行API的编码工作。

测试验证:对API进行充分的测试,确保其稳定性和可靠性。

文档编写:撰写清晰的API文档,供开发者参考。

部署上线:将API部署到生产环境,并确保其稳定运行。

维护更新:根据用户反馈和系统升级进行API的维护和更新。

4. API设计细节

在API设计的细节方面,需要考虑以下几个方面:

RESTful API:采用REST架构风格来设计API,利用HTTP协议实现资源的CRUD操作。

认证机制:实现OAuth、API密钥等认证机制,保障API的安全访问。

错误处理:设计统一的错误代码和错误信息,方便开发者定位问题。

限流策略:设置合理的请求限制,防止服务被滥用。

缓存机制:合理使用缓存,提高API的响应速度和性能。

5. API与前端交互

API与前端的交互是网站设计中的关键环节,涉及到数据的展示和用户的操作响应,以下是几个重要的交互方面:

数据格式:通常使用JSON或XML作为数据交换格式。

异步通信:采用AJAX、WebSocket等技术实现前后端的异步数据交换。

用户体验:优化API响应时间,减少用户等待,提升用户体验。

跨域访问:处理跨域资源共享(CORS),确保不同域之间的API调用安全有效。

6. API监控与优化

为了保证API的稳定运行和高性能,需要进行持续的监控和优化:

性能监控:实时监控API的响应时间和吞吐量。

日志记录:记录API的访问日志,便于问题追踪和分析。

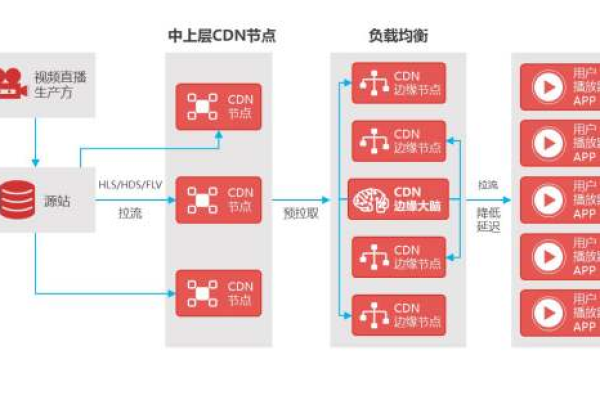

负载均衡:通过负载均衡技术分配请求,提高系统的处理能力。

自动化测试:建立自动化测试机制,确保API的质量。

7. 案例分析

假设我们正在为一家在线旅游平台设计API,该平台需要提供以下功能:

用户管理:注册、登录、资料编辑等。

旅游产品浏览:查看各类旅游产品信息。

订单管理:创建订单、支付、查看订单状态等。

客户支持:提交咨询、查看常见问题等。

针对这些功能,我们可以设计如下API端点:

/api/users:处理用户相关的操作。

/api/products:提供产品信息的查询和浏览。

/api/orders:处理订单的创建和管理。

/api/support:提供客户支持相关服务。

每个端点下会有具体的子路径和方法,

POST /api/users/register:用户注册。

GET /api/products:获取产品列表。

POST /api/orders:创建新订单。

POST /api/support/tickets:提交客户咨询。

8. 相关问答FAQs

Q1: API设计中如何处理版本控制?

A1: 可以通过URL路径或请求头信息来实现API的版本控制,将版本号嵌入URL中(如/api/v1/users),或者在请求头中指定版本信息,这样,当API更新时,可以并行运行多个版本,逐渐过渡用户至最新版本。

Q2: API设计中如何保证数据的安全性?

A2: 可以使用HTTPS协议来加密数据传输过程,防止数据被截获,对于敏感操作,需要身份验证和授权,比如使用OAuth 2.0框架,还应实施输入验证和输出编码,以防止注入攻击和跨站脚本攻击(XSS),对于数据存储和处理,要遵循最小权限原则和数据加密最佳实践。