RDS for MySQL是否支持修改数据库名称?

- 行业动态

- 2024-09-18

- 2910

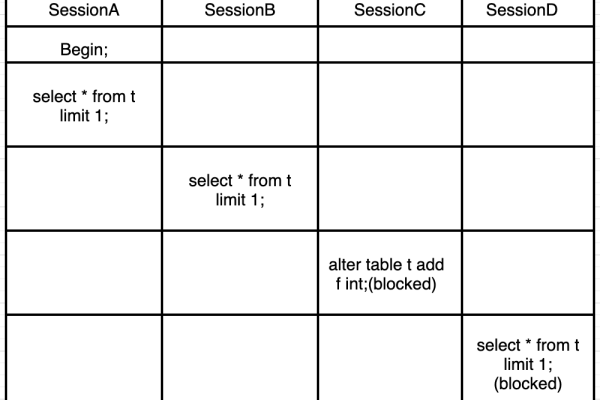

在讨论如何修改MySQL数据库名称之前,了解其操作方法和相关工具的使用是非常重要的,下面将深入探讨RDS for MySQL环境下数据库名称的修改方法及其可行性,并针对相关操作提供详细指南:

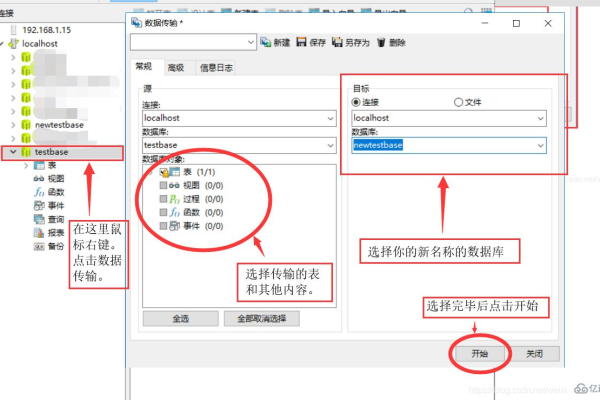

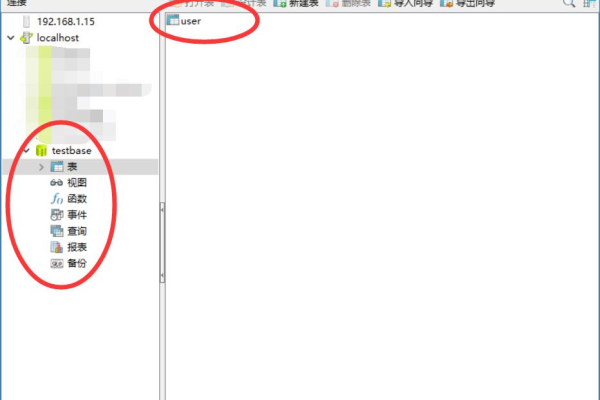

1、使用管理工具修改

登录与选择数据库:先需要使用诸如phpMyAdmin或MySQL Workbench等数据库管理工具登录到您的服务器,成功登录后,选择您希望修改名称的数据库。

重命名操作:在管理工具的界面中,找到“操作”或“管理”选项,并点击“重命名”或“修改名称”,此时会弹出一个对话框,您可以在其中输入新的数据库名称来完成修改。

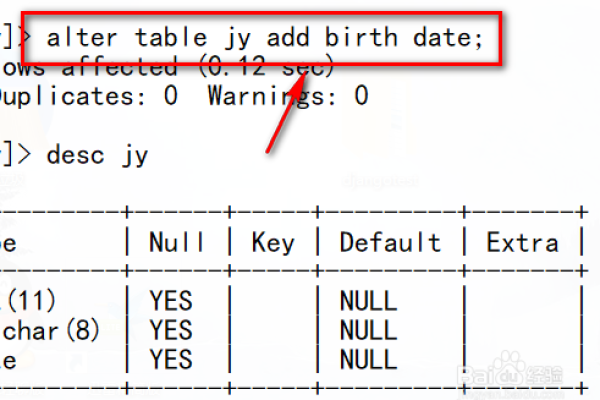

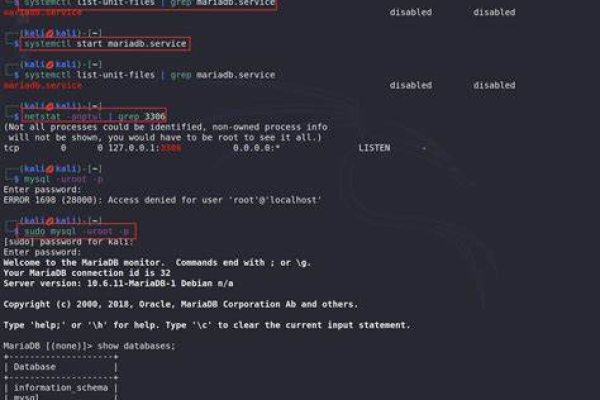

2、通过命令行操作

创建新数据库:在命令行中,您可以先创建一个新的数据库,命令如下:create database new_db;,这样准备好一个空的数据库用于后续步骤。

数据迁移:使用mysqldump导出原数据库的数据:mysqldump uroot p123456 setgtidpurged=OFF old_db > /tmp/old_db.sql,将导出的数据导入到新数据库中:mysql uroot p123456 new_db < /tmp/old_db.sql,此方法尤其适用于数据量不大的情况。

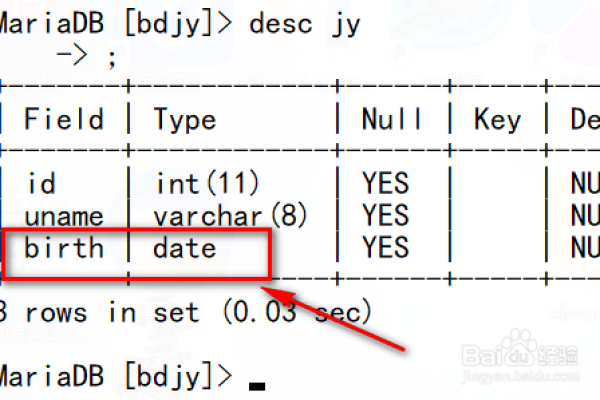

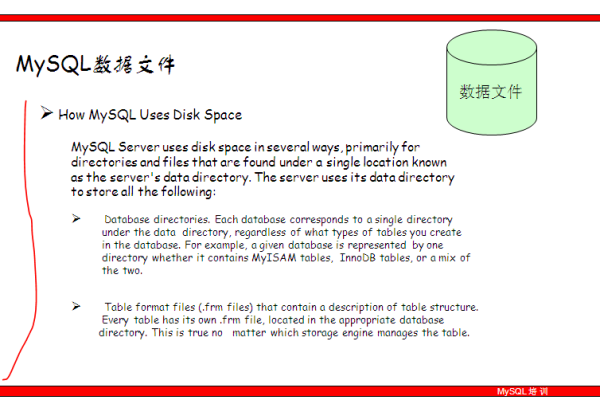

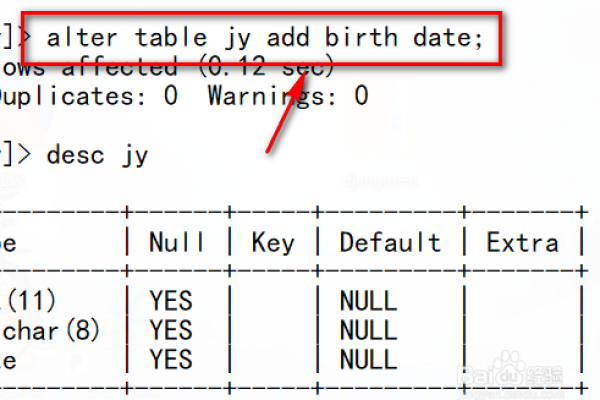

3、直接修改数据库目录

MyISAM引擎下的数据库:对于使用MyISAM存储引擎的数据库,可以直接通过更改数据库目录下的文件来修改数据库名称,这种方法快速但风险较高,一般不推荐给普通用户操作。

4、RDS for MySQL的特点

参数配置修改:RDS for MySQL允许通过控制台和API修改数据库参数配置,这包括一些可以个性化调整的实例参数,并非所有参数都可以自由修改,部分只读参数无法被更改。

重启与同步问题:在RDS环境中,修改某些参数后需要重启数据库实例才能使设置生效,主实例上的参数修改会自动同步到所有只读副本中,这对于保持数据一致性非常关键。

为了确保操作的顺利和安全,可以考虑以下几个因素:

确保在业务低峰时段进行操作,以减少对业务的影响。

应用程序应具备自动重连机制,以应对可能的连接中断。

在进行任何操作前做好数据备份,以防数据丢失。

修改RDS for MySQL中的数据库名称是一个多步骤的过程,涉及使用数据库管理工具、命令行操作、直接目录修改等多种方法,每种方法都有其适用场景和限制,用户需要根据自己的具体需求和环境谨慎选择,考虑到RDS环境的特殊性,操作时还需要注意参数配置的修改规则及实例的重启和同步问题。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/23286.html