如何解决MySQL数据库中文显示问题以及HiLens Kit无法显示中文的困扰?

- 行业动态

- 2024-10-07

- 4523

MySQL数据库显示中文问题及HiLens Kit显示中文问题解决方案

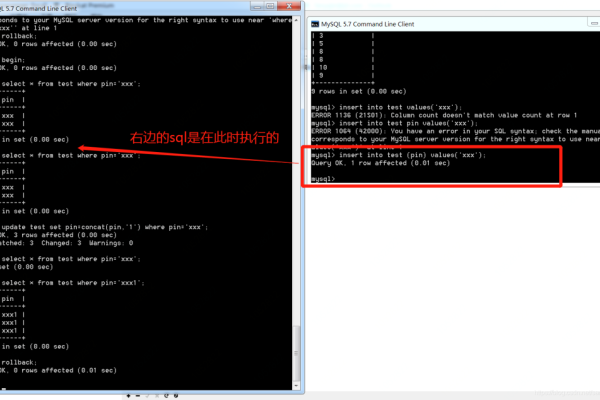

1. MySQL数据库显示中文问题

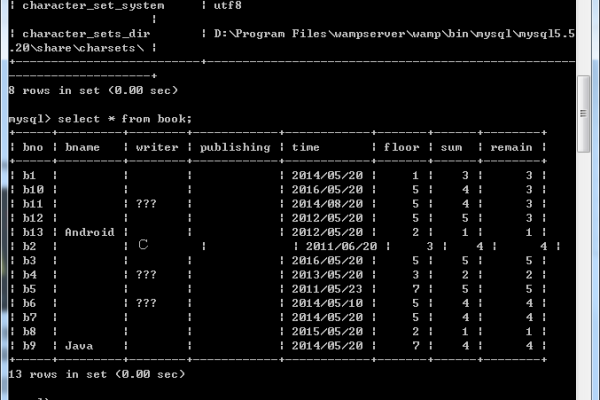

问题现象:在MySQL数据库中存储或显示中文时,出现乱码或无法显示中文。

解决步骤:

1、确保字符集设置正确:

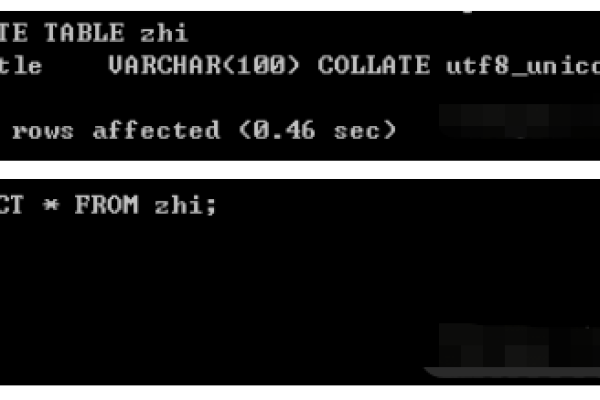

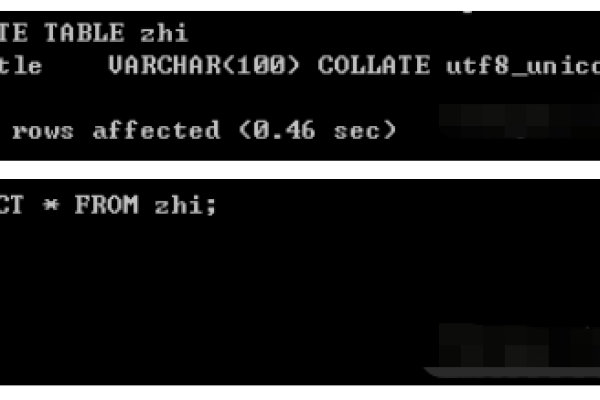

在创建数据库或表时,指定字符集为utf8或utf8mb4。

创建数据库时使用:

“`sql

CREATE DATABASE mydb CHARACTER SET utf8mb4 COLLATE utf8mb4_unicode_ci;

“`

或者,修改现有数据库的字符集:

“`sql

ALTER DATABASE mydb CHARACTER SET utf8mb4 COLLATE utf8mb4_unicode_ci;

“`

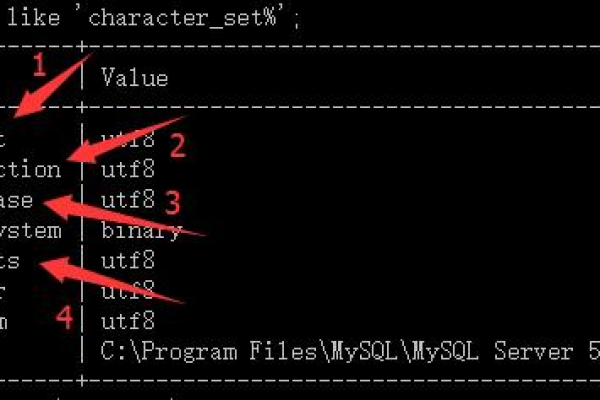

2、修改MySQL配置文件:

打开MySQL的配置文件(通常是my.cnf或my.ini),通常位于/etc/mysql/或/usr/local/mysql/目录下。

在配置文件中设置以下参数:

“`ini

[mysqld]

charactersetserver=utf8mb4

collationserver=utf8mb4_unicode_ci

“`

保存并重新启动MySQL服务。

3、确保客户端连接设置正确:

在连接MySQL服务器时,确保客户端连接字符集也是utf8mb4。

在MySQL命令行工具中连接时,使用:

“`sh

mysql u username p defaultcharacterset=utf8mb4

“`

2. HiLens Kit显示中文问题

问题现象:HiLens Kit无法显示中文。

解决步骤:

1、检查系统语言设置:

确保HiLens Kit的系统语言设置为支持中文显示的语言。

2、检查字体支持:

HiLens Kit可能需要特定的字体来正确显示中文。

确保系统中安装了支持中文的字体,如SimHei或Microsoft YaHei。

3、检查应用程序设置:

如果是应用程序显示中文问题,检查应用程序的字符集设置是否正确。

确保应用程序在显示中文前设置了正确的字符集。

4、更新系统:

确保HiLens Kit的系统是最新版本,可能存在系统更新修复了中文显示的问题。

通过以上步骤,您应该能够解决MySQL数据库和HiLens Kit显示中文的问题。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/22958.html