香港vps云服务器搭建博客有哪些优势

- 行业动态

- 2023-11-18

- 7

香港VPS云服务器搭建博客的优势

在当今这个信息化的时代,越来越多的人选择通过互联网来表达自己的观点和分享生活,而博客作为一种常见的个人网站形式,已经成为了许多人展示自己的平台,搭建博客的方式有很多,其中香港VPS云服务器是一种非常受欢迎的选择,使用香港VPS云服务器搭建博客有哪些优势呢?本文将从以下几个方面进行阐述:

1. 访问速度快

香港作为亚洲的互联网枢纽,拥有世界上最发达的网络基础设施,香港VPS云服务器的访问速度相对于其他地区的服务器来说更快,这意味着用户可以在短时间内加载你的博客页面,提高用户体验,对于访问量大的博客来说,这将是一个非常重要的优势。

2. 稳定性高

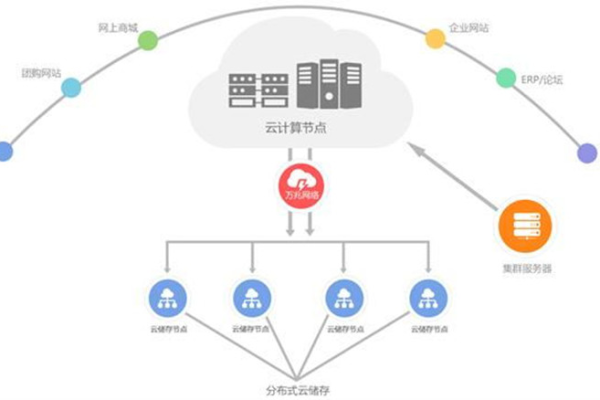

云服务器的稳定性是衡量一个产品优劣的重要标准,香港VPS云服务器采用了先进的技术和设备,确保了服务器的稳定运行,云服务提供商通常会提供多重备份和故障转移功能,以确保在出现故障时能够及时恢复服务,避免数据丢失或影响用户体验。

3. 安全性高

网络安全问题日益严重,对于个人博客来说尤为重要,香港VPS云服务器提供了多种安全措施,如防火墙、DDoS防护等,有效防止反面攻击和数据泄露,云服务提供商还会定期对服务器进行安全检查和更新,确保用户的数据安全。

4. 弹性扩展

随着博客的发展,用户可能会遇到访问量激增的情况,传统的服务器可能会因为资源不足而无法应对,而香港VPS云服务器具有弹性扩展的功能,可以根据实际需求快速增加或减少资源,满足不同阶段的需求,这对于快速发展的博客来说是非常有利的。

5. 成本效益高

相较于购买和维护传统服务器的成本,香港VPS云服务器具有更高的性价比,云服务提供商通常会提供按需付费的模式,用户只需支付实际使用的资源费用,无需承担额外的硬件和运维成本,云服务器还可以实现资源的共享和复用,进一步降低成本。

使用香港VPS云服务器搭建博客具有访问速度快、稳定性高、安全性高和成本效益高等优势,选择云服务器还需要根据自己的实际需求和预算来进行权衡。

相关问题与解答:

1. 问:香港VPS云服务器搭建博客的费用如何?

答:香港VPS云服务器的费用因服务提供商和配置的不同而有所差异,按需付费的模式可以让用户按照实际使用的资源进行付费,具有更高的灵活性和性价比,建议您根据自己的需求选择合适的服务提供商和套餐。

2. 问:使用香港VPS云服务器搭建博客是否需要具备一定的技术知识?

答:搭建博客本身并不需要太多的技术知识,但在使用过程中可能需要进行一些基本的配置和管理,如果您有一定的技术基础,可以自行完成这些操作;如果没有,可以选择使用一些简单易用的博客平台,如WordPress等,这些平台通常提供了丰富的插件和模板,可以帮助您快速搭建博客。

3. 问:使用香港VPS云服务器搭建博客是否会影响其他用户的访问速度?

答:正常情况下,使用香港VPS云服务器搭建博客不会对其他用户的访问速度造成影响,因为香港VPS云服务器的带宽资源充足,且具有良好的隔离性,但在某些特殊情况下,如多个用户共享同一台物理服务器的资源时,可能会出现一定程度的影响,在选择云服务提供商时,请务必关注其提供的服务质量和技术支持。

4. 问:使用香港VPS云服务器搭建博客是否会受到地域限制?

答:香港VPS云服务器不受地域限制,您可以在全球范围内进行访问,这意味着您可以将博客推广到全球各地,吸引更多的读者和潜在客户,在进行国际访问时,可能会受到一些网络环境和政策的影响,建议在搭建博客时充分考虑这些因素。