c# 多层神经网络

- 行业动态

- 2025-03-19

- 8

在C#中实现多层神经网络涉及到多个关键步骤,包括数据准备、模型构建、训练和评估等,以下是详细的实现过程:

1、数据准备

数据收集:从各种来源(如文件、数据库或网络)收集数据,确保数据质量和相关性,对缺失值和异常值进行处理。

数据预处理:将数据标准化或归一化,使其适合神经网络的输入,常见的方法包括最小-最大缩放和Z-score标准化。

标签编码:如果任务是分类问题,需要将标签转换为数值形式,使用One-Hot编码处理类别变量。

数据集划分:将数据集分为训练集、验证集和测试集,训练集占70-80%,验证集占10-15%,测试集占10-15%。

2、模型构建

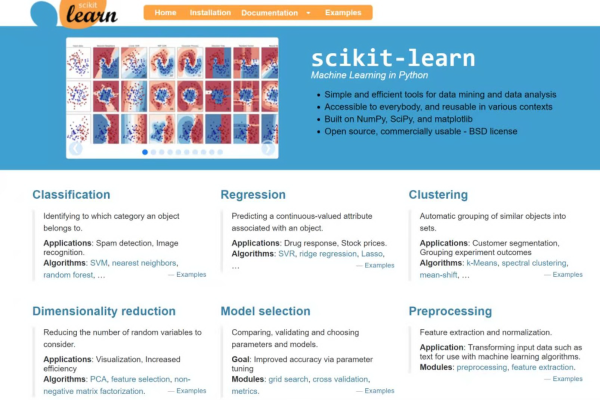

选择框架:虽然C#不是深度学习的主流语言,但可以使用一些库来简化神经网络的实现,如NumSharp(用于数值计算)和Accord.NET(机器学习库)。

定义网络结构:

输入层:节点数等于输入特征的数量。

隐藏层:可以有一层或多层,每层的节点数可以根据具体问题调整,激活函数常用ReLU(Rectified Linear Unit)。

输出层:节点数等于输出类别的数量(分类问题)或1(回归问题),对于二分类问题,输出层可以使用Sigmoid激活函数;对于多分类问题,使用Softmax激活函数。

配置参数:设置学习率、批次大小、迭代次数等超参数,学习率控制权重更新的步长,批次大小决定每次更新使用的样本数,迭代次数影响训练时间。

3、训练模型

前向传播:输入数据通过各层传递,计算输出,每层的输出作为下一层的输入。

计算损失:根据预测结果和真实标签计算损失函数的值,常用的损失函数有均方误差(MSE)和交叉熵损失。

反向传播:根据链式法则计算梯度,并更新权重和偏置,优化算法如随机梯度下降(SGD)、Adam等可用于加速收敛。

迭代训练:重复前向传播和反向传播的过程,直到达到预定的迭代次数或损失函数收敛。

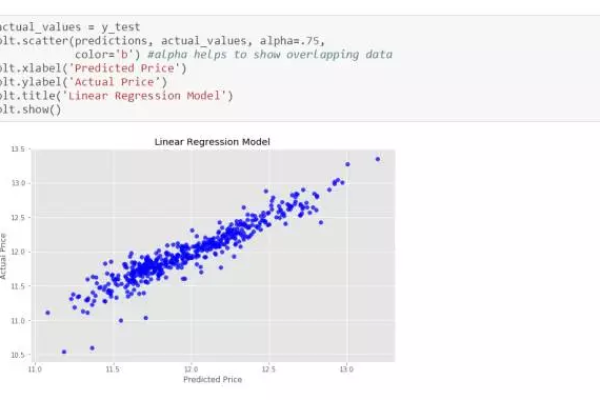

4、模型评估

准确性:正确预测的比例,适用于分类问题。

精确率、召回率和F1分数:更细致地评估分类性能,特别是在类别不平衡的情况下。

均方误差(MSE):衡量回归问题的预测误差。

5、模型部署

保存模型:将训练好的模型参数保存到文件中,以便后续加载和使用。

集成应用:将模型集成到实际应用中,如构建桌面应用或Web服务。

以下是一个简单的示例代码,展示如何使用C#和Accord.NET库构建一个基本的多层神经网络:

using System;

using Accord.MachineLearning;

using Accord.Math;

class Program

{

static void Main()

{

// 生成一些示例数据

double[][] inputs = {

new double[] { 0, 0 },

new double[] { 0, 1 },

new double[] { 1, 0 },

new double[] { 1, 1 }

};

int[] outputs = { 0, 1, 1, 0 }; // XOR问题的输出

// 创建多层感知器

var mlp = new MultilayerPerceptron(inputs[0].Length, 2, outputs.Length);

// 训练模型

mlp.Learn(inputs, outputs);

// 进行预测

var predicted = mlp.Compute(new double[] { 1, 0 });

Console.WriteLine("Predicted: " + predicted);

}

}

上述代码展示了如何使用Accord.NET库构建一个简单的多层感知器来解决XOR问题,在实际应用中,你可能需要更复杂的网络结构和更多的数据预处理步骤。

相关问答FAQs

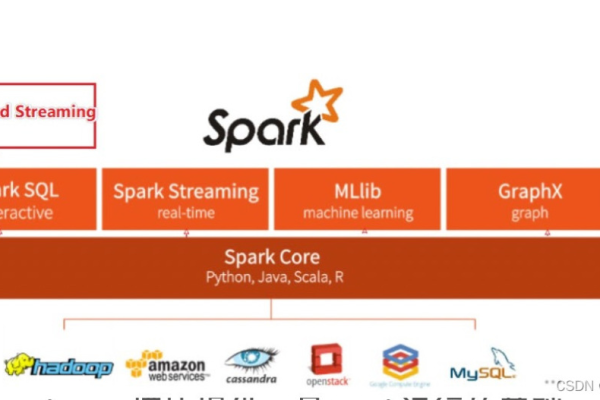

Q1: 如何在C#中处理大数据集以提高神经网络的训练效率?

A1: 在C#中处理大数据集时,可以考虑以下几种方法来提高训练效率:

数据分批处理:将数据集分为小批次进行训练,避免内存不足的问题。

使用并行计算:利用多核处理器或GPU加速矩阵运算,虽然C#本身不直接支持GPU编程,但可以通过调用支持GPU的库(如CUDA.NET)来实现。

优化数据结构:使用高效的数据结构存储和访问数据,减少不必要的内存开销。

Q2: 如何选择合适的激活函数和损失函数?

A2: 选择合适的激活函数和损失函数取决于具体的任务和数据特性:

激活函数:

ReLU(Rectified Linear Unit):常用于隐藏层,能够引入非线性因素,同时缓解梯度消失问题。

Sigmoid:适用于二分类问题的输出层,将输出映射到(0, 1)区间。

Softmax:适用于多分类问题的输出层,将输出转换为概率分布。

损失函数:

均方误差(MSE):适用于回归问题,衡量预测值与真实值之间的平均平方差。

交叉熵损失:适用于分类问题,特别是当输出是概率分布时,衡量预测概率分布与真实分布之间的差异。