安全服务云_服务安全

- 行业动态

- 2024-06-05

- 7

服务安全概览

在数字化时代,随着云计算技术的飞速发展,企业和个人越来越依赖云服务进行数据存储、处理和交换,这也引入了新的安全挑战,服务安全(Service Security)成为保护云服务免受反面攻击和数据泄露的关键组成部分,本篇文章将全面探讨服务安全的各个方面,确保读者能够理解并实施有效的安全措施。

云服务安全的重要性

云服务安全对于维护数据的完整性、可用性和保密性至关重要,无论是个人还是企业用户,都必须确保他们的数据在云中是安全的,以防止数据丢失、改动或未经授权的访问。

安全策略和框架

为了确保服务安全,采用合适的安全策略和框架是基础,这包括了解并遵循国际安全标准如ISO/IEC 27001,以及应用行业最佳实践,如CIS(Center for Internet Security)控制措施。

身份和访问管理(IAM)

有效的IAM策略是确保只有授权用户才能访问敏感资源的关键,这包括使用强密码政策、多因素认证和定期审计权限。

数据加密

数据在传输和静态时都应该被加密,以保护数据不被未授权访问,使用现代加密技术,如TLS(传输层安全性协议)和AES(高级加密标准),可以有效保护数据。

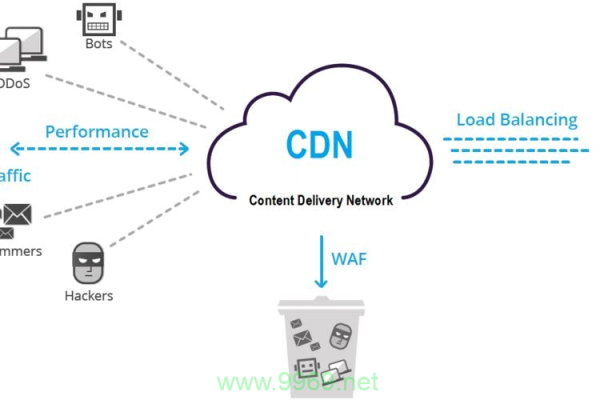

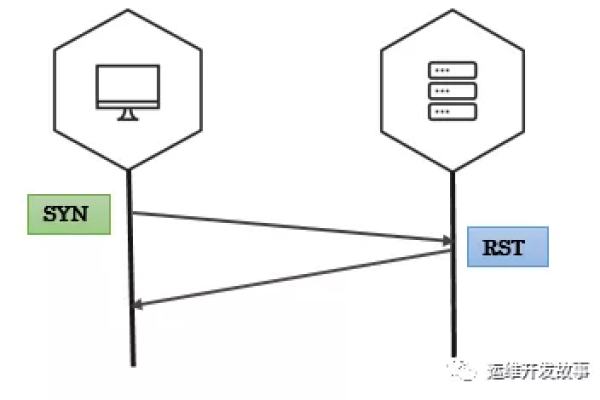

网络安全

网络安全措施,包括防火墙、载入检测系统(IDS)和载入防御系统(IPS),是保护云服务不受网络攻击的重要组成部分。

应用程序安全

确保应用程序的安全性,通过定期的安全测试和代码审查来发现和修复潜在的安全破绽。

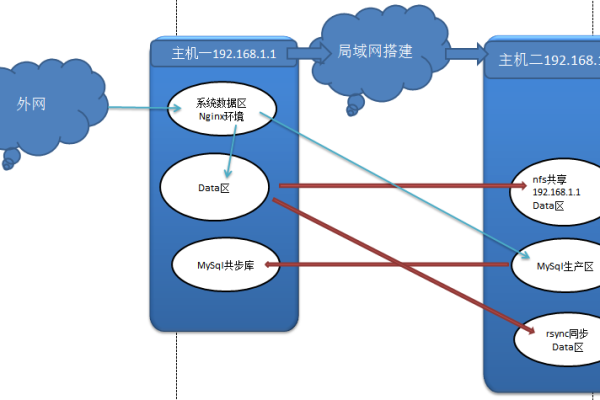

灾难恢复和业务连续性计划

制定和实施灾难恢复计划和业务连续性策略,以确保在发生安全事件或其他中断时,服务能够迅速恢复。

合规性和监管要求

遵守相关的法律和行业标准,如GDPR(通用数据保护条例)和HIPAA(健康保险便携与问责法案),对于保护客户数据和维护企业声誉至关重要。

安全监控和事件响应

实施持续的安全监控和事件响应机制,以便快速检测和应对安全威胁。

员工培训和意识提高

对员工进行安全意识和最佳实践的培训,是减少人为错误和内部威胁的有效方法。

服务安全的未来趋势

随着技术的发展,服务安全领域也在不断进步,关注最新的安全技术和趋势,如人工智能(AI)在安全分析中的应用,以及量子计算对加密技术的潜在影响,对于保持服务安全至关重要。

相关问答FAQs

Q1: 如何选择合适的云服务提供商?

A1: 选择云服务提供商时,应考虑其安全认证、合规性记录、客户评价、提供的安全保障措施以及价格,确保服务提供商遵循行业标准,并提供必要的支持和服务级别协议(SLAs)。

Q2: 如果遇到数据泄露应该怎么办?

A2: 如果发生数据泄露,首先应立即通知受影响的用户,并按照法律要求报告给相关监管机构,应启动应急响应计划,调查泄露原因,采取必要措施防止进一步的数据损失,并加强未来的安全防护措施。

通过上述措施,可以有效地提升云服务的安全性,保护企业和用户的利益,随着技术的发展,持续更新和改进安全策略是确保服务安全的关键。