Flinkcdc单表同步,checkpoint一会儿大一会儿小这个正常?什么原理?

- 行业动态

- 2024-05-03

- 1

在使用Flink CDC(Change Data Capture,变化数据捕获)进行单表同步时,可能会遇到checkpoint文件大小波动的情况,这种现象在一定程度上是正常的,因为checkpoint的大小受到多个因素的影响,下面我们将详细分析这些因素以及它们如何影响checkpoint的大小。

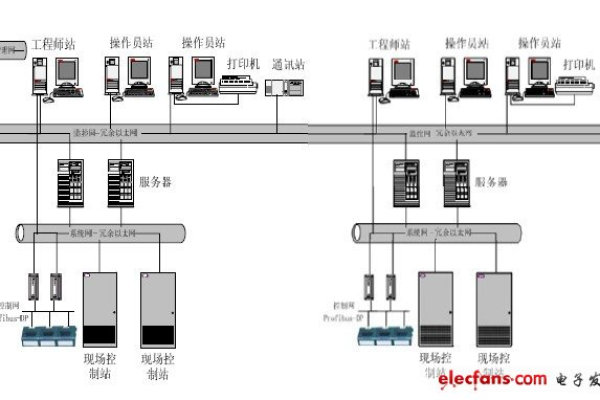

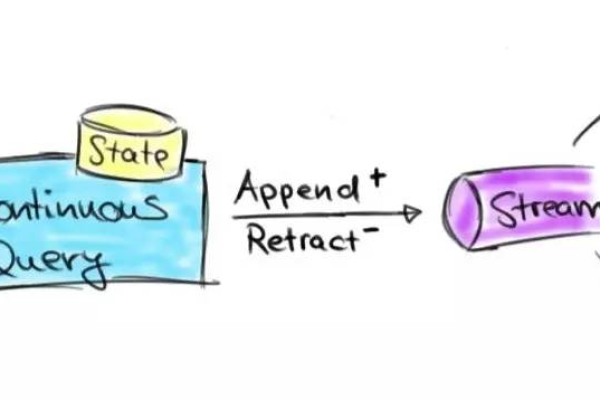

1. Checkpoint的工作原理

在Flink中,checkpoint是一种容错机制,用于保存应用程序的状态和数据,以便在发生故障时可以从最近的一个checkpoint恢复,Flink CDC通过捕获源数据库中的变更事件来实现数据的同步,这些变更事件会被序列化并存储在checkpoint中。

2. Checkpoint大小的影响因素

2.1 数据变更量

数据变更量是影响checkpoint大小的主要因素,当源表中的数据发生大量更新、删除或插入操作时,checkpoint需要记录更多的变更事件,从而导致其大小增加,相反,如果数据变更较少,checkpoint的大小也会相应减小。

2.2 Checkpoint间隔时间

Checkpoint的间隔时间也会影响其大小,较短的间隔时间意味着更频繁地进行checkpoint,每次checkpoint需要处理的变更事件较少,因此checkpoint的大小较小,而较长的间隔时间会导致每次checkpoint处理更多的变更事件,从而使其大小增加。

2.3 并行度

Flink任务的并行度也会影响checkpoint的大小,较高的并行度意味着更多的任务实例同时运行,每个实例都需要存储自己的状态和数据,较高的并行度可能导致较大的checkpoint。

2.4 序列化方式

Flink支持多种序列化方式,不同的序列化方式对checkpoint大小的影响也不同,使用Kryo序列化通常会产生较小的checkpoint,而使用Java序列化则可能导致较大的checkpoint。

3. Checkpoint大小波动的原因

根据以上分析,我们可以得出上文归纳:checkpoint大小波动是由于数据变更量、checkpoint间隔时间、并行度和序列化方式等多个因素共同作用的结果,在实际运行过程中,这些因素可能不断变化,导致checkpoint大小出现波动。

4. 优化建议

为了减小checkpoint大小的波动,可以尝试以下方法:

调整checkpoint间隔时间,以平衡checkpoint大小和恢复速度。

根据实际需求选择合适的并行度,避免过高的并行度导致的checkpoint过大。

选择合适的序列化方式,以减小checkpoint大小。

相关问答FAQs

问题1:为什么有时候checkpoint大小会突然增大?

答:这可能是由于某个时间段内数据变更量较大,或者并行度较高导致的,可以通过调整checkpoint间隔时间、并行度或序列化方式来优化。

问题2:如何选择合适的checkpoint间隔时间?

答:合适的checkpoint间隔时间需要根据实际需求和系统资源来权衡,较短的间隔时间可以加快恢复速度,但会增加系统的开销;较长的间隔时间可以减小系统开销,但恢复速度较慢,建议根据实际情况进行测试和调整。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:http://www.xixizhuji.com/fuzhu/206303.html