ajax 提交表单数据失败

- 行业动态

- 2025-03-19

- 11

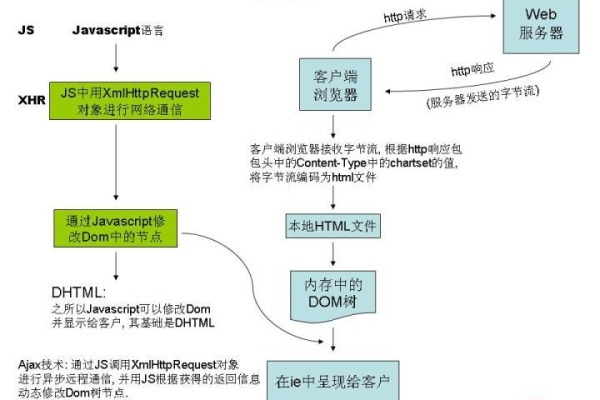

AJAX 提交表单数据失败可能原因有:网络问题、服务器端代码错误、客户端代码错误、跨域问题等。

Ajax 提交表单数据失败

一、常见原因及解决方法

(一)前端代码问题

| 问题描述 | 可能原因 | 解决方法 |

| 未正确获取表单数据 | 使用serialize()方法时,表单元素的name属性缺失或错误;或者手动获取数据时,选择器错误。 |

检查表单元素name属性是否正确设置,确保与后台接收的参数名一致;仔细检查选择器是否正确,可使用浏览器开发者工具调试。 |

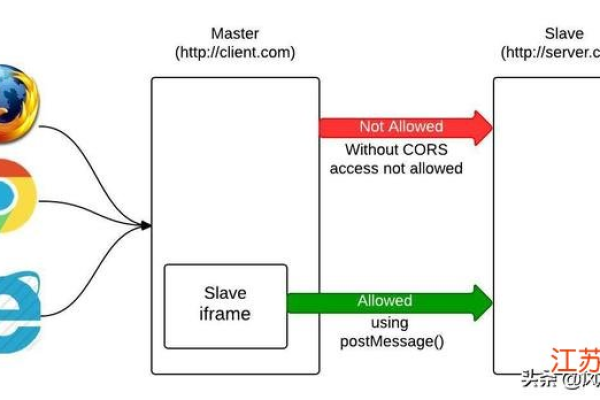

| 跨域问题 | 浏览器同源策略限制,导致Ajax请求无法发送到不同源的服务器。 | 在后端设置允许跨域的响应头,如在PHP中可以使用header('Access-Control-Allow-Origin: ');(生产环境不建议使用 |

| 请求方法错误 | 前端设置的请求方法与后端期望的方法不一致,例如前端设置为GET方法,而后端期望POST方法。 |

根据后端要求,在Ajax代码中正确设置请求方法,如type: 'POST'。 |

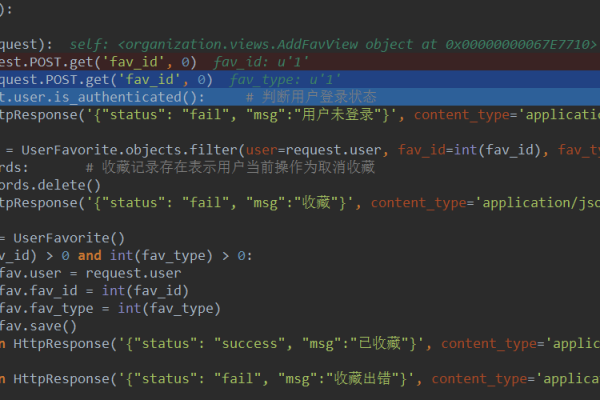

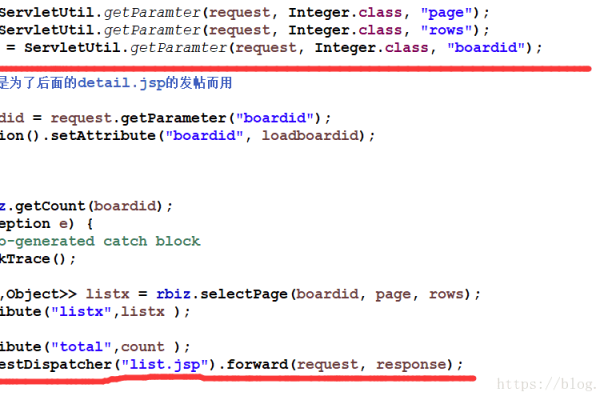

(二)后端代码问题

| 问题描述 | 可能原因 | 解决方法 |

| 后端接口未正确接收数据 | 后端编程语言中获取请求数据的代码错误,例如在PHP中没有正确使用$_POST或$_GET获取数据;或者接收数据的变量名与前端发送的数据不匹配。 |

检查后端代码中获取数据的语法是否正确,确保变量名与前端一致;对于复杂数据类型,可能需要进行数据解析和转换。 |

| 后端逻辑错误导致处理失败 | 后端业务逻辑存在问题,例如数据库连接错误、数据验证不通过等。 | 检查后端的业务逻辑代码,查看日志文件以确定具体的错误原因,修复相应的逻辑错误;确保数据库连接正常,检查数据库配置信息是否正确。 |

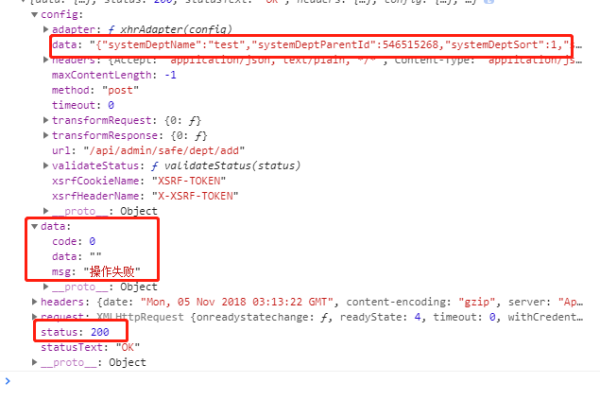

| 返回数据格式不符合预期 | 后端返回的数据格式不是前端期望的格式,例如前端期望JSON格式,但后端返回了普通文本或其他格式。 | 在后端根据前端要求设置正确的返回数据格式,如在PHP中使用echo json_encode($data);将数据转换为JSON格式返回;同时确保前端对返回数据的处理方式与数据格式相匹配。 |

(三)网络问题

| 问题描述 | 可能原因 | 解决方法 |

| 网络延迟或中断 | 网络不稳定、服务器繁忙等原因导致Ajax请求超时或数据传输不完整。 | 优化网络环境,检查服务器性能和带宽是否充足;可以在前端设置适当的超时时间,避免长时间等待;对于重要的数据提交,可以考虑添加重试机制。 |

| 防火墙或安全软件拦截 | 服务器或客户端的防火墙、安全软件设置过于严格,阻止了Ajax请求的正常通信。 | 检查服务器和客户端的安全策略,确保允许Ajax请求通过;如果是在公司内部网络,可能需要联系网络管理员调整相关设置。 |

二、相关问题与解答

(一)问题

Ajax提交表单数据时,如何判断是前端还是后端出现问题?

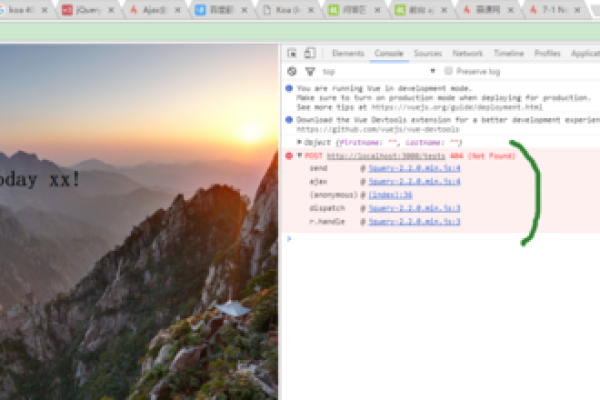

解答:首先查看浏览器开发者工具中的控制台,如果有报错信息,通常是前端代码问题,如语法错误、选择器错误等,然后查看网络请求的状态码和响应内容,如果状态码为200,但返回的数据不符合预期,可能是后端逻辑问题;如果状态码不是200,如404(未找到资源)、500(服务器内部错误)等,则可能是后端接口地址错误或服务器端出现问题,还可以通过在前端和后端分别添加日志记录,输出关键信息,以便更准确地定位问题所在。

(二)问题

如何解决Ajax跨域问题?

解答:一种方法是在后端设置允许跨域的响应头,如在Java的Spring Boot项目中,可以在控制器方法上使用@CrossOrigin注解来允许跨域访问,另一种方法是通过代理服务器来解决,例如在开发环境中,可以配置一个本地的代理服务器,将跨域请求转发到目标服务器,从而绕过浏览器的同源策略限制,不过需要注意的是,在实际生产环境中,需要谨慎处理跨域问题,以确保系统的安全性。