非大陆代理服务器,它们是如何工作的?

- 行业动态

- 2024-07-22

- 11

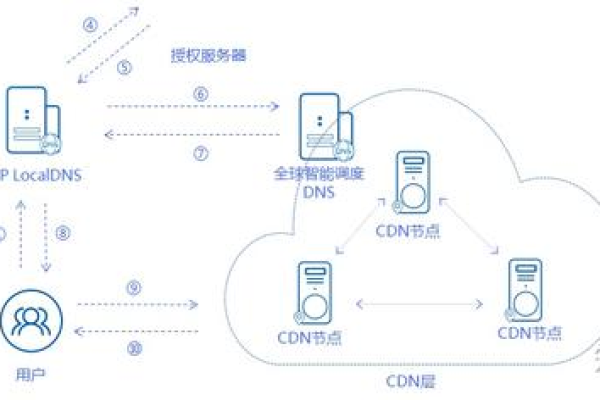

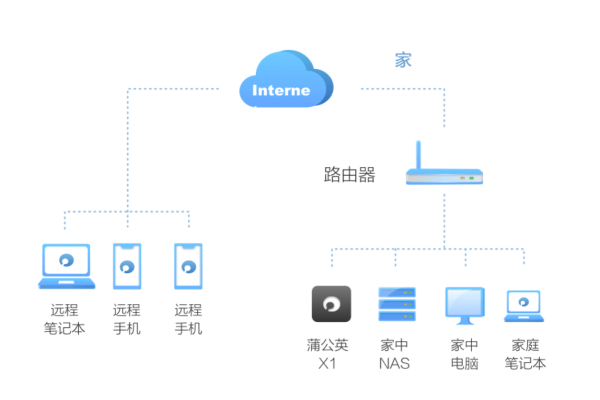

非大陆代理服务器是指位于中国大陆以外的 代理服务器,用于绕过地理限制、提高匿名性和安全性。这种服务器通常部署在其他国家或地区,以帮助用户访问受限制的网站或服务,同时隐藏他们的真实IP地址。

非大陆代理服务器是指不在中国大陆地区运营的代理服务器,它们可能位于其他地区或国家,这些服务器可以用于访问被限制的网站或服务,但使用时应遵守法律法规和道德规范,用户在选择时需考虑安全性、稳定性等因素,并注意保护个人隐私,相关问答包括:什么是非大陆代理服务器?使用非大陆代理服务器有哪些注意事项?请确保合法合规使用,避免违法行为。