ai模型部署

- 行业动态

- 2025-03-17

- 5

AI模型部署是将训练好的人工智能模型应用到实际环境中的过程,涉及模型转换、环境配置、性能优化等步骤,以确保模型能高效稳定运行并发挥作用。

AI 模型部署

一、部署前准备

| 准备工作 | 详情 |

| 数据准备 | 确保有高质量的数据集,用于训练和测试模型,数据应经过清洗、标注等预处理步骤,以提高模型的准确性和泛化能力,在图像识别任务中,需要对图像进行裁剪、归一化等操作;在自然语言处理任务中,可能需要对文本进行分词、去除停用词等处理。 |

| 模型选择 | 根据具体的应用场景和需求选择合适的 AI 模型,不同的模型适用于不同类型的任务,如卷积神经网络(CNN)适用于图像分类、目标检测等任务;循环神经网络(RNN)及其变体(如 LSTM、GRU)适用于序列数据处理,如文本生成、语音识别等;支持向量机(SVM)适用于小样本、非线性、高维模式识别问题等。 |

二、部署环境搭建

| 环境要素 | 说明 |

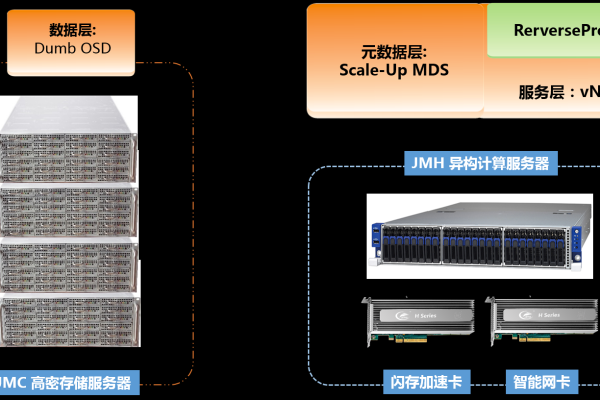

| 硬件配置 | 根据模型的复杂度和性能要求选择合适的硬件设备,对于计算密集型的深度学习模型,通常需要使用高性能的图形处理单元(GPU)或专用的人工智能芯片来加速计算,NVIDIA 的 GPU 系列在深度学习领域广泛应用,能够显著提高模型的训练和推理速度。 |

| 软件平台 | 选择合适的操作系统和相关的软件框架,常见的操作系统有 Linux、Windows 等,Linux 系统在服务器环境下更为稳定和高效,软件框架方面,如 TensorFlow、PyTorch 等是流行的深度学习框架,它们提供了丰富的工具和接口,方便模型的开发和部署。 |

三、模型部署方式

| 部署方式 | 特点 |

| 本地部署 | 将训练好的模型部署在本地服务器或计算机上,这种方式的优点是安全性高、响应速度快,适合对实时性要求较高且数据隐私敏感的场景,企业内部的一些数据分析和预测应用可以采用本地部署的方式,但本地部署需要较高的硬件配置和维护成本。 |

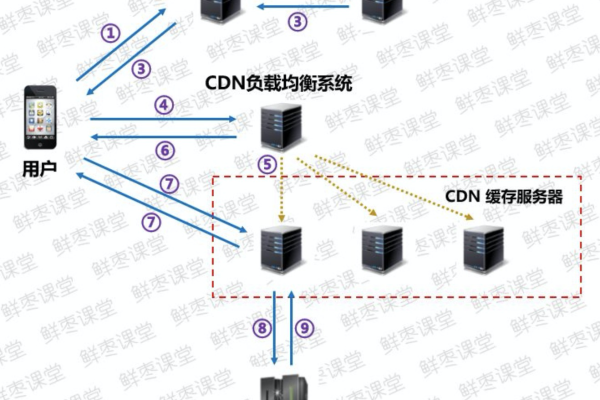

| 云端部署 | 利用云计算平台提供的资源和服务进行模型部署,云端部署具有弹性扩展、成本低、无需关心底层硬件维护等优点,用户可以根据实际需求灵活调整计算资源,按使用量付费,阿里云、酷盾安全等云服务提供商都提供了丰富的机器学习和人工智能服务,方便用户快速部署模型。 |

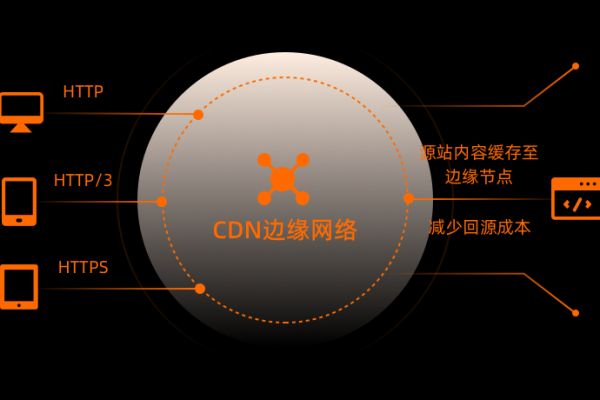

| 边缘部署 | 将模型部署在靠近数据源或用户终端的边缘设备上,如智能手机、物联网设备等,边缘部署可以减少数据传输延迟,提高实时性,同时降低云端的计算压力和带宽需求,在智能安防监控场景中,摄像头可以在本地运行图像识别模型,只将关键信息上传到云端进行进一步处理。 |

四、模型优化与监控

| 优化措施 | 目的 |

| 量化压缩 | 通过减少模型的参数数量和精度,降低模型的存储空间和计算量,同时尽量保持模型的性能,这对于在资源受限的设备上部署模型非常重要,如移动设备和嵌入式系统。 |

| 剪枝优化 | 去除模型中不重要的连接或神经元,以简化模型结构,提高模型的推理速度和效率,剪枝可以在不显著影响模型性能的前提下,大幅减小模型的大小。 |

| 性能监控 | 在模型部署后,持续监控模型的性能指标,如准确率、召回率、F1 值、响应时间等,及时发现模型性能下降或异常情况,以便采取相应的措施进行调整和优化,可以通过日志记录、可视化工具等方式对模型的运行状态进行实时监测。 |

相关问题与解答

问题 1:如果模型在本地部署时性能不佳,可能的原因有哪些?如何解决?

解答:可能的原因包括硬件资源不足,如 CPU 性能不够、内存不足等,导致模型运行缓慢或无法正常运行,解决方法可以是升级硬件设备,增加内存、更换更强大的 CPU 或添加 GPU 加速卡等,也可能是模型本身存在问题,如过拟合或欠拟合,如果是过拟合,可以尝试增加数据量、进行数据增强、调整模型的复杂度(如减少神经元数量、增加正则化项等);如果是欠拟合,可以尝试增加模型的复杂度、调整训练参数(如学习率、训练轮数等)。

问题 2:在云端部署模型时,如何选择合适的云服务提供商?

解答:首先要考虑云服务提供商的计算资源和服务稳定性,确保能够满足模型的运行需求,要关注其提供的人工智能相关服务的丰富程度和易用性,例如是否支持常用的深度学习框架、是否有便捷的模型部署和管理工具等,成本也是一个重要的因素,需要比较不同云服务提供商的价格体系和计费方式,选择性价比高的服务,还可以参考其他用户的评价和口碑,了解其服务质量和技术支持情况。