报错为0的公式

- 行业动态

- 2024-03-22

- 4521

在数学、统计学、工程学以及计算机编程等领域,"报错为0"通常指的是某种计算或算法执行过程中没有出现错误,或者说错误率极低,达到了可以忽略不计的程度,这样的公式可能涉及多种场景,例如最小化误差、优化问题、统计估计等,以下是一个详细的解释,围绕一个具体的例子展开,介绍一个在统计中常用的、旨在将误差降到最低的公式:

在统计学中,线性回归模型被广泛用于预测连续的因变量,其基本形式为:

[ Y = eta_0 + eta_1X_1 + eta_2X_2 + … + eta_nX_n + epsilon ]

( Y )是因变量,( X_1, X_2, …, X_n )是自变量,( eta_0, eta_1, …, eta_n )是模型参数,代表每个自变量的系数,而( epsilon )是误差项,代表模型未能解释的变异。

为了找到这些参数的最佳估计,通常采用最小二乘法(Least Squares Method),该方法的目标是最小化残差平方和,即误差的平方和:

[ S = sum_{i=1}^{N}(y_i hat{y}_i)^2 ]

( y_i )是观察值,( hat{y}_i )是对应的预测值。

为了实现这一目标,我们可以使用以下步骤:

1、对线性回归方程中的参数进行求导,得到偏导数。

2、将偏导数设为0,得到一系列方程,这些方程可以用于解出参数的估计值。

3、这些估计值将给出一个线性模型,其通过最小化误差平方和来生成预测值。

以下是这些步骤的详细解释:

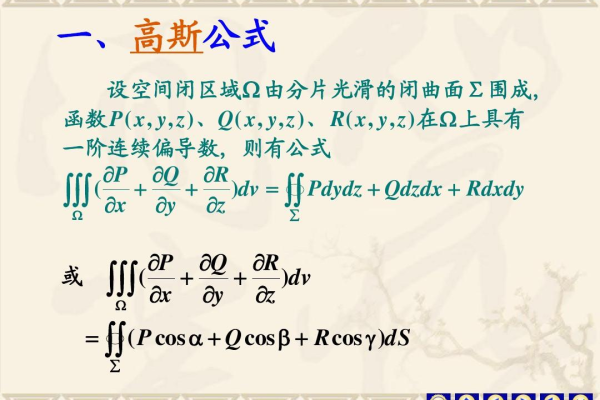

为了找到最小化( S )的( eta_0, eta_1, …, eta_n ),我们需要计算偏导数:

[ rac{partial S}{partial eta_0} = 2 sum_{i=1}^{N}(y_i hat{y}_i) ]

[ rac{partial S}{partial eta_j} = 2 sum_{i=1}^{N}(y_i hat{y}_i)X_{ij} ]

对于( j = 1, 2, …, n )。

接下来,我们将这些偏导数设为0,来解出参数:

[ rac{partial S}{partial eta_0} = 0 ]

[ rac{partial S}{partial eta_j} = 0 ]

解这些方程,可以得到参数的估计值,这些估计值使得残差平方和最小。

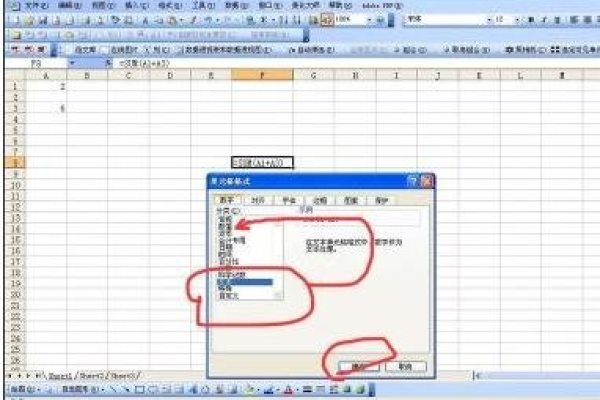

在实现这一过程中,我们可能会遇到数值计算上的挑战,例如矩阵不可逆、数据共线性等问题,但在理想情况下,这些技术问题可以通过适当的数学处理和统计诊断来解决。

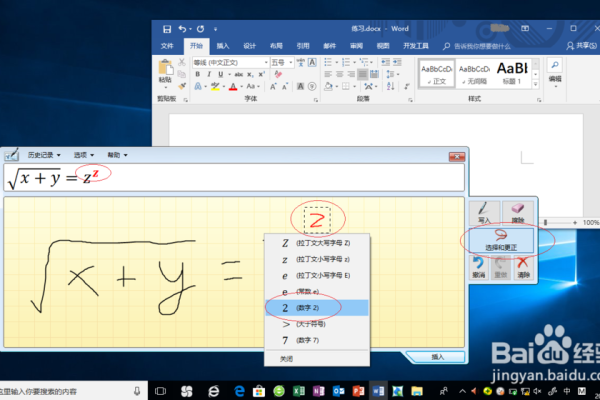

当我们通过这种方法得到的模型在训练集上的预测误差非常低时,可以说这个模型“报错为0”,实际上,这并不意味着模型没有任何预测误差,而是指模型的误差在可接受的范围内,对于实际应用来说,其预测效果是足够好的。

值得注意的是,“报错为0”并不总是最佳状态,在统计学习和机器学习中,有一个概念叫做“过拟合”,即模型对训练数据过于敏感,学到了训练数据中的噪声,导致在新的数据集上表现不佳,我们不仅要追求在训练数据上“报错为0”,还要确保模型具有良好的泛化能力。

为了达到“报错为0”的目标,我们可能需要对数据进行预处理,包括去除异常值、填补缺失值、变量转换等,这些步骤都是为了提高模型的质量和预测的准确性。

在追求“报错为0”的过程中,我们不仅要关注数学和统计方法的选择,还要注意数据的质

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:https://www.xixizhuji.com/fuzhu/199300.html