modelscope-funasr最新代码pt转onnx的模型 比docker 下载的大,正常吗?

- 行业动态

- 2024-04-30

- 1

在深度学习模型转换的过程中,从PyTorch(简称PT)格式转换为ONNX格式是常见的一步,旨在将模型部署到不同的平台上,在这个过程中,可能会遇到转换后的模型大小与原始的Docker镜像有所不同的情况,这种差异可能由多种因素引起,包括模型结构、包含的优化器信息、中间表示形式等,下面我们详细分析这些可能的因素,并探讨它们是否会导致PT转ONNX模型变大。

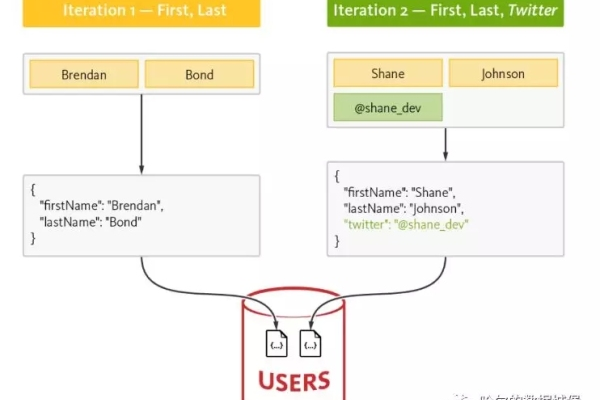

模型结构

PT和ONNX虽然都是用于深度学习的框架,但它们在内部表示模型时使用的数据结构和格式可能不同,某些操作在PT中可能被融合为一个单一操作,而在转换为ONNX时可能需要拆分开来,这会增加模型的大小。

包含的优化器信息

在转换过程中,如果包含了优化器的状态信息,比如权重衰减系数或者学习率调度器的状态,这些都可能导致最终的ONNX模型比原始的Docker镜像大。

中间表示形式

ONNX模型通常包含了更多的中间表示细节,以便于跨框架兼容,这可能导致模型文件本身占用更多的磁盘空间。

其他因素

除了上述因素外,还可能有其他原因导致大小差异,如:

1、依赖库: ONNX模型可能需要额外的库或工具来运行,而这些可能在Docker镜像中已经预安装,但在模型文件中需要显式包含。

2、精度: 如果PT模型使用了混合精度训练,而ONNX不支持这种精度,可能需要转换为全精度表示,这也会增加模型大小。

3、配置文件: ONNX模型可能包含额外的配置文件,这些文件有助于在不同平台上正确地加载和运行模型。

对比分析

为了更直观地展示这些差异,我们可以构建一个简单的表格来比较PT和ONNX模型的特点:

| 特性 | PyTorch (PT) | ONNX |

| 数据结构 | 高度优化的图结构 | 标准图结构 |

| 优化器状态 | 可包含/不包含 | 可能包含 |

| 中间表示 | 可能较为简洁 | 详细的中间表示 |

| 依赖库 | 通常不需要额外库 | 可能需要额外库 |

| 精度 | 可变 | 固定 |

| 配置文件 | 通常不需要 | 可能需要 |

上文归纳

由于多种因素的影响,PT转ONNX的模型比Docker下载的原始镜像大是正常的现象,在实际应用中,应该根据具体的部署需求和平台限制来选择合适的模型格式和大小。

相关问答FAQs

Q1: 如何减小转换后ONNX模型的大小?

A1: 减小ONNX模型大小可以通过以下方法实现:

移除不必要的操作和节点。

使用模型压缩技术,如权重量化或剪枝。

精简或优化模型中的张量形状和数据类型。

Q2: 是否所有PyTorch模型都能成功转换为ONNX格式?

A2: 并非所有的PyTorch模型都能无缝转换为ONNX格式,一些特定的操作或自定义模块可能需要额外的处理才能正确转换,在转换之前,最好查阅相关的ONNX支持文档,确保模型中使用的所有操作都被ONNX所支持。

本站发布或转载的文章及图片均来自网络,其原创性以及文中表达的观点和判断不代表本站,有问题联系侵删!

本文链接:https://www.xixizhuji.com/fuzhu/189575.html