idea中如何创建一个maven项目

- 行业动态

- 2024-02-07

- 6

在IDEA中创建Maven项目,先选择“File”菜单,点击“New”后选择“Project”,然后选择Maven并按提示操作。

创建一个Maven项目是Java开发中的一个重要环节,特别是对于那些使用IntelliJ IDEA集成开发环境(IDE)的开发者来说,Maven是一个项目管理和综合工具,它提供了一种标准化的方式来构建项目,管理依赖关系,运行测试以及其他任务,以下是在IntelliJ IDEA中创建Maven项目的详细步骤:

打开IntelliJ IDEA

启动IntelliJ IDEA,假如你已经有一个打开的项目,你可以通过点击“File”菜单然后选择“New” > “Project…”来创建一个新的项目。

选择Maven Project

在打开的项目向导中,你会看到多种类型的项目可以选择,为了创建一个Maven项目,你应该选择“Maven”选项,通常这个选项会在列表的顶部或者靠近顶部的位置。

配置项目信息

选择了Maven项目类型后,你需要填写一些基本信息来配置你的项目,这包括:

1、GroupId: 这是项目的组织标识符,通常是公司或组织的域名反转形式,如com.example。

2、ArtifactId: 这是项目的唯一基本名称,通常是项目的名称。

3、Version: 这是项目的版本号。

4、Archetype: 选择一个预设的项目结构,对于大多数Java项目,可以选择"maven-archetype-quickstart"。

还有,你可以设置项目的路径、位置和其他选项。

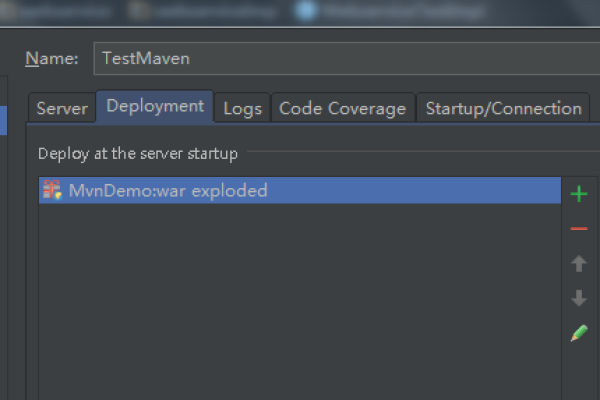

完成项目创建

填入所有必要的信息之后,点击“Next”进入最后的确认页面,检查所有的配置信息是否正确,然后点击“Finish”,IntelliJ IDEA将会创建一个Maven项目,并且自动下载所有必要的依赖项。

探索新创建的Maven项目结构

项目创建成功后,你可以探索自动生成的项目结构,一个典型的Maven项目包含以下目录和文件:

src/main/java: 这里放置项目的主代码。

src/test/java: 这里放置单元测试代码。

pom.xml: 这是Maven的项目对象模型文件,用于声明项目信息、依赖项、插件等。

开始开发

现在你可以开始在项目中编写代码了,通过编辑src/main/java目录下的Java文件,并添加新的类和包,你可以开始构建你的应用程序。

使用Maven命令

通过IntelliJ IDEA的终端或外部的命令行工具,你可以运行Maven命令来构建项目、运行测试、打包应用等,输入mvn clean install会清理之前的构建产物,并安装项目到本地Maven仓库。

相关问题与解答

Q1: 什么是Maven的GroupId, ArtifactId和Version?

A1: GroupId是组织的唯一标识符,ArtifactId是项目的唯一名称,Version是项目的版本号,这三者共同定义了一个唯一的项目坐标。

Q2: 我该如何修改Maven项目的POM文件?

A2: 你可以直接在项目的pom.xml文件中进行编辑来添加或修改依赖、插件等配置。

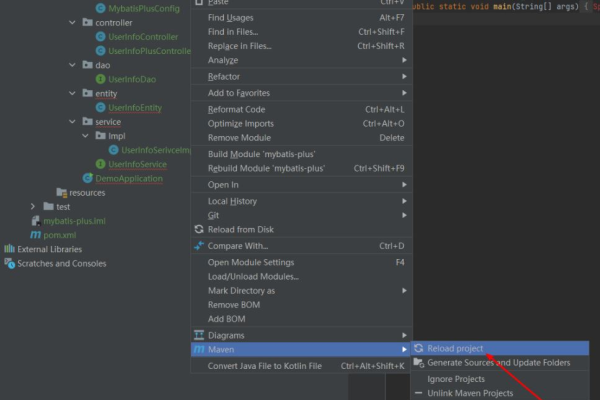

Q3: 如果我想在IntelliJ IDEA中导入一个现有的Maven项目应该怎么办?

A3: 你可以选择“File” > “Open”来打开一个现有的项目目录,或者通过版本控制系统(如Git)检出项目代码。

Q4: 如何运行Maven项目的单元测试?

A4: 你可以使用mvn test命令来运行项目中定义的所有单元测试,在IntelliJ IDEA中,也可以使用内置的测试运行器来执行测试。